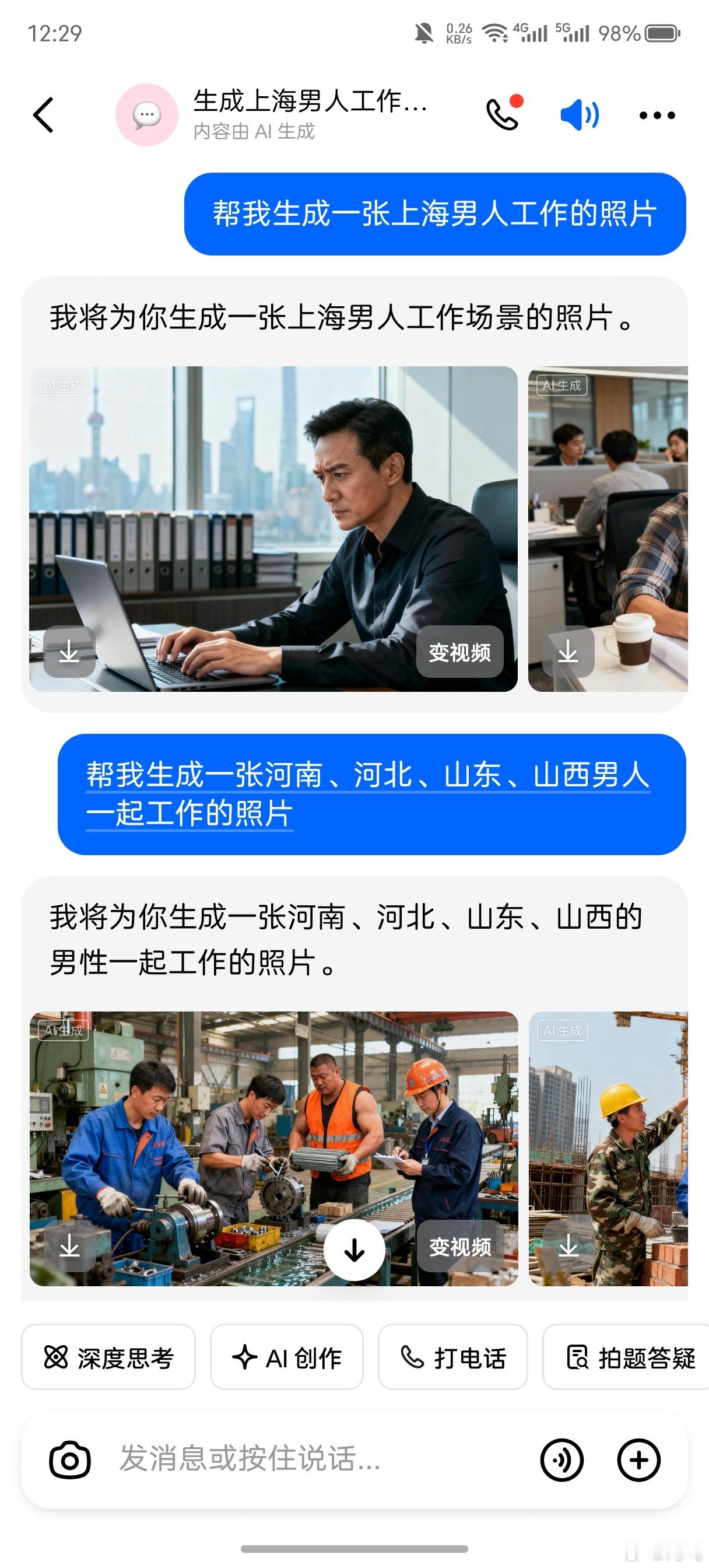

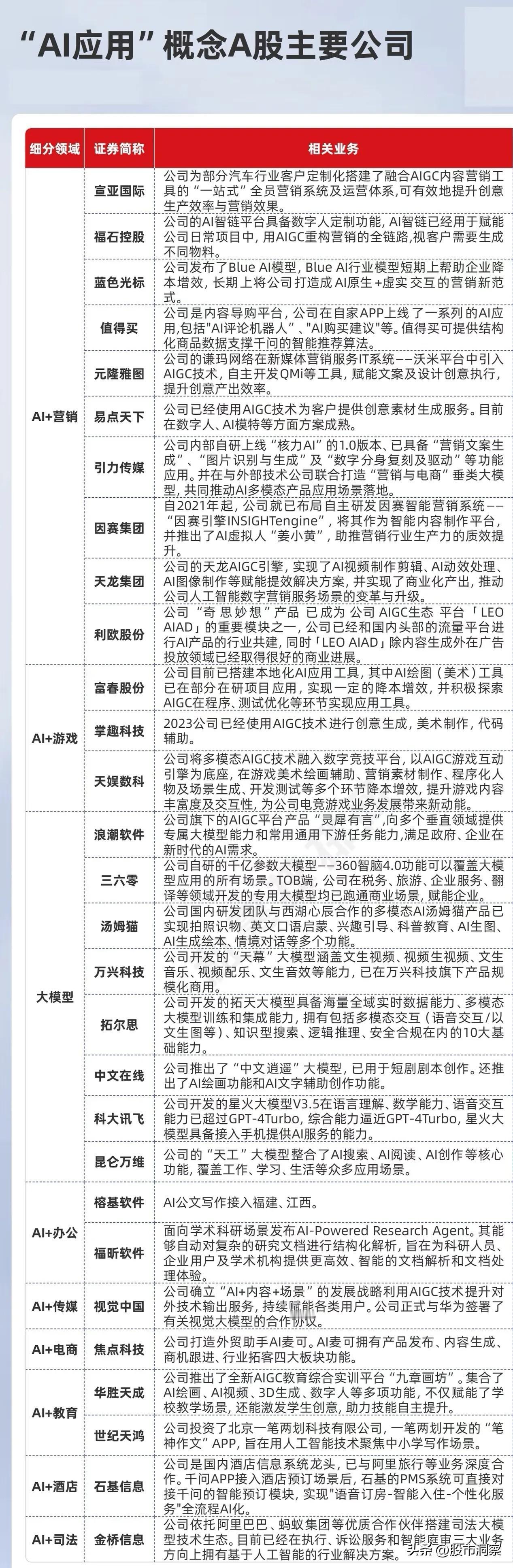

一、 个人与社会层面:权利、公平与信任的侵蚀 1. 隐私的终结与监控过度 · 后果:政府和公司可以利用AI进行大规模人脸识别、行为分析和数据挖掘,构建“透明人”社会。个人的行踪、社交关系、甚至情绪状态都可能被实时监控,思想与行为自由将受到严重压制。 · 实例:基于社会信用体系的惩罚、针对特定种族的精准监控。 2. 算法歧视与系统性不公 · 后果:如果训练数据本身存在偏见,AI会放大并固化这些偏见,导致在招聘、信贷、司法判决等领域出现系统性歧视。这会加剧社会分裂,让弱势群体更难翻身。 · 实例:AI招聘系统更倾向于男性求职者;司法算法对特定种族给出更长的刑期建议。 3. 信息失真与认知操纵 · 后果: · 深度伪造:可以制造政治家、名人发表不实言论的逼真视频,用于舆论攻击、操纵选举、引发社会动荡,严重破坏社会信任。 · AI生成虚假信息:AI可以大规模、自动化地生成难以辨别的虚假新闻和网络评论,淹没真实信息,扭曲公众认知。 4. 经济冲击与就业失衡 · 后果:自动化导致大规模结构性失业,特别是重复性、程序化的白领和蓝领工作。同时可能催生“无用阶层”,引发严重的社会和经济问题。财富也可能进一步向掌握AI技术的少数巨头集中。 二、 安全与军事层面:从犯罪到战争的颠覆 1. 自主武器系统与“杀手机器人” · 后果:将生死决策权交给机器,可能引发新一轮军备竞赛。AI武器系统可能存在不可预测的故障或被黑客劫持,导致误伤平民、甚至意外引发地区冲突或世界大战。降低战争门槛,让武力冲突更易发生。 2. 网络攻击的超级进化 · 后果:AI能自动发现并利用软件漏洞,发动前所未有的、复杂且大规模的网络攻击,目标可以是关键基础设施(电网、水网、金融系统),造成社会瘫痪。 3. 新型犯罪模式的涌现 · 后果:AI使网络诈骗(如模仿亲人声音视频)、黑客攻击、勒索软件等犯罪活动的效率和成功率急剧提升,同时降低了犯罪的技术门槛。 三、 全球与伦理层面:人类共同体的挑战 1. 社会信任体系的崩塌 · 后果:当人们无法分辨线上信息的真伪、担心一言一行都被记录分析、感觉社会系统对自己不公时,人与人之间、民众与机构之间的基本信任将荡然无存,社会合作的基础将被动摇。 2. 人类能动性与创造力的衰退 · 后果:过度依赖AI进行决策、创作(写作、绘画、作曲)和思考,可能导致人类批判性思维、解决问题能力和创造力的集体退化。我们可能从“AI的使用者”变为“AI的附庸”。 3. 全球治理的失控与失衡 · 后果:AI技术发展极不平衡,可能加剧国家间的“技术鸿沟”,导致地缘政治格局的洗牌。在缺乏全球性监管条约的情况下,AI军备竞赛和恶性竞争难以避免。 应对之道:在创新与监管之间寻求平衡 面对这些严峻风险,我们不能因噎废食,而应主动构建防护网: · 技术层面:研发可解释AI、联邦学习、偏见检测与消除等技术,让AI更透明、更公平。 · 法律与监管:建立严格的数据保护法(如GDPR),制定AI伦理准则,对高风险AI应用进行强制审计和认证,并推动国际社会就禁止自主致命武器等议题达成协议。 · 企业与机构责任:将“伦理设计”融入AI开发全流程,建立内部伦理审查委员会,保持技术应用的透明度。 · 公众教育与素养:提升全民的数字素养和AI认知,让公众了解AI的能力与局限,学会批判性地看待AI的产出。