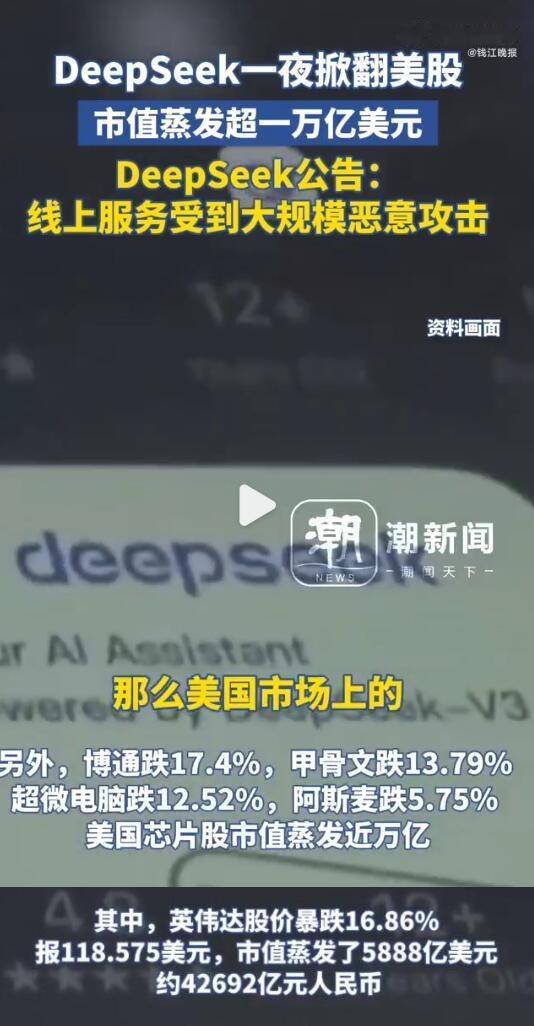

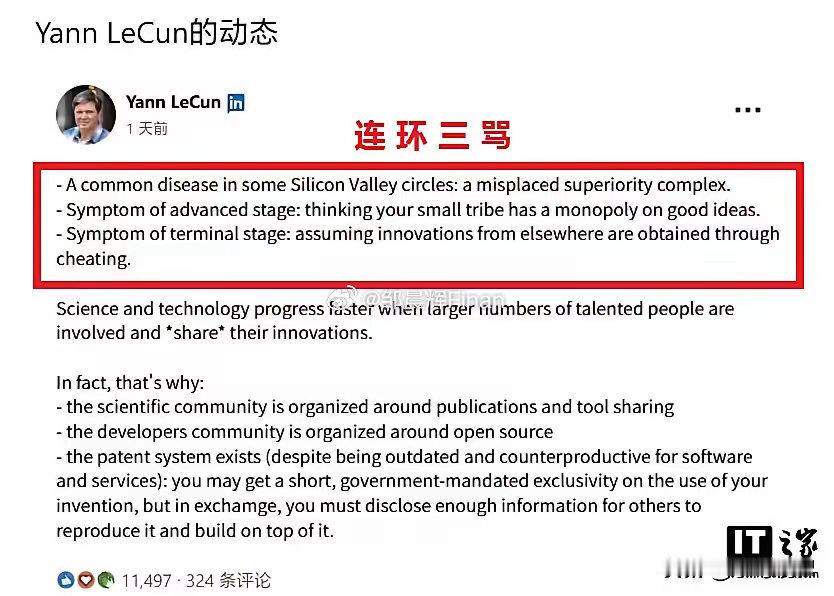

幻方量化不断扩展计算平台支持DeepSeek赶上GPT5 openAI称目前领先DeepSeek有3-6个月。 幻方建立数据平台,限制H100后,从浪潮购入装H800的服务器(北美数据中心大量使用浪潮服务器),H800算力与H100相当,但通信能力减弱,组成GPU阵列小,这样DeepSeek用于训练大模型的只有2000块H800GPU,训练总参数只有GPT4的20%。 也有装A100服务器 ,128块GPU,用于训练多模态。 用华为910B建立推理服务器,未用英伟达H20。 DEEPSEEK正在用光通信互联芯片,量子算法安全,GPU集成电路训练,赶上GPT5 一动用现成储存的GPU,有5万块H100说法,有GPT5的一半。但是幻方也自己用于量化交易。 二可能是类中国科学院计算技术研究所开发晶圆芯片,采用22nm工艺,通过chiplet技术和risc5架构,形成超过1万亿个晶体管集成电路。类似META的MTIA晶圆芯片,是ASIC芯片,但采用5纳米工艺。 三另一个可能是华为910C系列,用光纤连接扩展接近H100服务群。 美国英伟英伟达Blackwell超级芯片,有两块集成块连接有2千亿晶体管,能运行2000亿参数级别的AI模型,可能交付OPENAI用于gpt5 知识蒸馏,剪枝,量化这些降低计算要求的算法在通用大模型都是常用的,包括推理模型,有现成的调用架构可用。DeepSeek 用得更出色,大模型核心注意力算法开发出空间折叠算法。 估计DeepSeek还是是通用训练,算力不够,策略优化,训练时数据分解为一部份一部份逐步训练,采用混合专家模型分解数据,2023年开始逐步优化的结果。用H800训练可以调用现成架构。 华为芯片架构不通用,华为加紧移植PYTORCH架构到910系列上。 阿里也力争不太落后于GPT5。 这样DeepSeek GPT5 meta 阿里 Anthropic Google竞争AI未来 ,年底见分晓。

幻方量化不断扩展计算平台支持DeepSeek赶上GPT5 openAI称目前领

糖果杠历史

2025-02-01 15:35:10

0

阅读:135

你没剃胡子

犹 太阿 里有姜 萍,有如妖助!