IT之家12月17日消息,今日,腾讯混元世界模型1.5(TencentHYWorldPlay)正式发布。官方称,混元世界模型1.5(WorldPlay)首次开源了业界最系统、最全面的实时世界模型框架,涵盖数据、训练、流式推理部署等全链路、全环节,并提出了重构记忆力、长上下文蒸馏、基于3D的自回归扩散模型强化学习等算法模块。

IT之家附官方介绍如下:

世界建模的新突破:实时交互、前后一致

混元世界模型1.5带来世界建模的全新可能性,用户可以在生成的世界里随意移动探索,离开某个区域后再次返回时,模型能够"记住"该区域的三维结构,呈现前后一致的场景——这种空间记忆能力标志着模型在三维世界理解上的突破。此外,用户还可以选择将用于交互的3D场景导出为可多次使用的3D点云。

混元世界模型1.5具备三大核心能力:

1、实时的交互生成:通过原创的ContextForcing蒸馏方案以及流式推理优化,模型可以按照24FPS的速度生成720P的高清视频;

2、长范围的3D一致性:通过重构记忆机制(ReconstitutedMemory),模型支持分钟级内容的几何一致性生成,可用于构建高质量的3D空间模拟器;

3、多样化的交互体验:混元世界模型可广泛适用于不同风格的游戏或者现实场景,以及第一和第三人称视角,也支持实时文本触发事件和视频续写等功能。

业界最系统、最全面的实时世界模型训练体系首次开源

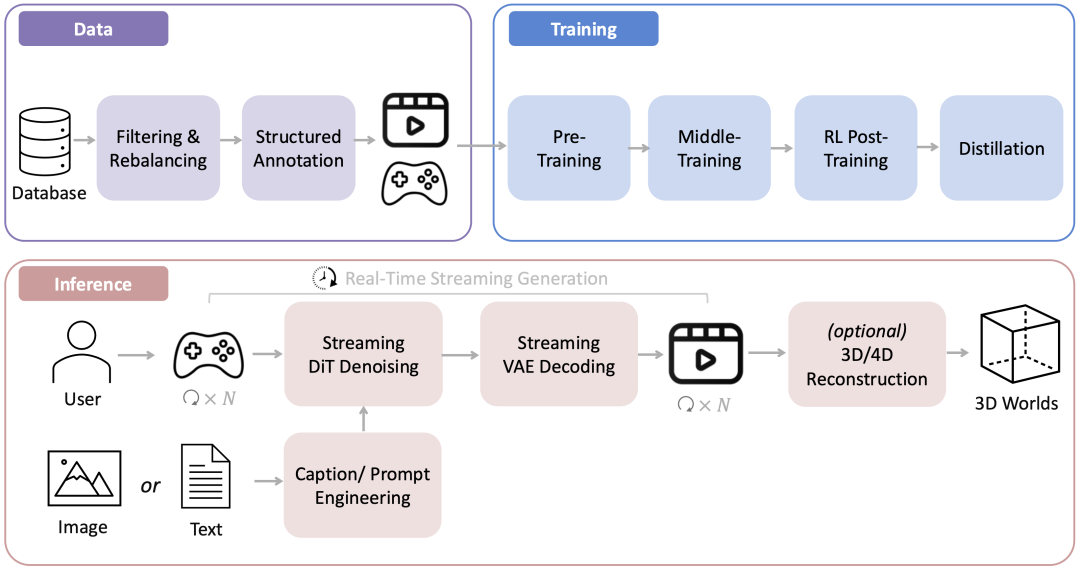

技术上,混元世界模型1.5首次开源了业界最系统、最全面的实时世界模型训练体系,涵盖数据、训练、推理部署等全链路、全环节。混元团队在技术报告中公开了模型预训练、持续训练、自回归视频模型强化学习、带记忆力的模型蒸馏的训练细节,并详述模型在控制(controlspace),记忆(reconstitutedmemory),蒸馏(contextforcing),强化学习后训练几大模块上的思考与原创设计。

混元世界模型1.5的核心是一个叫做WorldPlay的自回归扩散模型,它采用Next-Frames-Prediction的视觉自回归任务进行训练,实现了长范围几何一致性的实时交互式世界建模,破解了业界满足实时性与几何一致性的难题。

该模型依托三大核心创新:双分支动作表征实现精准控制、上下文记忆重构机制保持几何一致性、上下文对齐蒸馏技术增强长视频生成的视觉质量和几何一致性。除此之外,该工作也构建了一套新颖的基于3D奖励的强化学习后训练框架来进一步增强生成视频的视觉质量和几何一致性。数据方面,混元团队构建的自动化3D场景渲染流程,可以获得大量高质量的真实世界渲染数据,进一步激发核心算法的潜力。混元世界模型1.5可支持24帧/秒的长时流式生成,一致性与泛化能力适用于多样化场景。

腾讯混元团队持续深耕世界模型技术。今年7月,腾讯混元团队发布混元3D世界模型1.0,支持文本或单张图片输入生成兼容图形学管线的3D场景;10月,混元团队发布世界模型1.1,支持多视图或视频一键创造3D世界。此次发布的混元世界模型1.5进一步带来了世界建模的全新可能性。

世界模型的演进和迭代不仅是技术上的突破,也打开了“AI生成内容”的想象空间:未来的AI不只是生成文本、图像或视频等模态,而是创造实时探索、可交互、空间一致的完整“世界”。

这种全新的内容生成模式,可以应用在多个场景中:在AI游戏开发领域,它可以作为智能关卡生成器,根据玩家的文本描述实时创建可探索的游戏世界;在影视制作和虚拟现实(VR)领域,创作者通过简单的文本指令,就可以快速预览和迭代场景设计;在具身智能(EmbodiedAI)研究领域,混元世界模型1.5提供了一个理想的训练和测试平台,研究者可以通过借助这个平台,以更高的效率、更大的规模,去探索具身智能体的感知、决策、规划和长期交互能力。

在线体验网站:https://3d.hunyuan.tencent.com/sceneTo3D?tab=worldplay

Github链接:https://github.com/Tencent-Hunyuan/HY-WorldPlay

HuggingFace链接:https://huggingface.co/tencent/HY-WorldPlay

项目主页:https://3d-models.hunyuan.tencent.com/world/