OpenAI推出推理模型o3mini

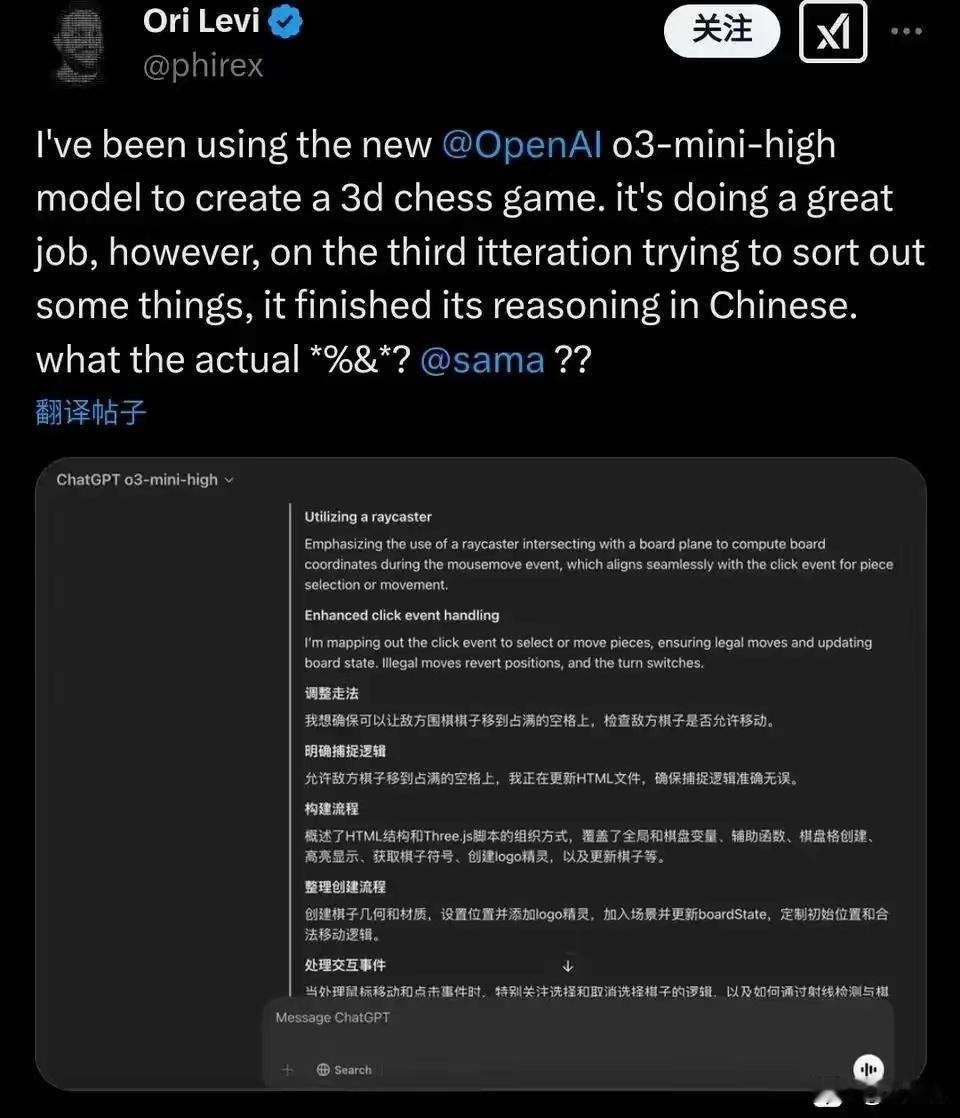

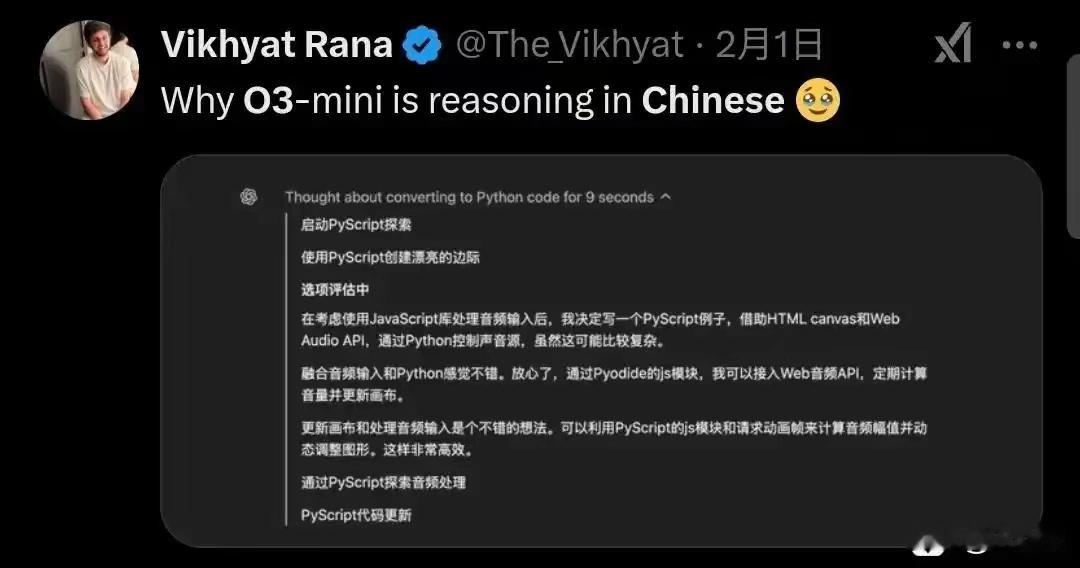

一些用户发现o3-mini用中文思考,这是正常的。但说明OpenAI着急上线,没有消除这种现象就发布了

在deepseek论文中,就说了R1-zero训练中的语言混合现象。这是因为,“思考”是机器输出给自己看,而且是强化学习直接生成的,不是模仿预先准备的思考模板。

大模型学习的语料里,有大量中文和英文的资料。在数据结构里,英文和中文都统一转成了token,不明确区分是什么语言。例如deepseek v3有超过12万种token,包含多国语言。

而“思维链”也是一个token接一个token计算输出的。o3mini学习的逻辑本来就是有一部分是中文语料里的,计算时吐出一个中文token很正常。就如deepseek r1-zero思考会出英文,多国语言混合,对人类来说可读性不佳。

但是人们看deepseek r1的思考没有这种现象,是因为deepseek又把r1-zero,继续训练提升为r1,提高了可读性。在训练中,明确要求思维链里的机器语言一致,解决了这个问题。人们用的都是r1,而不是r1-rero,所以没发现语言混合现象。

而OpenAI仓促推出o3-mini,模仿了r1-zero的思维链和语言混合,但是没时间去训练语言一致性,就在压力下上线了。结果就是被人们测试出,用中文思考了。