[CL]《Early Stopping Chain-of-thoughts in Large Language Models》M Mao, B Yin, Y Zhu, X Fang [University of Delaware & Peking University] (2025)

ES-CoT:大规模语言模型链式思维推理的高效早停策略

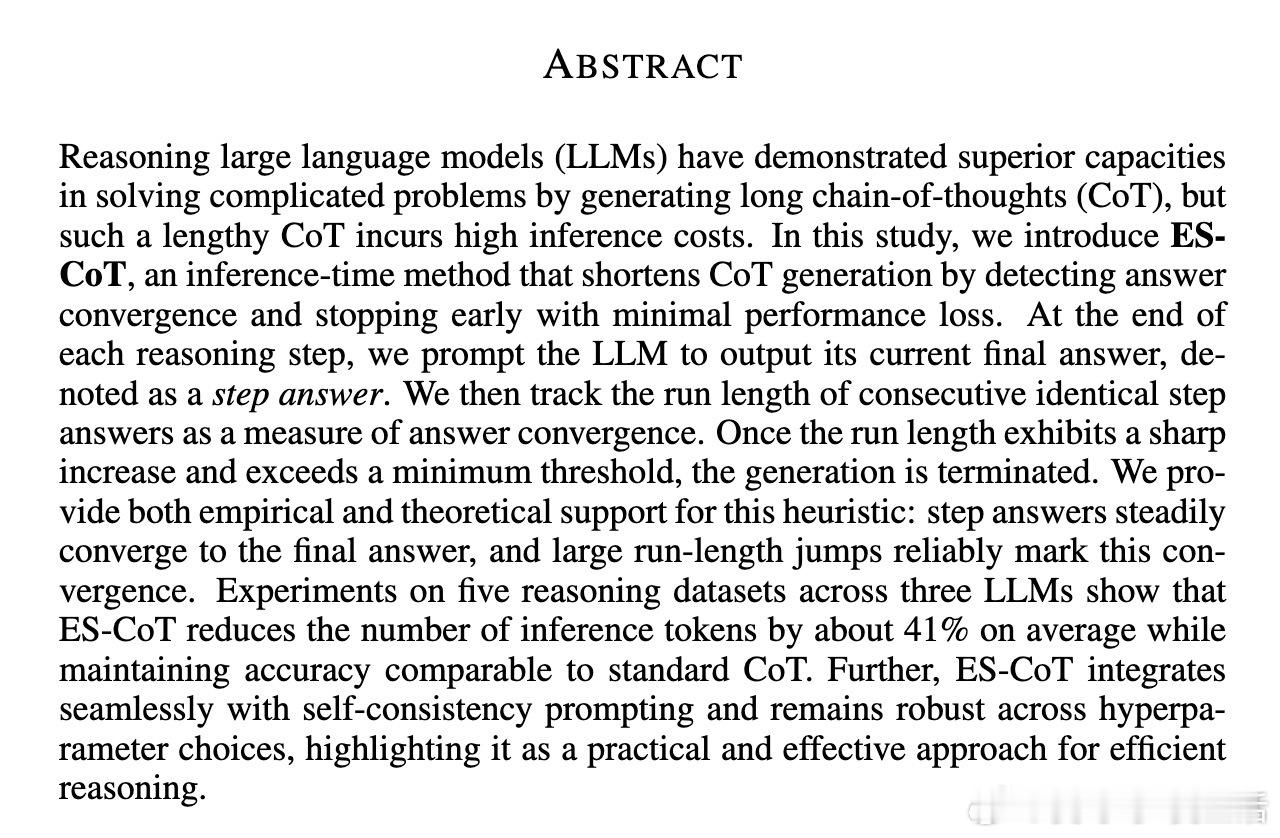

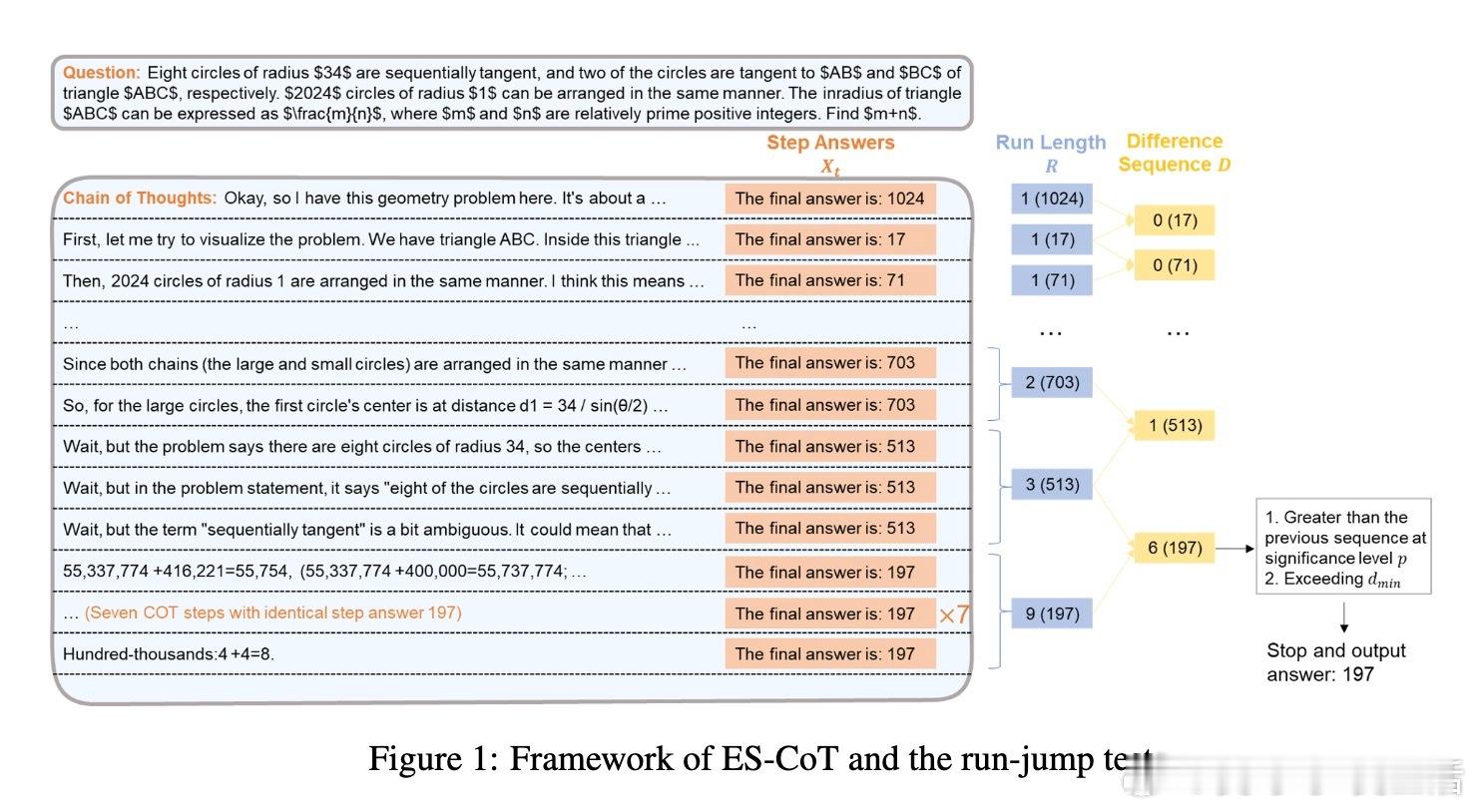

• ES-CoT 利用模型在每一步推理结束时输出当前“step answer”,通过监测连续相同答案的运行长度(run length)变化来判断答案收敛。

• 核心机制是“run-jump test”:当连续相同答案的运行长度出现显著且超过阈值的跳跃时,推理过程即提前终止,输出当前答案作为最终结果。

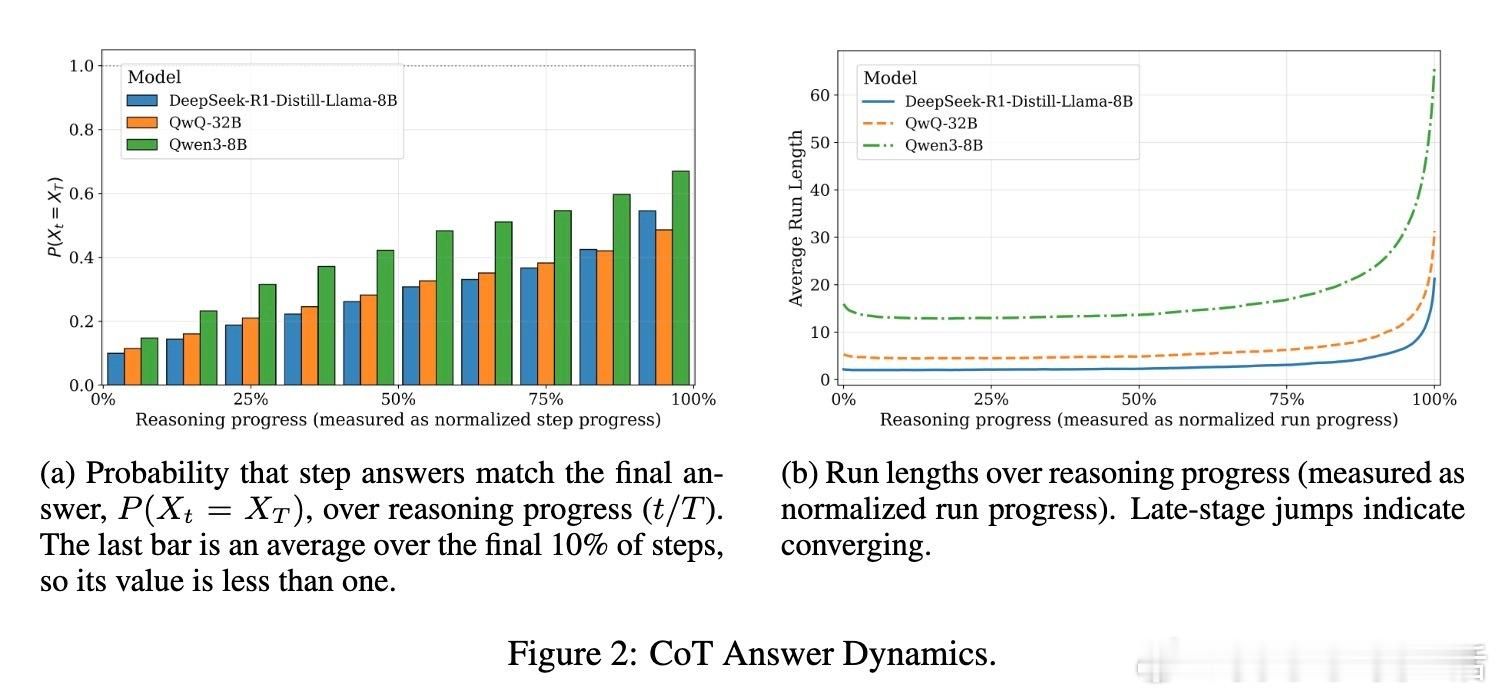

• 理论证明和实证分析表明,step answers 随推理进展单调趋近最终答案,且大幅运行长度跳跃是答案稳定的重要信号。

• 在五个数学与逻辑推理数据集、三款不同规模LLM上测试,ES-CoT 平均减少推理token数约41%,同时保持与标准CoT相当的准确度。

• ES-CoT 无需额外训练、奖励模型或并行解码,操作简便,且可无缝结合自洽性提示(self-consistency),进一步提升性能与效率。

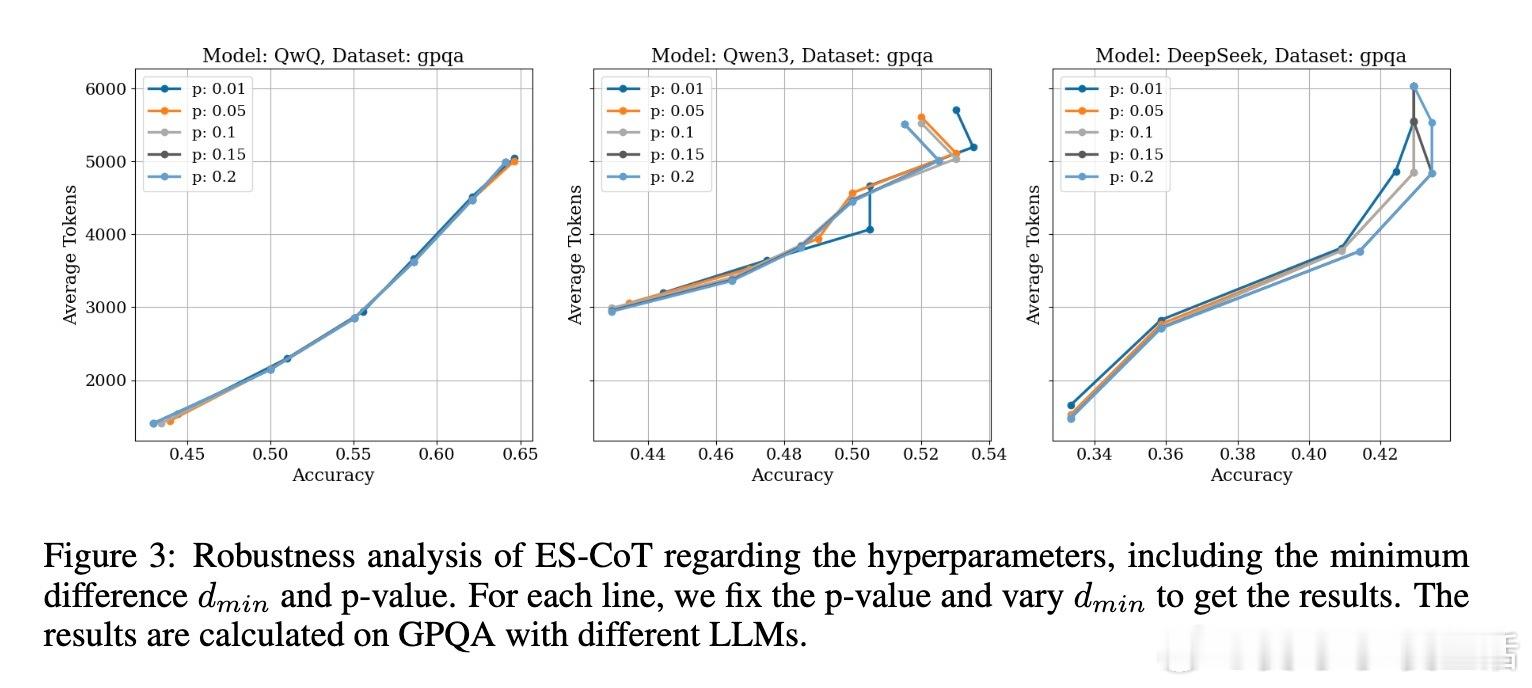

• 超参数敏感度低,尤其对阈值参数表现出良好鲁棒性,可根据场景灵活调节精度与推理成本的权衡。

• 该方法有效减少冗余思考,缓解推理模型的内存和延迟压力,显著提升实际应用中的推理效率。

心得:

1. 语言模型推理过程中的答案动态趋势可作为高效推断的直接依据,摆脱了对复杂奖励模型的依赖。

2. 通过统计显著的“运行长度跳跃”发现推理稳定点,体现了模型内部自信心的自然升华,提升了早停决策的可靠性。

3. 结合自洽性提示机制时,ES-CoT 不仅保持了效率优势,还能进一步提高准确率,展示了推理优化策略的协同潜力。

详情🔗 arxiv.org/abs/2509.14004

大规模语言模型链式思维推理优化早停策略人工智能