曾发布经典 AI Agent 指南的谷歌高级总监再次出手,带来一份长达 171 页的 LLM 白皮书,堪称目前最全面、最系统化的 LLM 学习文档。

这份文档不仅是知识的集合,更是一张从核心原理到前沿架构的完整技术地图,覆盖了 LLM 领域的几乎所有关键节点。

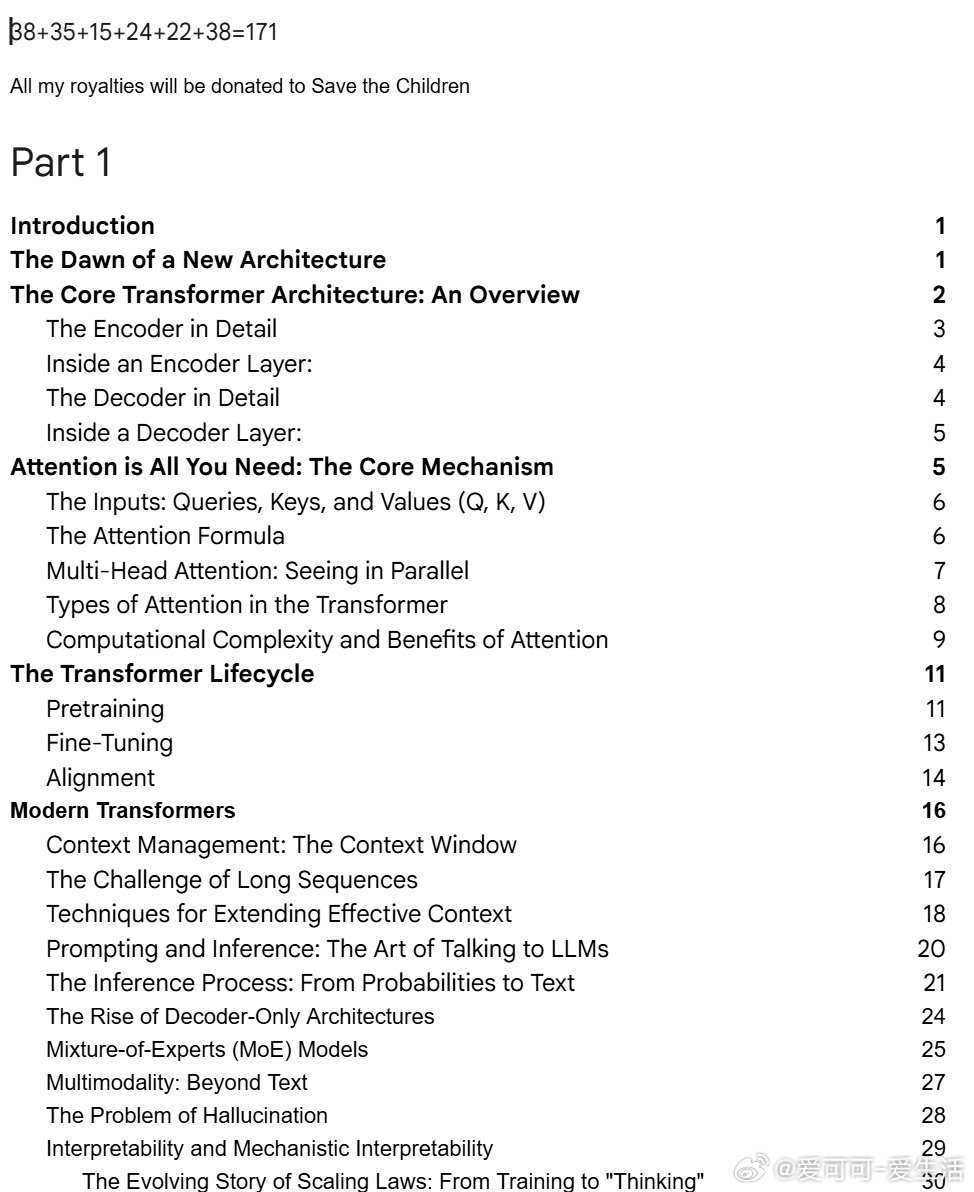

文档核心结构:

- Part 1: 基础原理 🏗️

从 Transformer 的开山之作“Attention is All You Need”讲起,深入浅出地剖析了 Encoder/Decoder、多头注意力机制、Scaling Laws 等基础,并延伸至上下文窗口管理、MoE、多模态等现代架构的核心概念。

- Part 2: 推理与对齐 🤖

系统梳理了从思维链 (CoT) 到思维树 (ToT) 的高级推理范式演进,并详细拆解了 RLHF、RLAIF、DPO 等关键的对齐技术,解释了模型如何学会“思考”并与人类价值观对齐。

- Part 3 & 4: 核心技术与代码实现 🛠️

不仅逐行拆解了基础 Transformer 的代码实现,还对 MoE、GQA (Grouped-Query Attention)、RoPE (Rotary Position Embeddings)、KV Caching 等现代 LLM 赖以成功的关键优化技术,进行了原理与代码的双重解读。

- Part 5 & 6: 前沿架构与源码剖析 🔍

全面评述了 2025 年各大厂商的旗舰模型架构,包括 DeepSeek-V3、Llama 4、Gemma 3、Qwen3 等,并以 Google 开源的 Gemma 3 为例,进行了源码级的深度剖析。

这不仅是一份文档,更是一位资深从业者为你精心绘制的 LLM 技术全景图。

文档链接🔗 docs.google.com/document/d/1WUk_A3LDvRJ8ZNvRG--vhI287nDMR-VNM4YOV8mctbI/edit

LLM 大语言模型 人工智能 Transformer 深度学习 技术文档