现在大语言模型所说的 Token 其实应该对应的是语言学中的 Morpheme

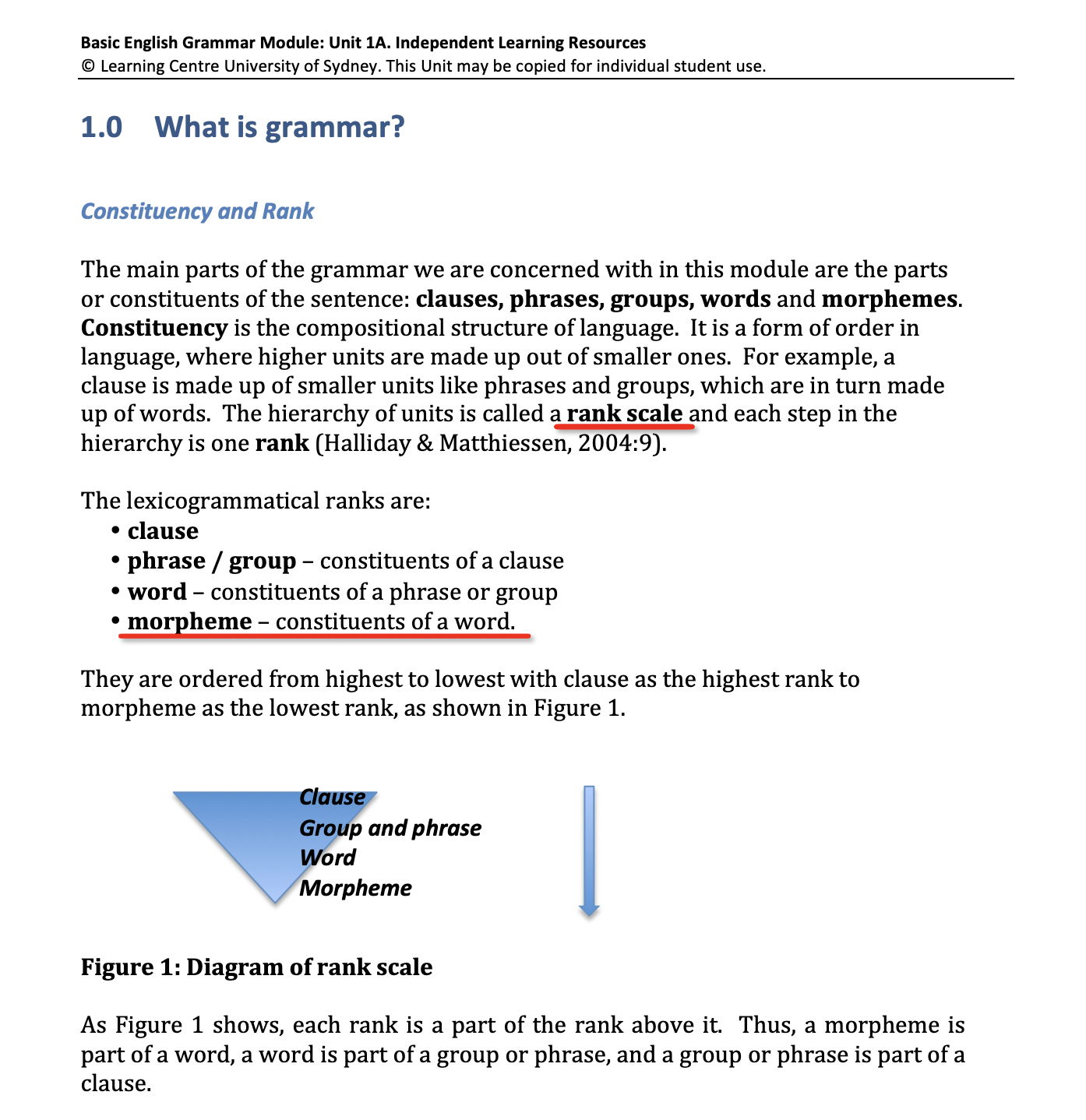

按语言学的解释,Morpheme 就是字的成分,Constitients of a word (图一)

比如,Glovalozation 就是由四个 Morpheme 构成的,分别是 glob, al, is, ation (图二)

但是为何大语言模型不说是 Morpheme ,而叫做 Token 呢? 这就非常令人费解了,难道搞语言模型的人不懂语言学? 这就非常搞笑了?

那么这个对应中国的什么呢?

我认为应该是部首,比如 赢,是由五个部首构成的,分别是 亡,口,月,贝,凡

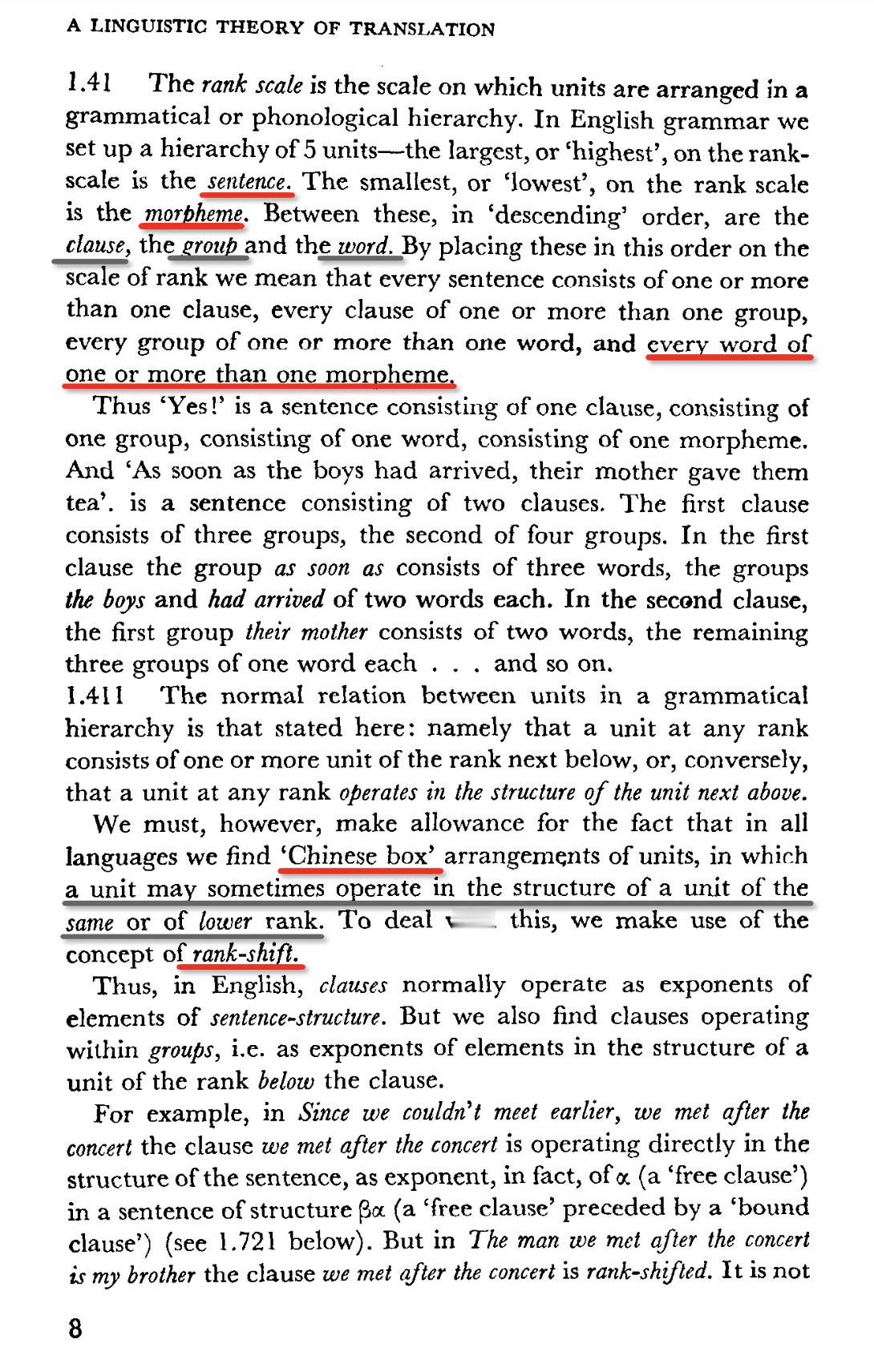

在1965年出版的一本 A Linguistic Theory of Translation,就同样提到了现代的语言学结构,rank level

有意思的是,它把高层级的结构与低层级的结构相似的 Rank shift 现象称为 Chinese Box,中国盒子,非常明显,这种结构其实就是俄罗斯套娃,或者也可以称为分形,但是为什么不用 Russian Dolls 而是 Chinese Box 呢?

我查了一下,Chinese Box 指的其实是唐代所盛行的装佛祖舍利子的佛龛 (图四),它就是套盒,可能有七到九层

没想到吧?

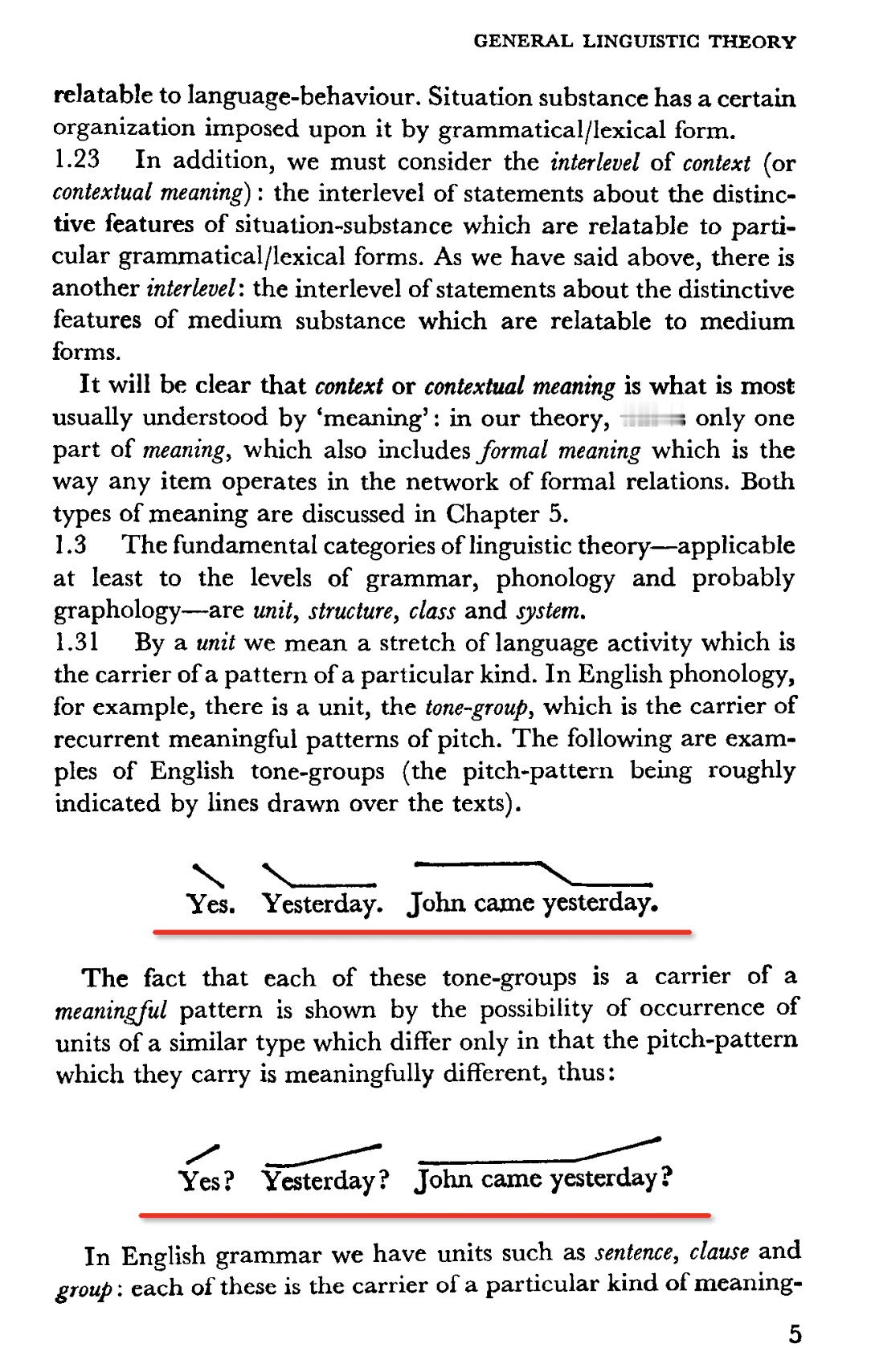

此书中还提到了一种语调结构(图五),这种结构我不会联想到英文的语调,但是却很容易想起中国古代的平仄

.