阿里云又放大招,Qwen2.5-Max震撼发布!作为超大规模的专家混合模型(MoE),预训练数据量超20万亿Tokens,真猛啊!

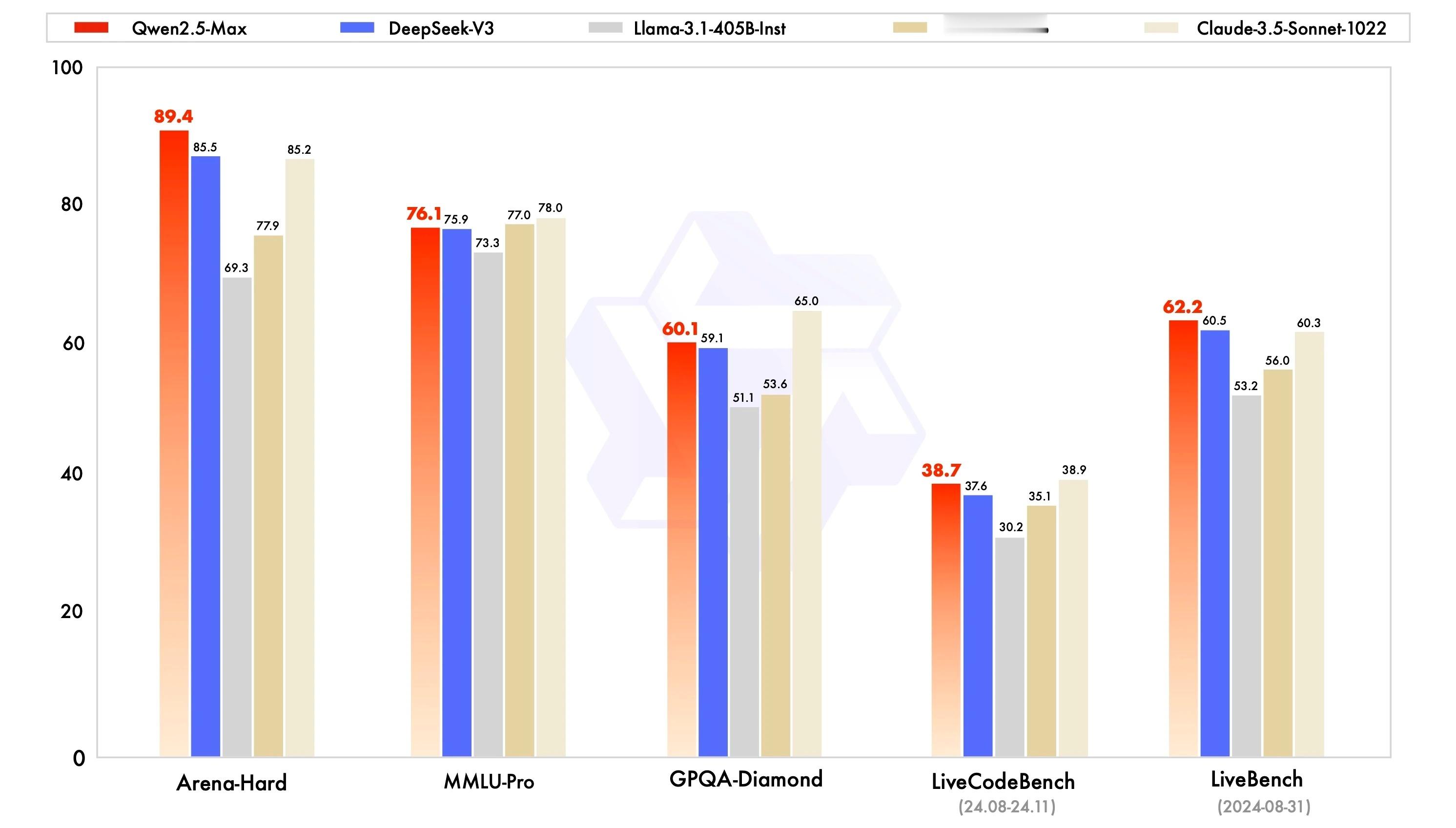

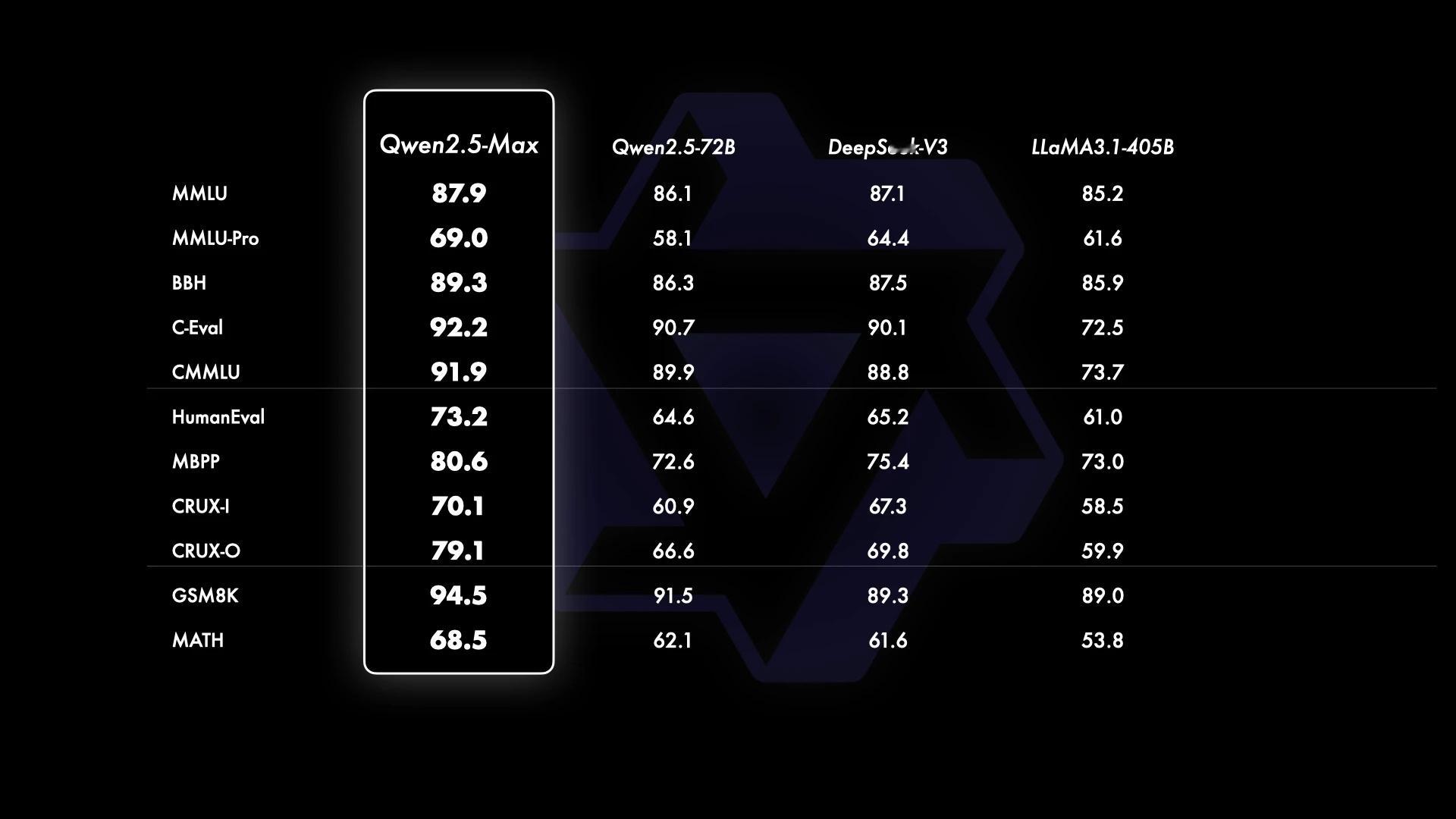

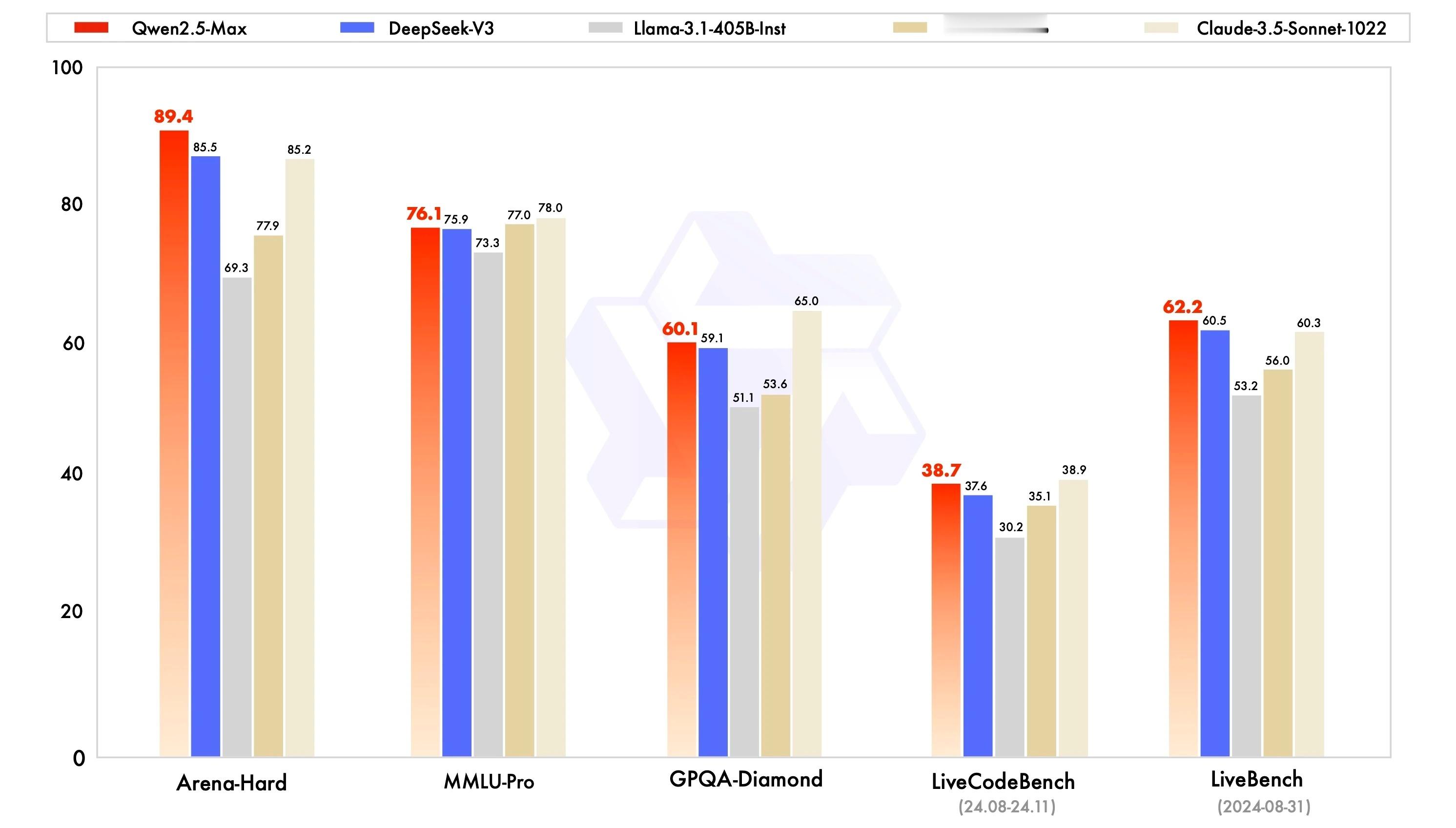

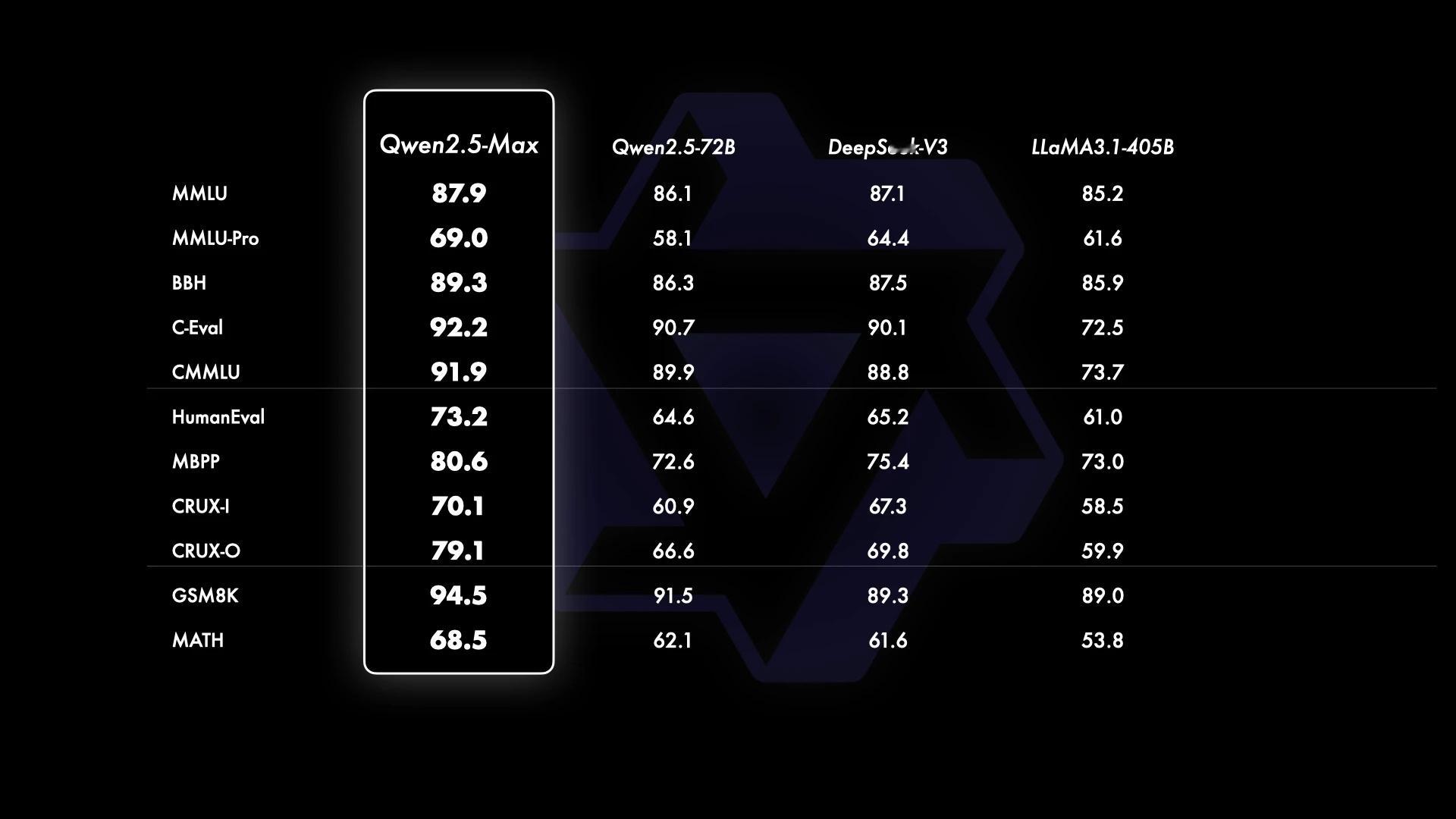

在多个主流评估里直接把当前最大开源密集模型Llama-3.1-405B和MoE模型DeepSeek V3全面超越了,性能更是和GPT-4o、Claude-3.5-Sonnet平起平坐~

更让人惊喜的是,现在大家能在Qwen Chat免费体验,阿里云还通过百炼平台对外服务,科技迷们别错过,赶紧去试试!

阿里云又放大招,Qwen2.5-Max震撼发布!作为超大规模的专家混合模型(MoE),预训练数据量超20万亿Tokens,真猛啊!

在多个主流评估里直接把当前最大开源密集模型Llama-3.1-405B和MoE模型DeepSeek V3全面超越了,性能更是和GPT-4o、Claude-3.5-Sonnet平起平坐~

更让人惊喜的是,现在大家能在Qwen Chat免费体验,阿里云还通过百炼平台对外服务,科技迷们别错过,赶紧去试试!

猜你喜欢

作者最新文章

热门分类

科技TOP

科技最新文章