我最近在阅读很多人工智能相关的文献,推荐大家可以读一篇最近几天才发布的论文 noise_step,这篇论文其实连内容写的都不是非常规范,不像是一个非常严肃的研究性论文,而且也没有给出实际训练出来的模型性能的对比

但是我仔细读了此文以及回溯了一些历史,会发现他使用的技术实际上可以用压缩感知来解释,他的这篇论文也是受微软最近一个团队发表的 BitNet 1..58 bit 的论文启发,使用{ -1,0,1}三元编码,一方面可以大量降低内存占用,另一方面可以大幅降低算力消耗

压缩感知技术是一个非常反直觉的技术,它在 2005,2006年就完成了数学理论证明了,即通过少量的,非精确的数据就可以准确恢复出来原信息,当然,前提是原信息需要是稀疏,低秩的,而这恰好在图像,自然语言处理在非常常见,甚至可以说是自然天性

另外,此论文还提出了不用反向传播的技术,这依然是一个与现在主流非常逆反的想法,但是很可能也是对的,因为在神经元组织中其实就没有这种反向传播的证据,而取消反向传播也会大幅降低算力

最后,我们应该认真阅读一下维纳的「控制论」和「人有人的用处」,后者就提到,最关键的信息其实就是结构性信息,你可以称它为模式

通信传输实际上就是要传输这个模式,这种结构信息就可以了,就可以精确重建原信息

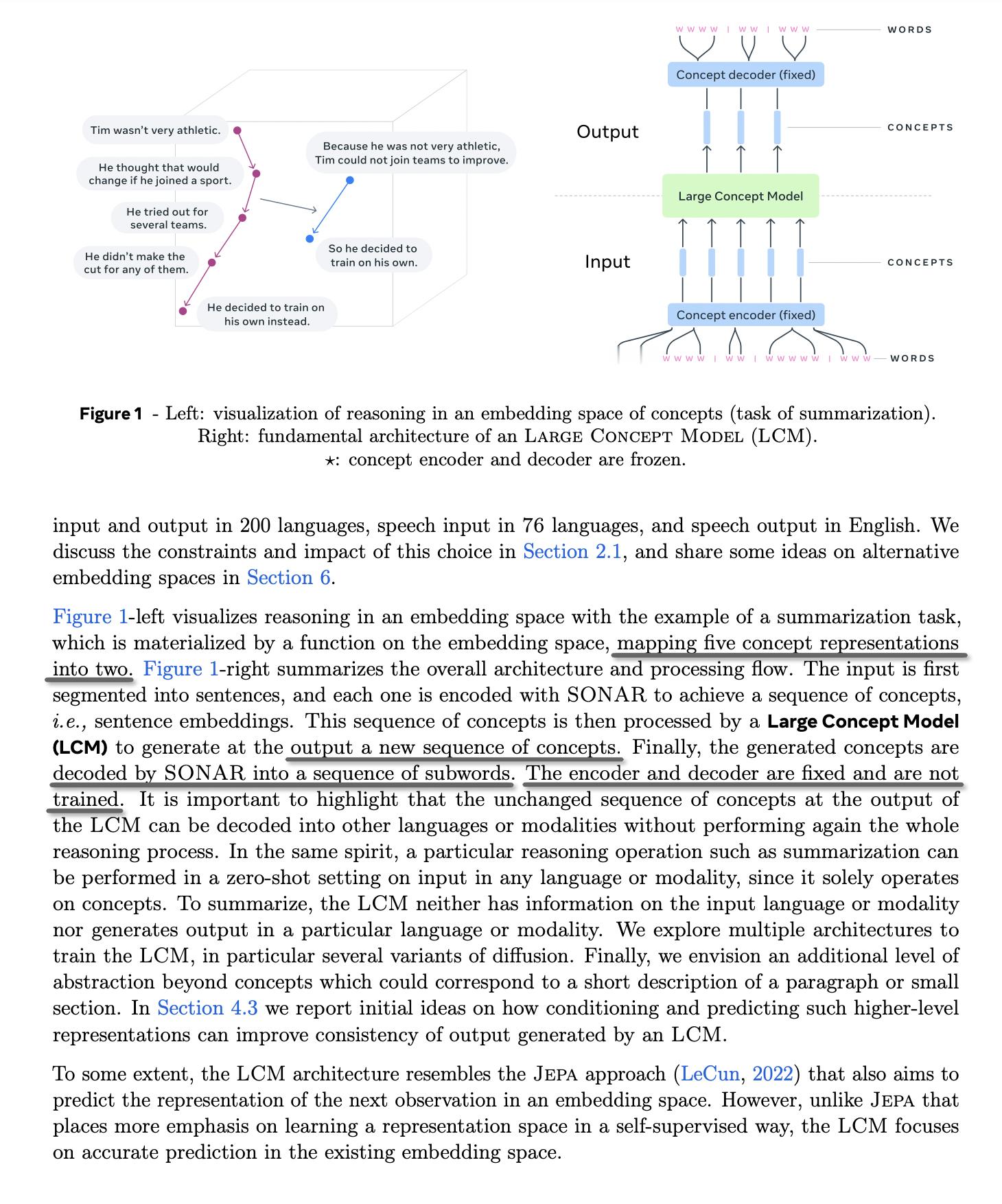

有意思的是,你会发现 Meta 最近也发了一篇论文,推出了 Large Concept Model,你可以把 Concept 认为就是一种模式,当然,我不是说此文提出的技术就是对的,但是你会发现显然技术方向已经开始发生转变了,这些新的算法思想和之前的都不一样,甚至逆反

但这些却与控制论,人与人的用处中所提及的思想非常吻合

现在关键的问题是这些抽象的结构用什么数据形式构建和表达,并且还要可计算? 这可能就需要抽象代数了,比如纤维丛理论? 用纤维丛进行各种的统计计算,线性计算,这有没有可能?

分享这些,是因为看到一个据说很火的 AI 研究员因压力很大抑郁去世,他写了一篇文章介绍现在 AI 界,或者说 LLM 大语言模型界的压力的

实际上你看,其实你放开一些思想,会发现其实可以改进的非常多,甚至会出现范式变化,而且其收益很可能是 10 倍以上的

当然,的确需要尽快把训练成本降下来,降成一个人都能训练,支付的起,这应该很快会实现

.