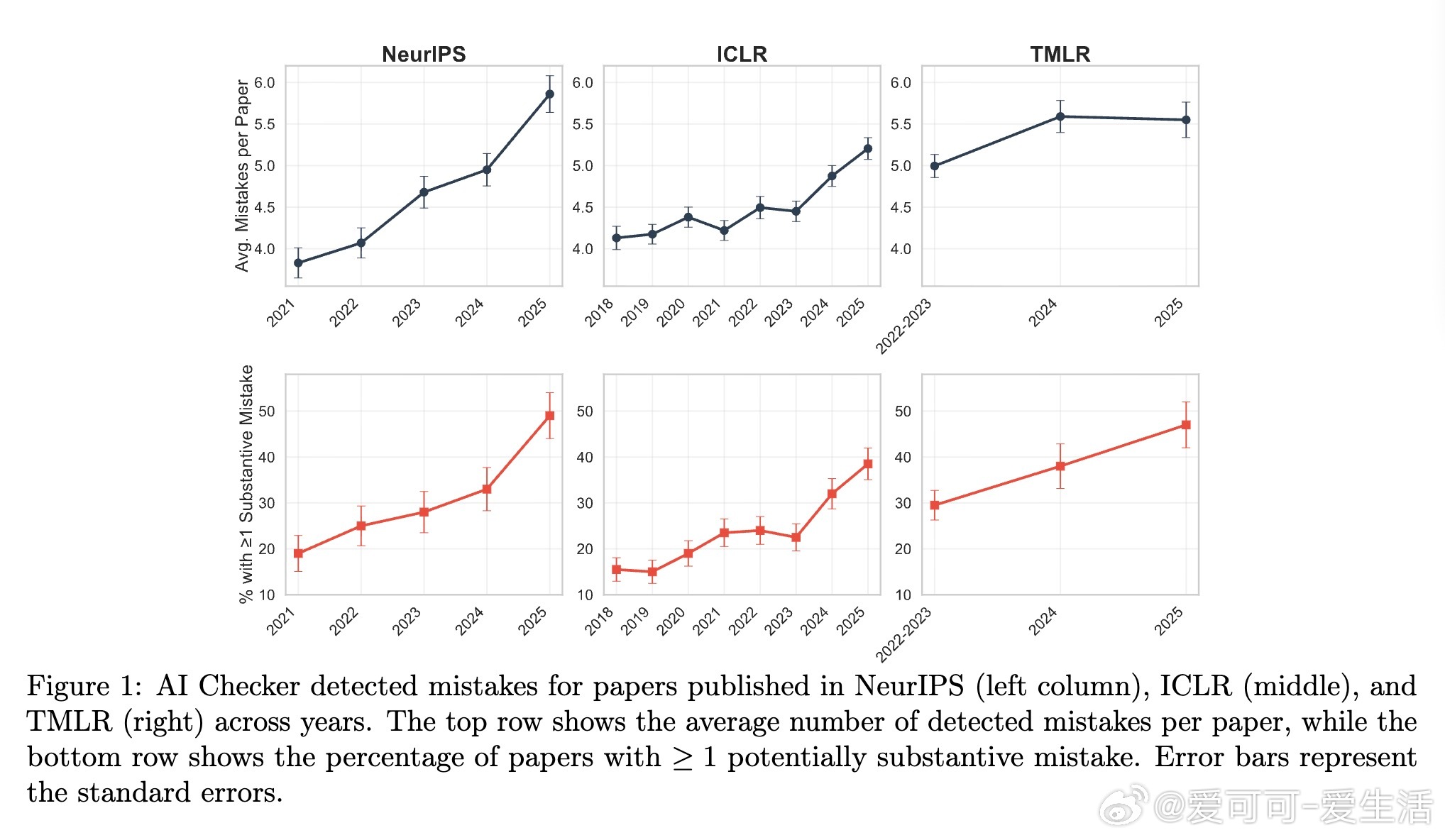

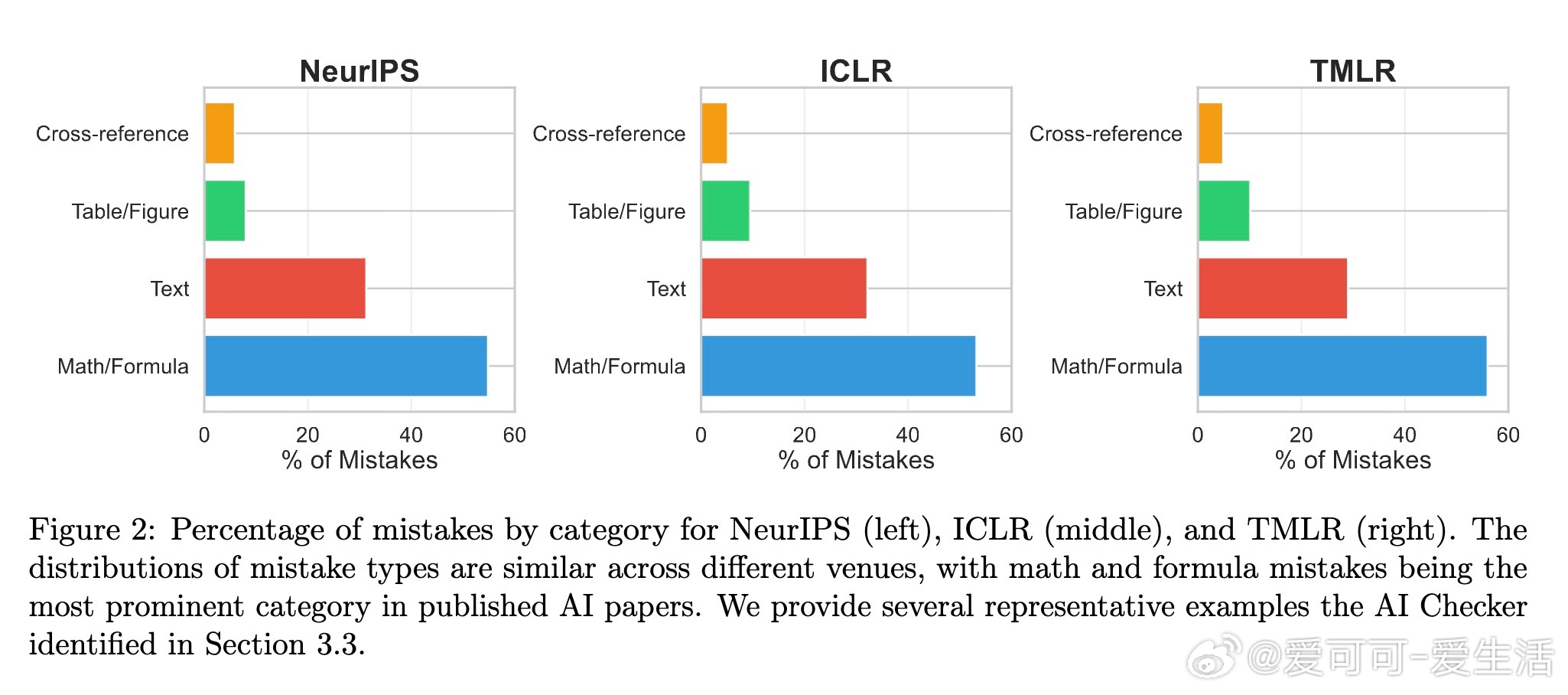

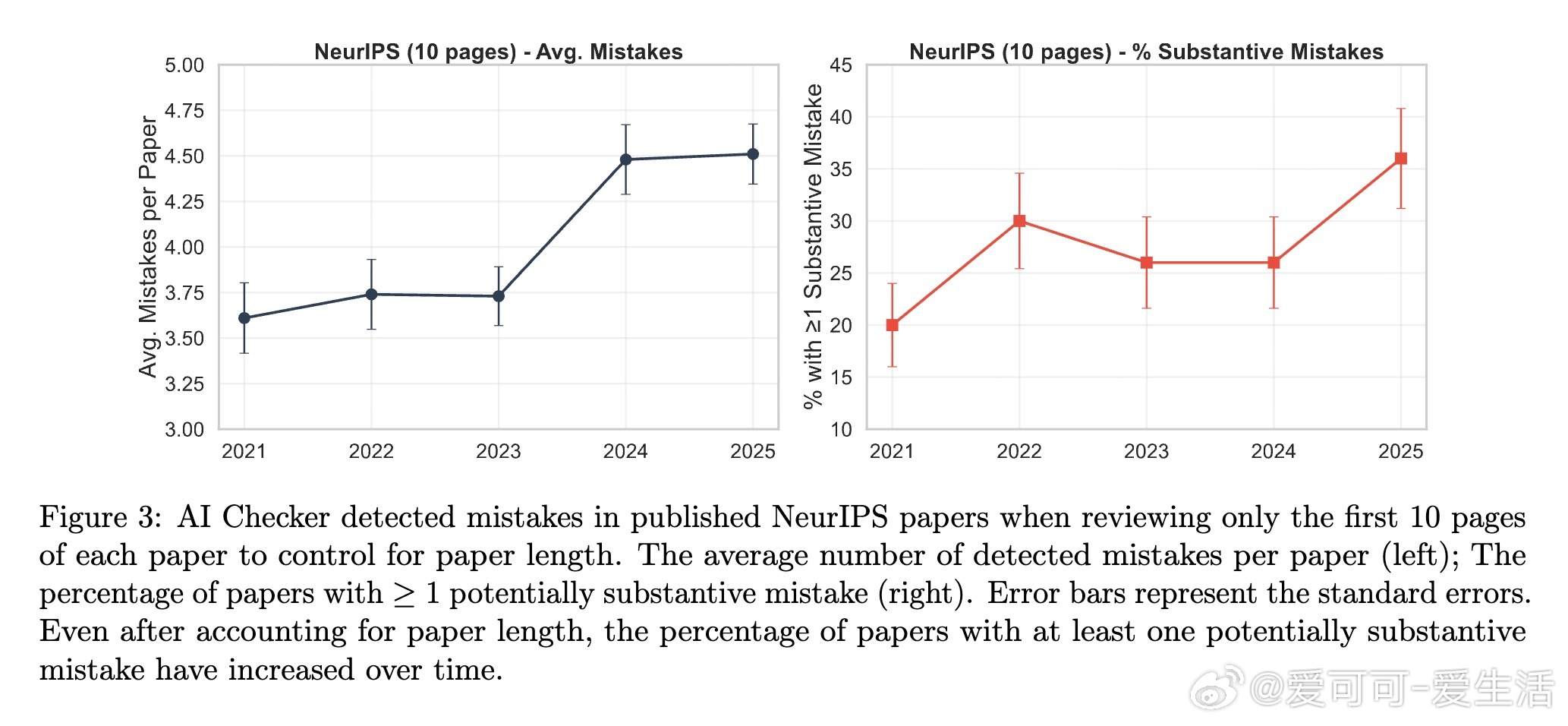

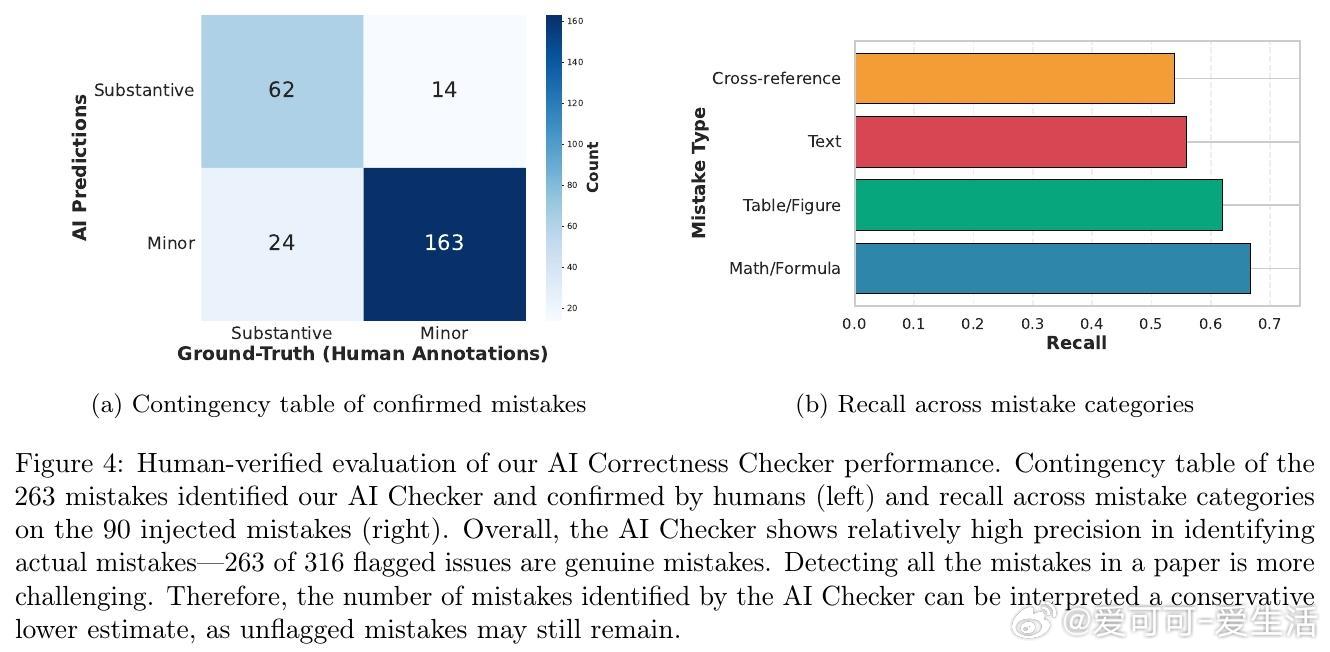

[AI]《To Err Is Human: Systematic Quantification of Errors in Published AI Papers via LLM Analysis》F Bianchi, Y Kwon, Z Izzo, L Zhang... [Together AI & NEC Labs America] (2025) 在AI研究高速发展的今天,顶级会议和期刊发表的论文中客观错误的数量令人担忧。本文利用基于GPT-5的“AI Correctness Checker”系统,首次大规模量化了NeurIPS、ICLR和TMLR等权威AI论文中的客观错误——包括数学公式、推导、计算、图表等方面的错误。关键发现如下:1. 错误普遍且逐年攀升。平均每篇论文发现约4.7处错误,NeurIPS论文从2021年的3.8处增至2025年的5.9处,增长超过50%。ICLR和TMLR论文也呈现类似趋势。2. 超过三分之一的论文至少含有一处“实质性错误”,这些错误可能影响结果解释和后续研究,甚至误导读者和产业应用。3. 误差类别中,数学和公式错误占比最高(54%),其次是文本描述(31%)、图表错误(9%)和交叉引用错误(5%)。4. 人工复核显示AI Checker的误报率较低,精确率达83.2%,且能正确修复75.8%的检测错误。5. 典型错误示例涵盖数据集规模夸大、数学定理证明不严谨、错误的线性代数和概率论步骤、公式推导错误以及文本与表格信息不一致等。这项工作凸显了当前AI论文审稿面临的巨大压力和复杂性,传统同行评审难以完全覆盖所有细节错误。前沿大语言模型作为辅助工具,可有效捕捉客观错误,提升科研成果的严谨性和复现性。作者建议结合AI辅助与人工复核,打造“人机协同”审稿新范式,既减轻审稿负担,又保障科学知识积累的质量。值得注意的是,AI Checker的检测依赖于文本和公式的准确解析,仍存在OCR误差和非标准符号带来的误判,同时召回率有限,意味着实际错误可能更多。对“实质性错误”的判定具有一定主观性,但整体趋势清晰:AI研究成果尽管丰富,严谨性仍需加强。这不仅是对科研质量的警示,更是推动审稿机制创新和科研工具升级的契机。用AI帮AI,守护科研诚信,让知识基石更牢固。详情请见论文原文:arxiv.org/abs/2512.05925