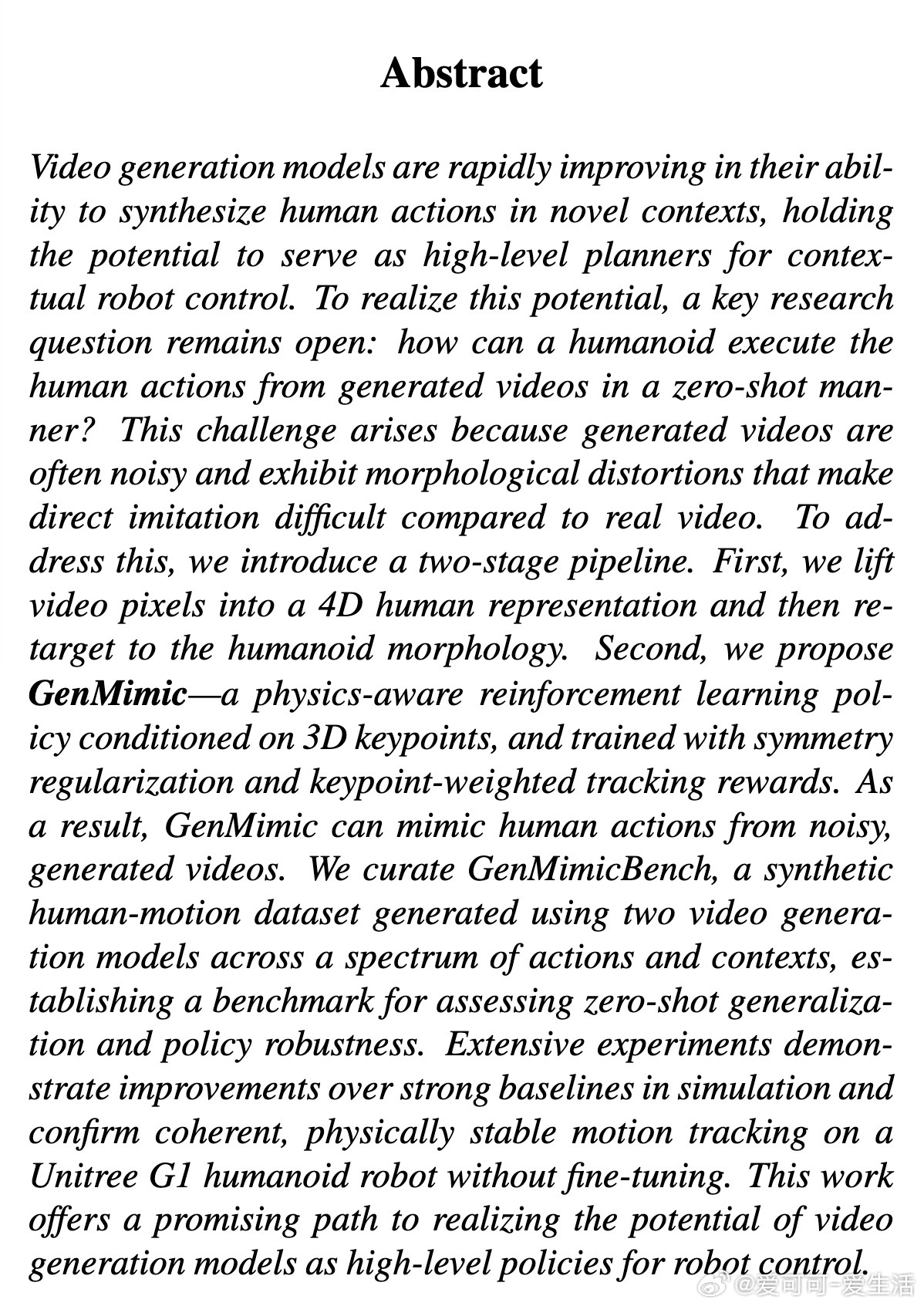

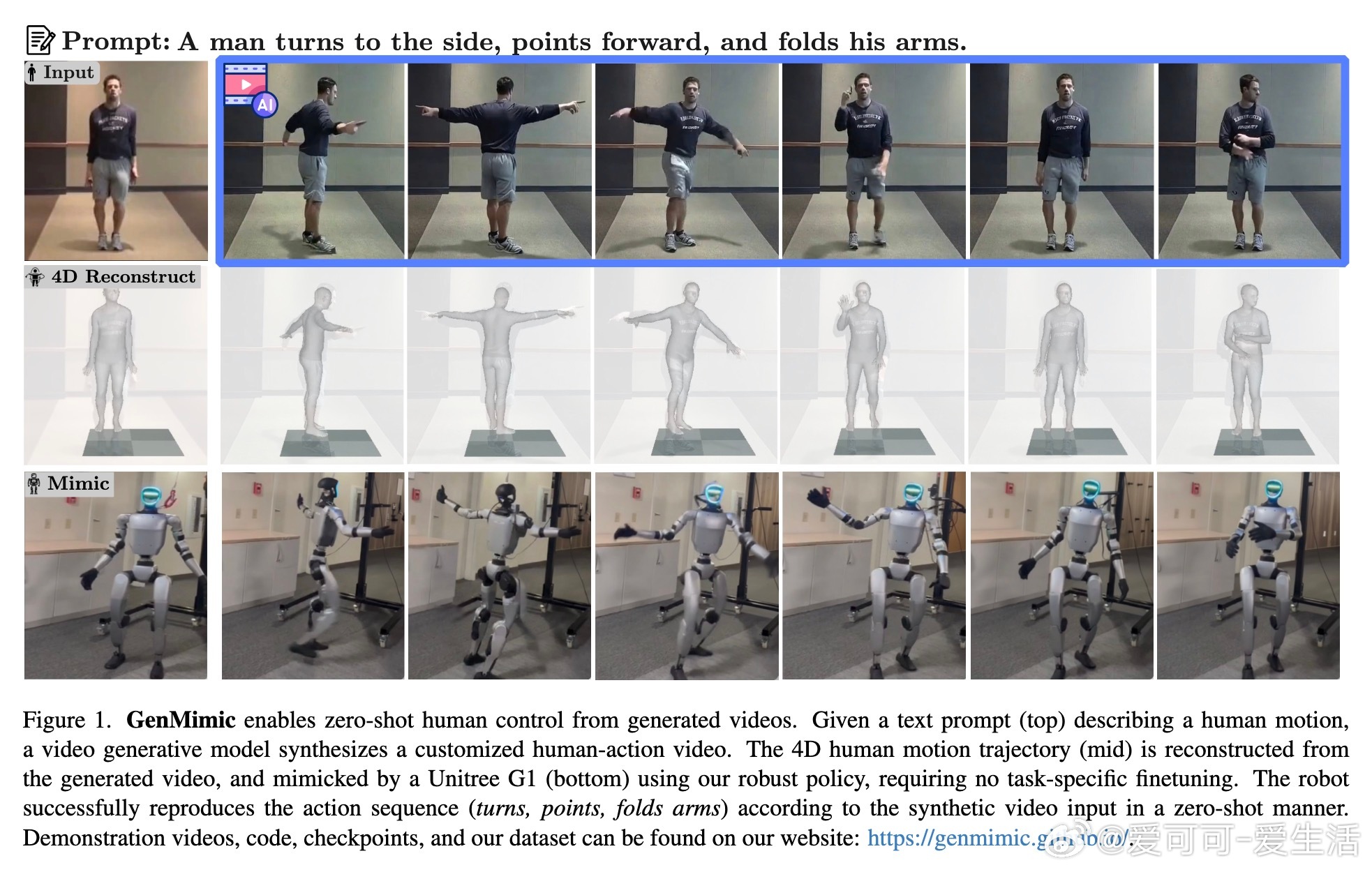

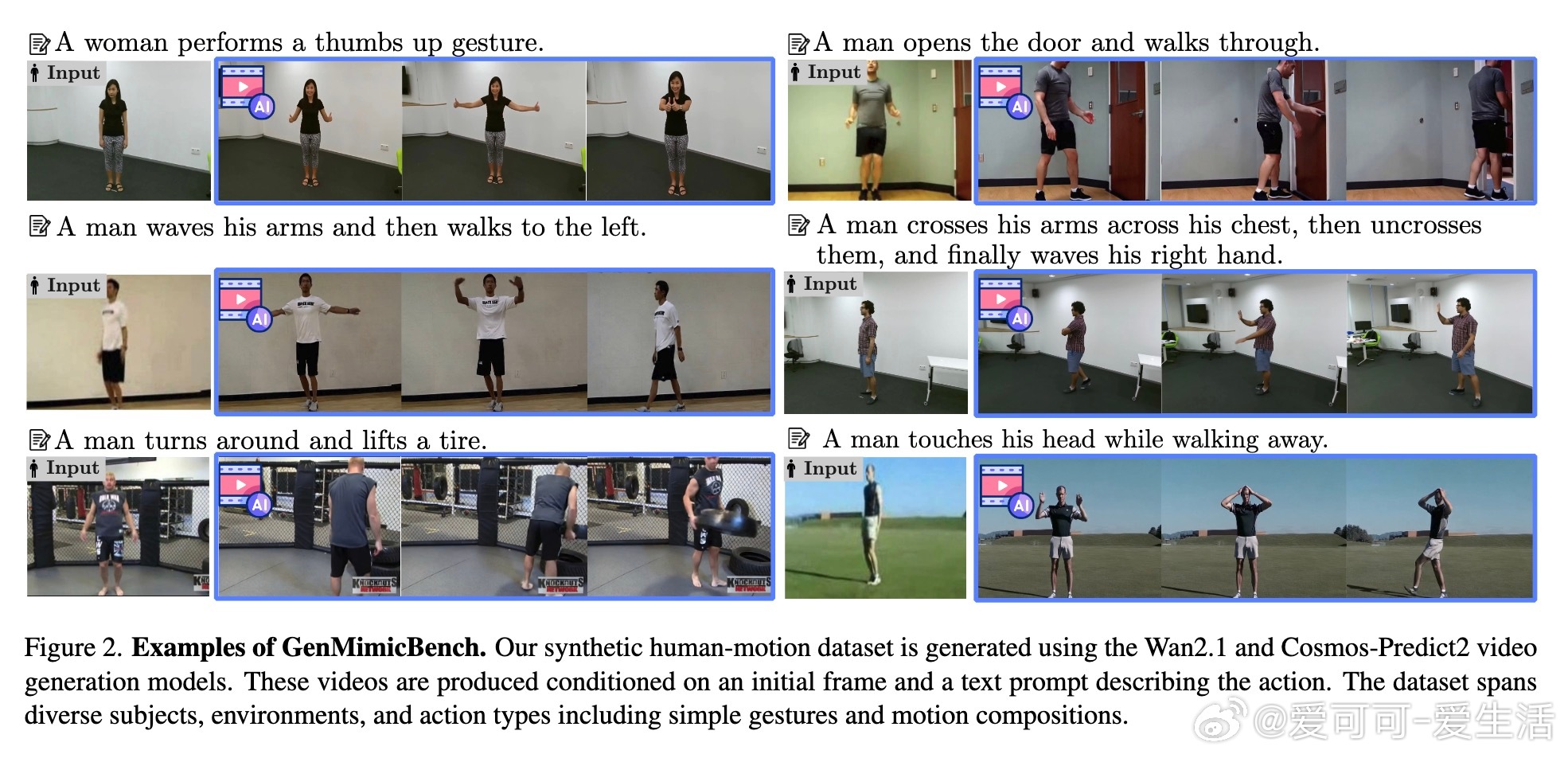

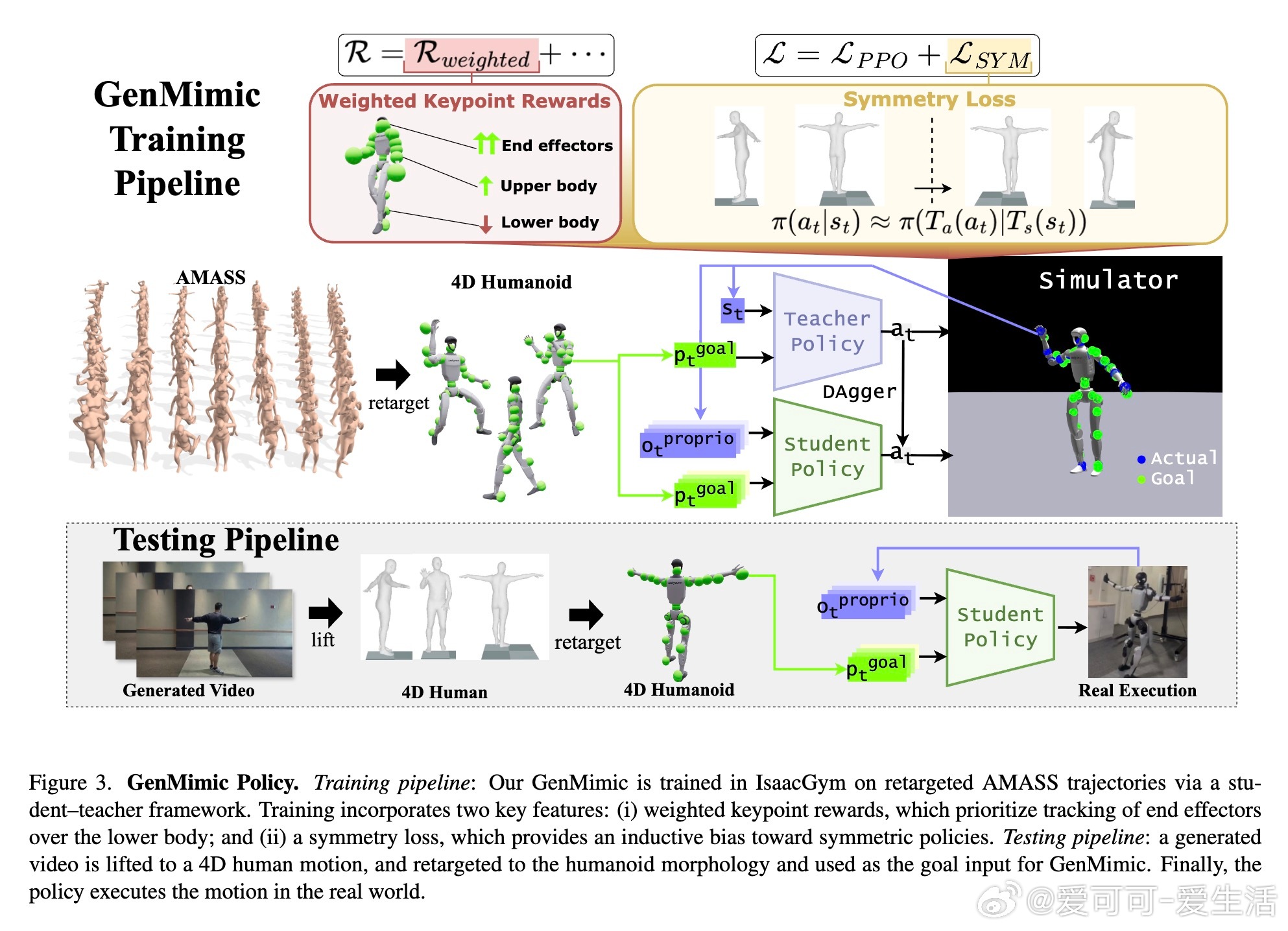

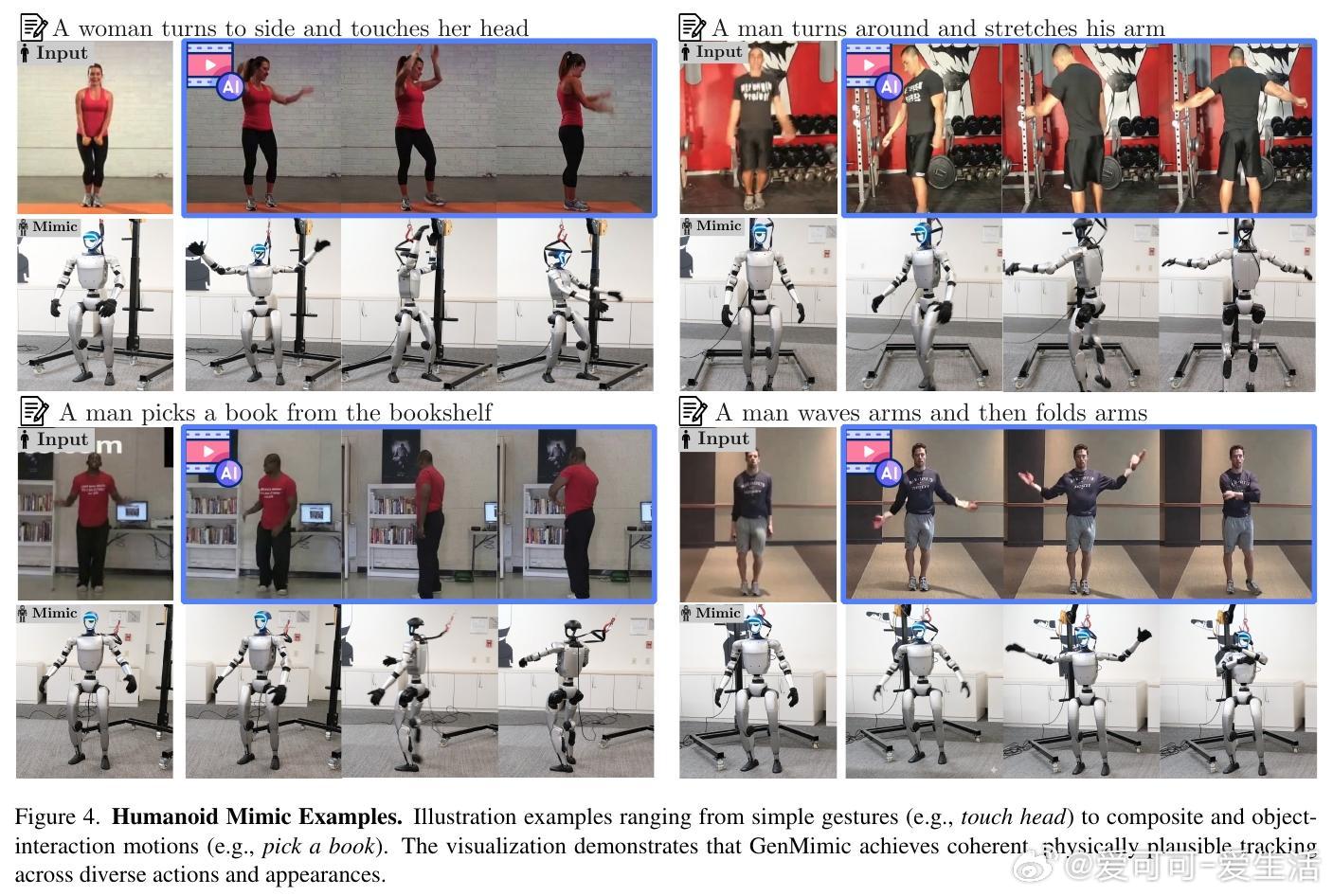

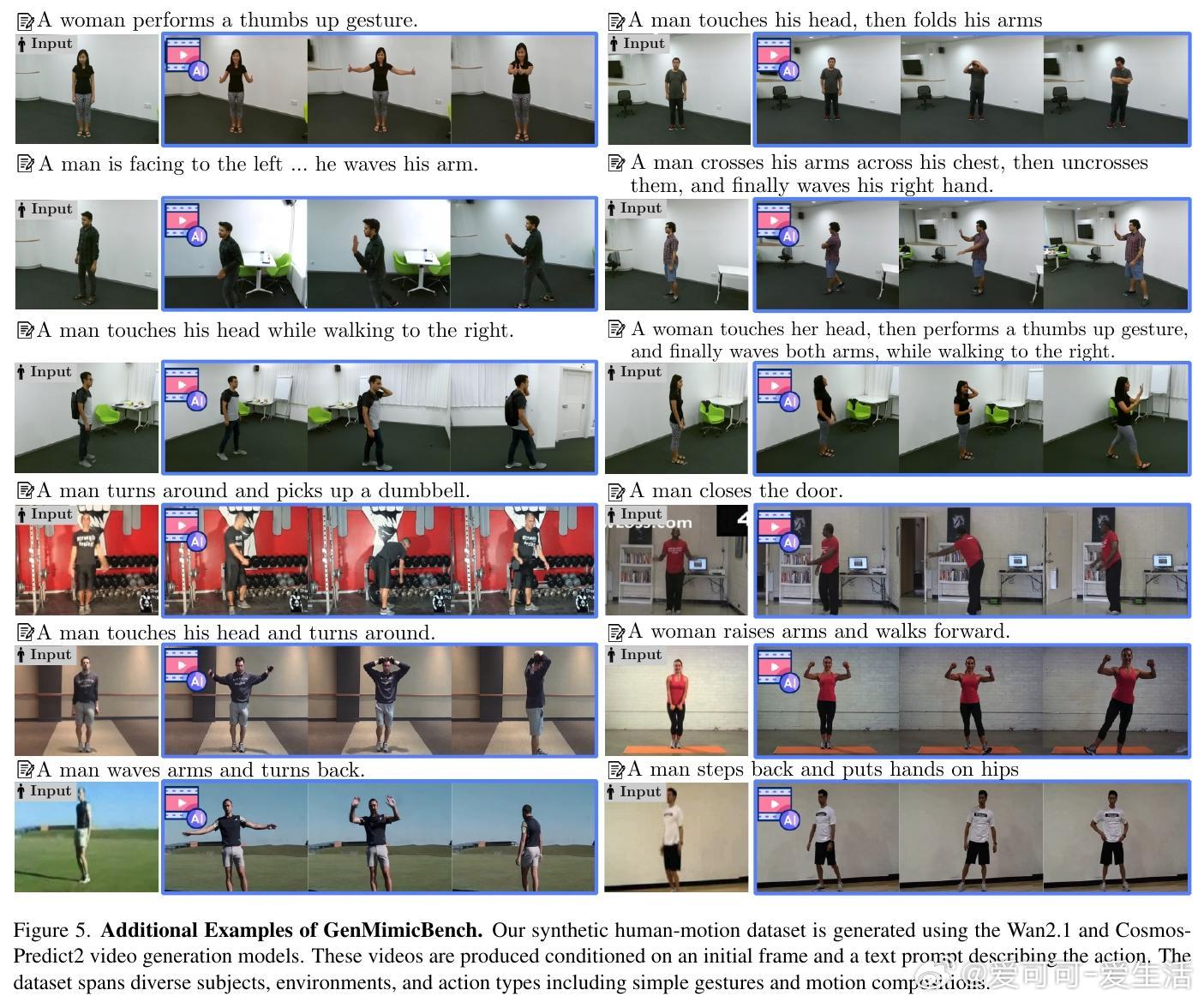

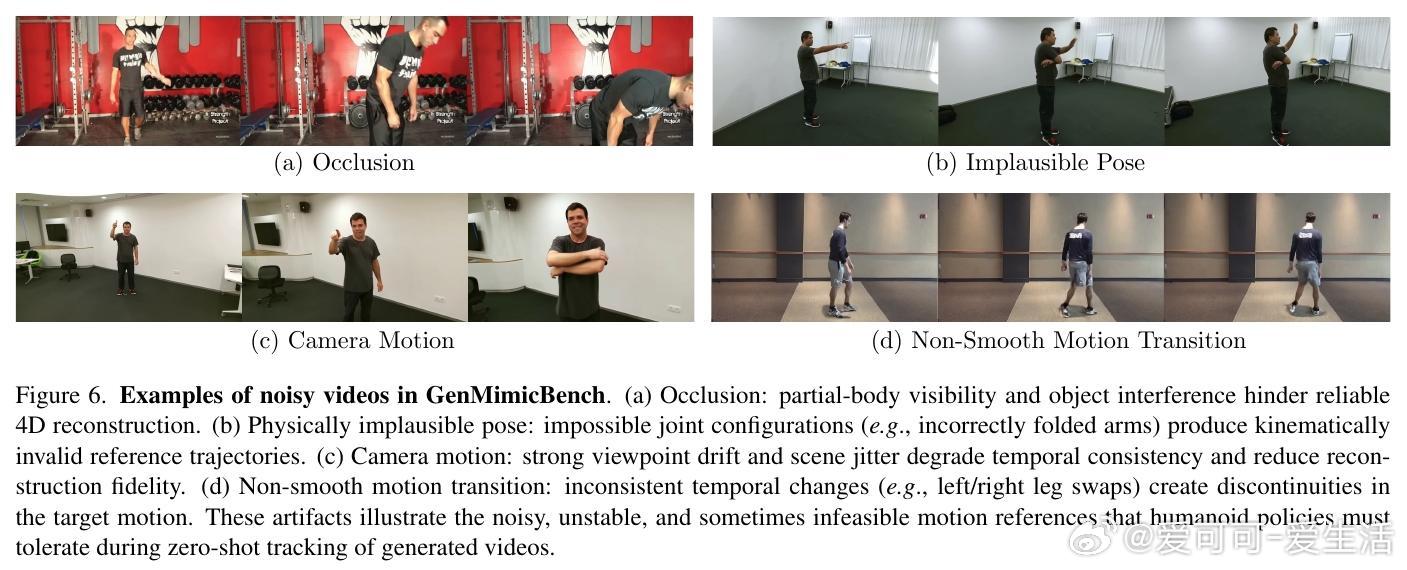

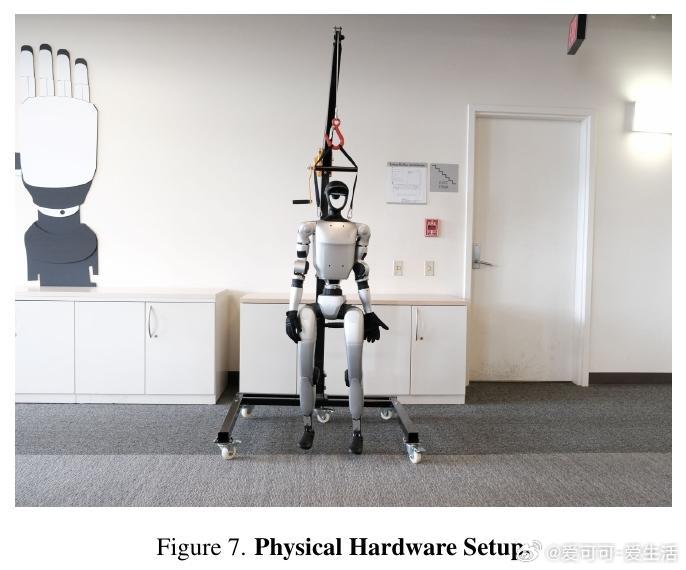

[RO]《From Generated Human Videos to Physically Plausible Robot Trajectories》J Ni, Z Wang, W Lin, A Bar... [UC Berkeley & Johannes Kepler University] (2025) 视频生成模型正迅速提升合成新颖人类动作的能力,成为机器人高层规划的潜力工具。但如何让人形机器人零样本执行这些生成视频中的动作,仍是关键难题。生成视频通常噪声大、形态失真,直接仿真难度极高。为此,本文提出两阶段框架:第一,将视频像素提升为4D人体表示,再将动作重定向至机器人形态;第二,设计GenMimic——一个基于物理约束的强化学习策略,使用3D关键点作为条件,通过对称性正则和关键点加权追踪奖励训练,提升对噪声视频的鲁棒性。我们构建了GenMimicBench数据集,包含由两个先进视频生成模型Wan2.1和Cosmos-Predict2合成的428个多样动作视频,覆盖室内控制场景到复杂自然环境,作为机器人零样本泛化和鲁棒性评测基准。大量仿真和真实机器人实验验证,GenMimic在Unitree G1机器人上无需微调即可稳定追踪生成视频动作,且性能显著优于多种强基线。加权关键点奖励和对称性损失对提升鲁棒性贡献显著,3D关键点条件优于传统关节角度。本工作开辟了利用视频生成模型作为机器人高层控制策略的可行路径,推动人形机器人向更通用的视觉生成规划迈进。未来可通过提升4D重建精度、扩充多样训练数据和学习潜在动作表示,进一步增强对复杂动态与物理交互动作的适应力。详见论文:arxiv.org/abs/2512.05094项目主页和代码数据集:genmimic.github.io/——每一步都在缩小虚拟与现实的鸿沟,让机器人用“眼睛”看见未来的动作,用“身体”演绎人类的无限可能。