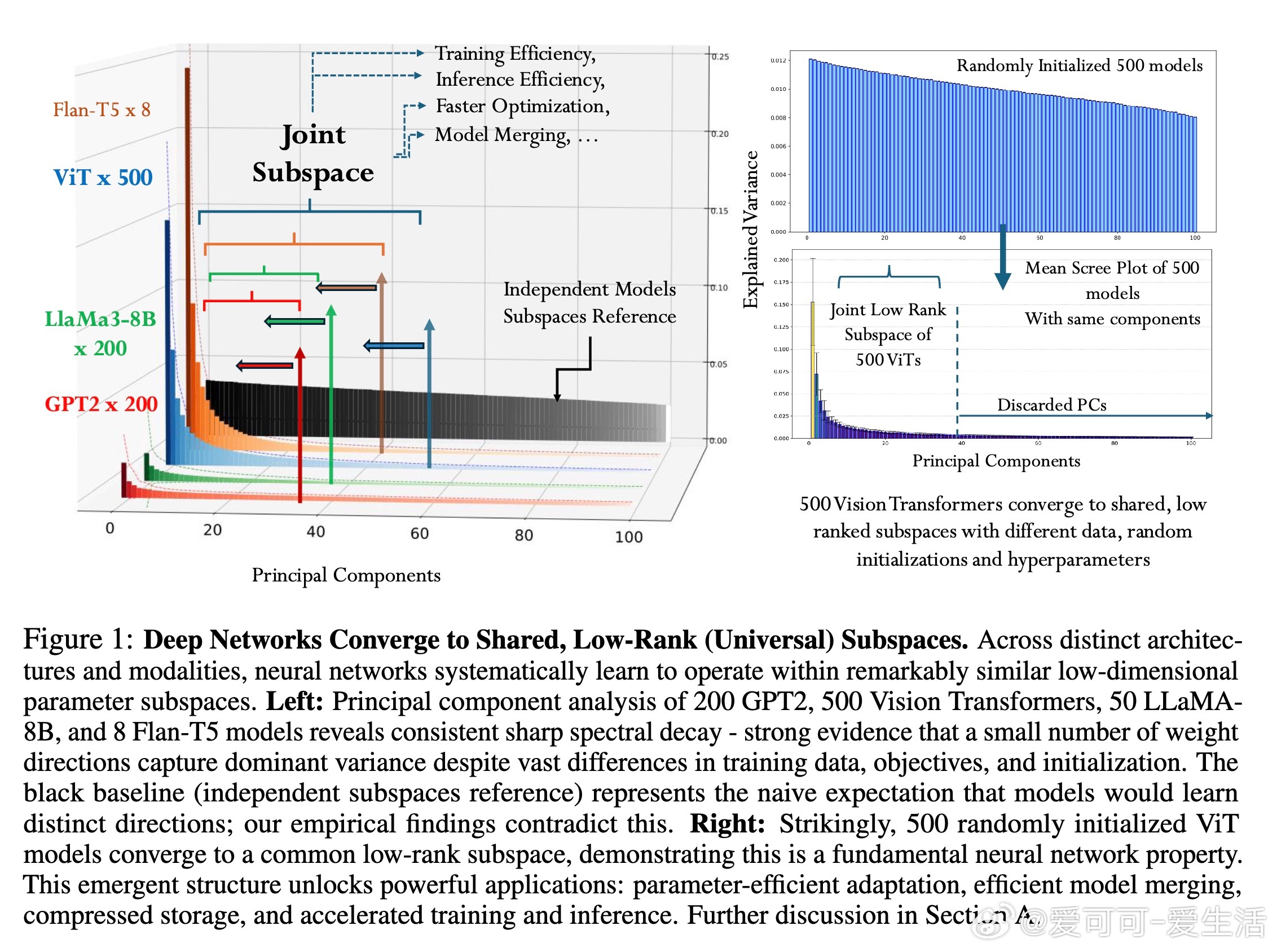

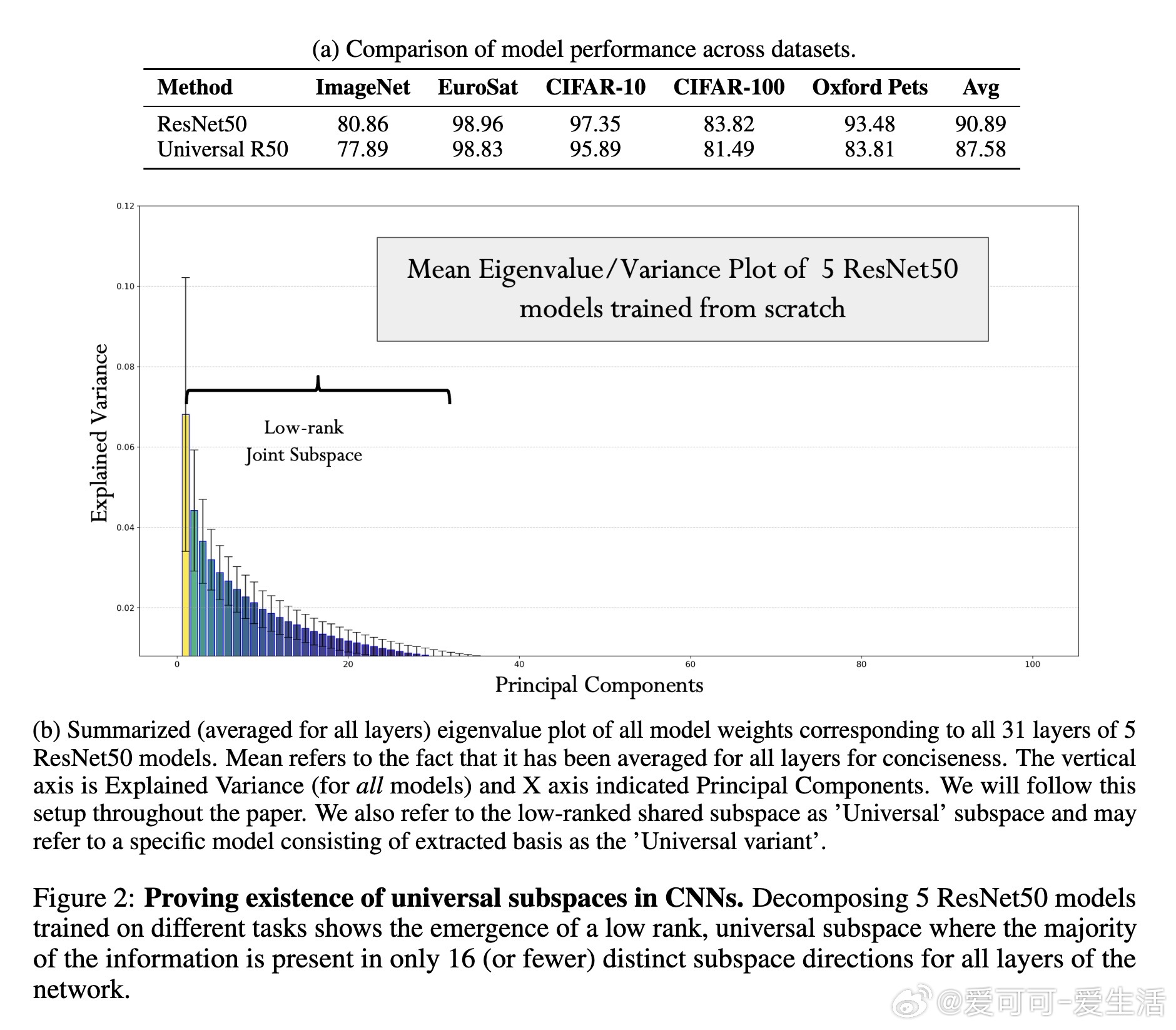

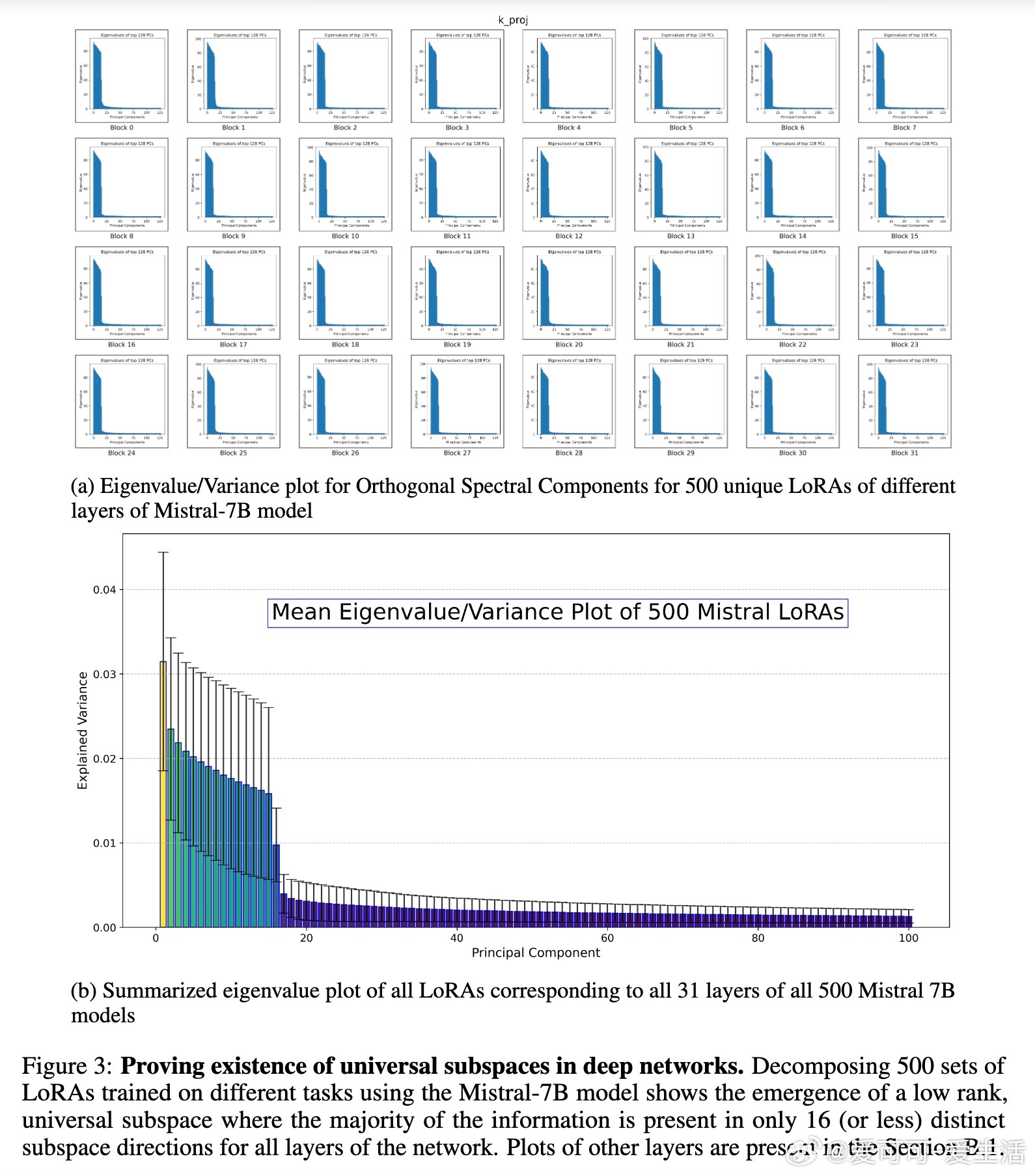

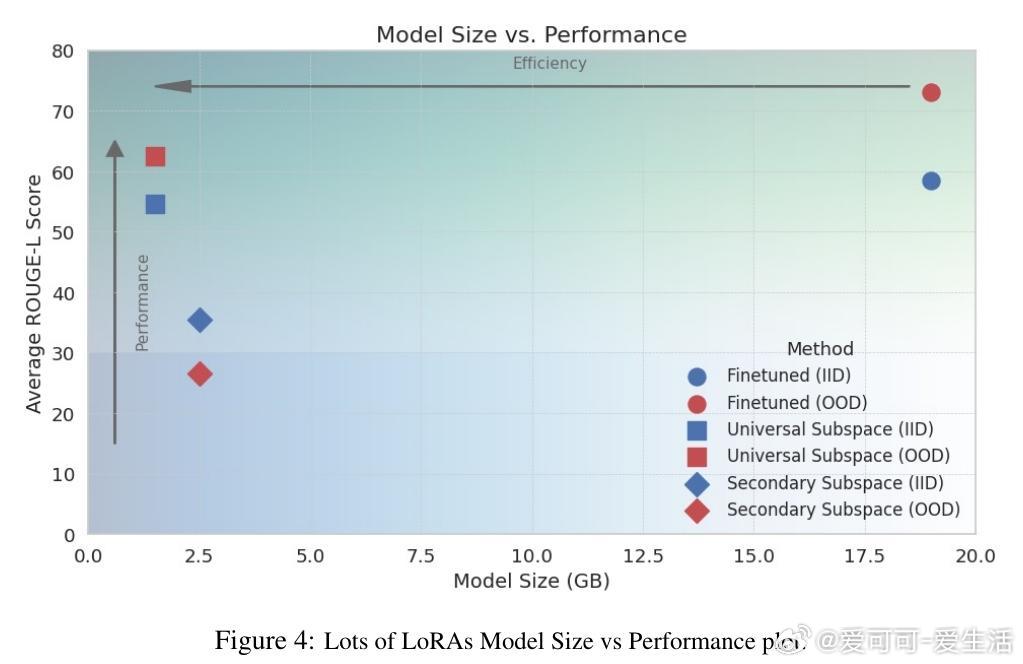

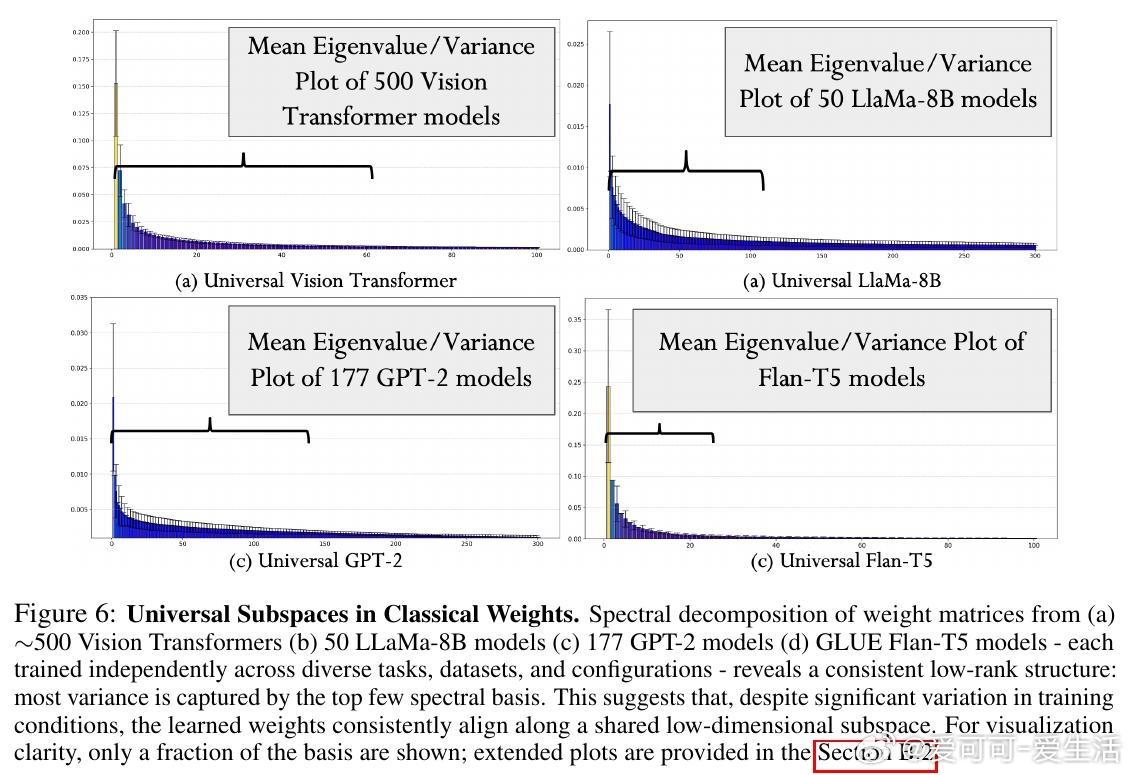

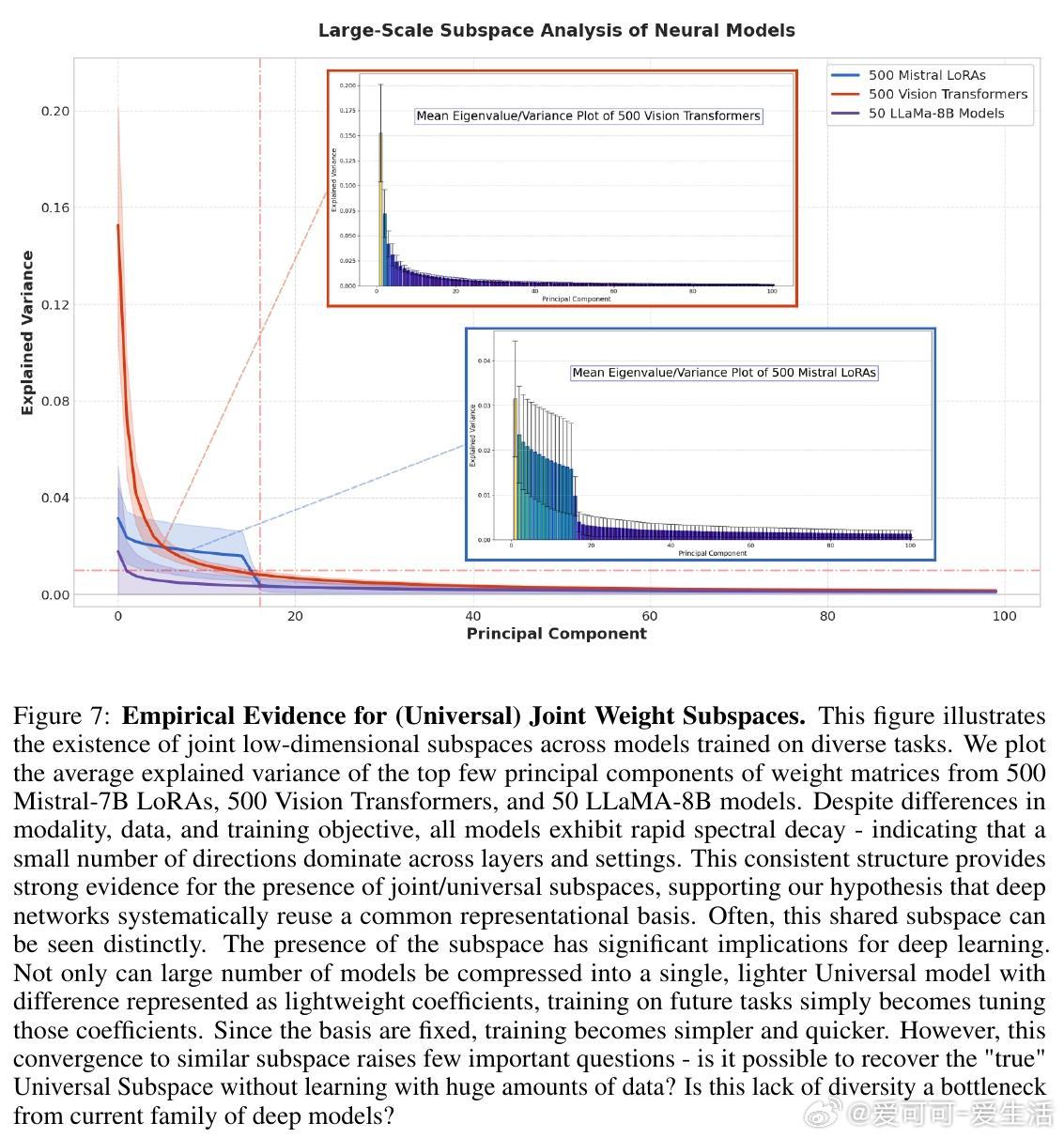

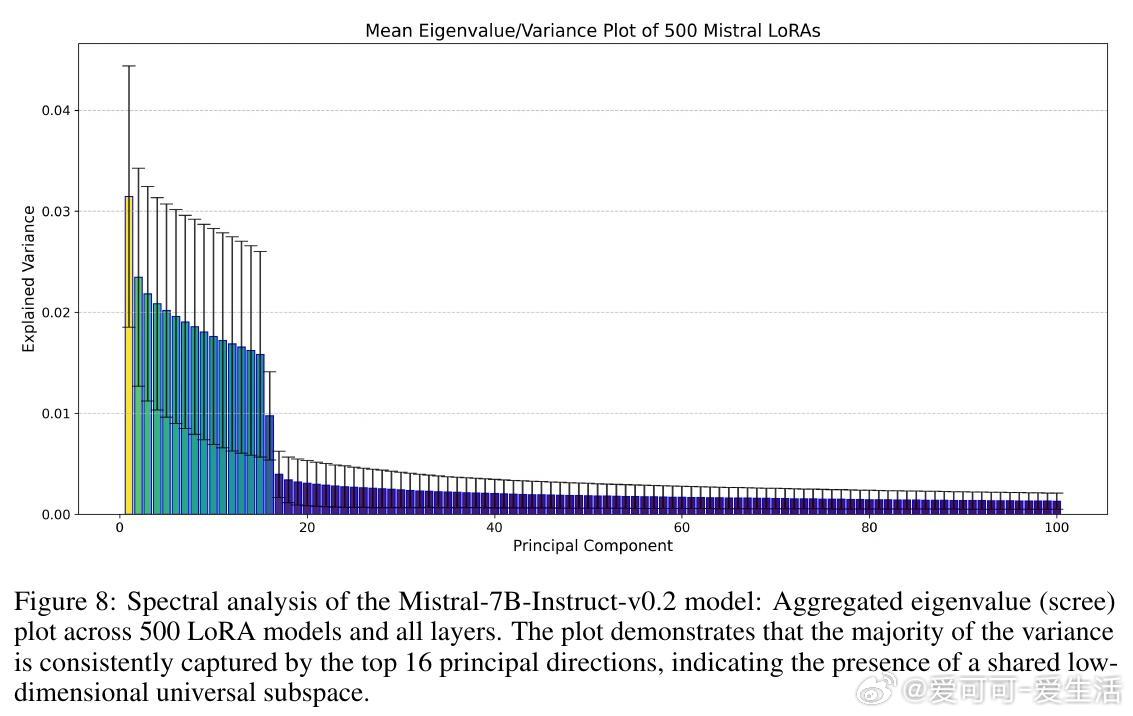

[LG]《The Universal Weight Subspace Hypothesis》P Kaushik, S Chaudhari, A Vaidya, R Chellappa... [Johns Hopkins University] (2025) 深度神经网络跨任务训练后,呈现出惊人的低维参数共享子空间——这就是本文提出的“普适权重子空间假说”。该研究通过对1100余个模型(包括500个Mistral-7B LoRA、500个视觉Transformer、50个LLaMA-8B)进行模态谱分析,发现无论初始化、任务或领域如何变化,模型权重均会收敛于同一低秩子空间,仅少数主方向即可捕捉绝大部分方差。这不仅揭示了深度网络内部信息的组织规律,也对模型重用、多任务学习、模型合并以及高效训练推理提供了理论与实证支持,有望大幅降低大规模模型的计算与碳足迹。实验覆盖了从卷积网络(CNN)、LoRA适配器到经典权重的广泛架构,均验证了低秩共享子空间的存在。理论上,研究将预测函数视作Hilbert空间元素,证明随着任务数量增多、单任务估计误差趋小,学习到的经验子空间会以一定速率逼近真实的共享子空间。实证中,500个Mistral-7B LoRA模型、500个视觉Transformer和50个LLaMA-8B权重均表现出截然明显的谱衰减,表明其权重空间高度可压缩且共享。更引人注目的是,利用该普适子空间可以:1. 只训练少量系数参数即可适应新任务,极大提高参数效率和训练速度;2. 将数百个独立训练的模型压缩合并为单一低秩模型,节省存储和计算;3. 在多任务学习和模型合并中无需复杂调参,保证性能且降低资源消耗。此外,研究讨论了该现象产生的潜在原因:深度网络的频谱偏置、架构内置的归纳偏置、以及梯度下降优化的核不变性,均促使参数空间收敛至稳定的低维几何结构。虽然目前尚未深入解析子空间具体含义和跨架构比较,但该工作为理解神经网络的泛化、迁移和训练效率开辟了新视角,也为可持续AI发展提供了切实路径。完整论文与更多细节请见 arxiv.org/abs/2512.05117这是一场关于神经网络权重空间结构的革命,让我们重新思考模型的本质与未来。低维共享子空间不只是数学现象,更是未来高效、绿色智能系统的基石。