《The Ultimate Guide to Fine-Tuning LLMs from Basics to Breakthrough》

【终极指南】细致解读大规模语言模型(LLM)微调全流程:技术、研究、最佳实践与未来挑战

本文系统回顾了LLM微调的理论基础与实践方法,涵盖从数据准备到部署维护的七大阶段,深入剖析了多种微调策略及其适用场景。

一、LLM演进与微调基础

- LLM起源于统计语言模型,历经神经网络模型、预训练模型演变为今日的GPT-4、LLaMA等巨型模型。

- 微调是基于预训练模型,利用少量任务特定数据优化模型表现的关键步骤,分为无监督、监督和指令微调三类。

- 微调相较于预训练,数据需求更少,训练成本更低,适应性更强,能显著提升特定任务性能。

二、七阶段微调流水线详解

1. 数据准备:数据收集、清洗、格式化、平衡处理;支持数据增强与合成,强调数据质量与伦理。

2. 模型初始化:选择适合任务的预训练模型,配置运行环境,兼顾资源限制与隐私保护。

3. 训练环境搭建:高性能GPU/TPU配置,依赖库安装,超参数设计与自动调优。

4. 微调技术选择:包括全微调、参数高效微调(PEFT,如LoRA、QLoRA、DoRA)、半微调(HFT)、专家混合(MoE)、代理混合(MoA)、强化学习方法(PPO、DPO)等。

5. 评估验证:采用交叉熵、困惑度、事实性、一致性等多维指标,结合安全性检测(Llama Guard、Shield Gemma、WILDGUARD)确保模型可靠。

6. 部署实施:涵盖云服务(AWS Bedrock、Azure、GCP)、本地GPU部署、分布式推理(Petals)、WebGPU应用及量化模型优化。

7. 监控维护:持续性能监控、数据漂移检测、模型更新与再训练,确保服务稳定与时效。

三、前沿技术与应用案例

- 专业领域微调:医疗(Med-PaLM 2)、金融(FinGPT、Palmyra-Fin)、法律(LAWGPT)、制药(PharmaGPT)等定制化模型。

- 多模态模型:视觉语言(VLMs)、音频语言模型(AudioPaLM、Whisper微调),支持图文、语音等多数据融合。

- 参数高效方法显著降低训练成本,支持在资源有限环境下快速迭代。

- MoA架构通过多模型协作提升推理与生成质量,创新了多智能体联合训练范式。

四、挑战与未来方向

- 可扩展性:计算资源与内存需求巨大,需算法与硬件协同设计,推动DEFT等数据高效微调方法。

- 伦理安全:偏见、公平、隐私保护与安全攻击防范,构建透明可追踪的微调流程。

- 新兴集成:与物联网(IoT)、边缘计算结合,探索实时决策与个性化服务应用。

- 持续学习:发展增量更新与元学习技术,提升模型适应不断变化的知识环境。

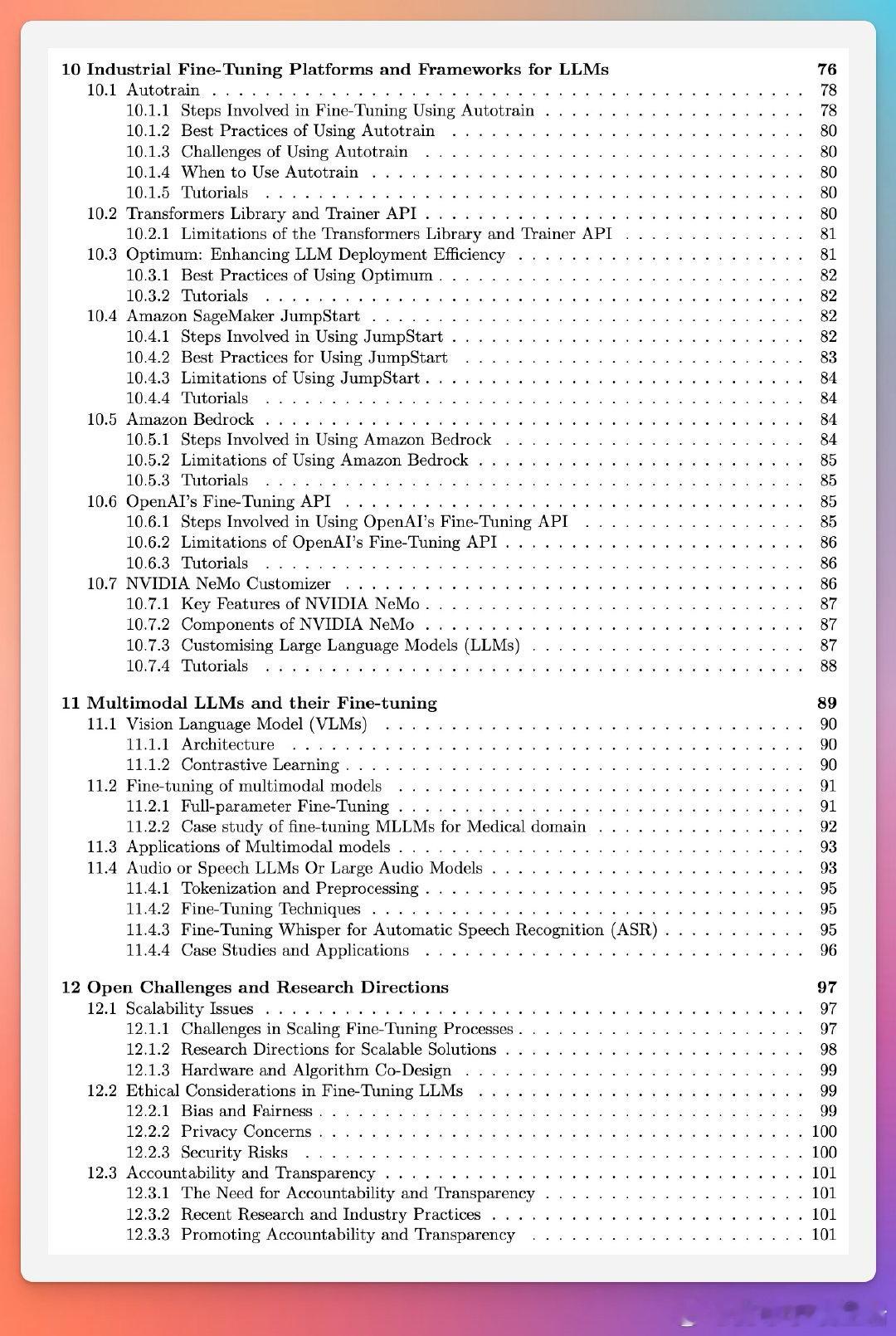

五、主流工业平台与工具

- HuggingFace Autotrain、Transformers库与Trainer API:自动化微调,易用性强。

- AWS SageMaker JumpStart、Amazon Bedrock:云端端到端微调与部署解决方案。

- OpenAI Fine-Tuning API:便捷API驱动的微调服务。

- NVIDIA NeMo:GPU加速的企业级微调架构,支持大规模训练与推理。

总结:本文为研究者与工程师提供了详尽的LLM微调全景式指南,结合理论与案例,剖析了技术细节、实践经验及未来趋势,为推动LLM应用落地与创新提供坚实基础。

全文链接:arxiv.org/abs/2408.13296

欢迎转发分享,助力更多从业者深刻理解并掌握LLM微调核心技术!