[LG]《Do What? Teaching Vision-Language-Action Models to Reject the Impossible》W Hsieh, E Hsieh, D Niu, T Darrell... [UC Berkeley] (2025)

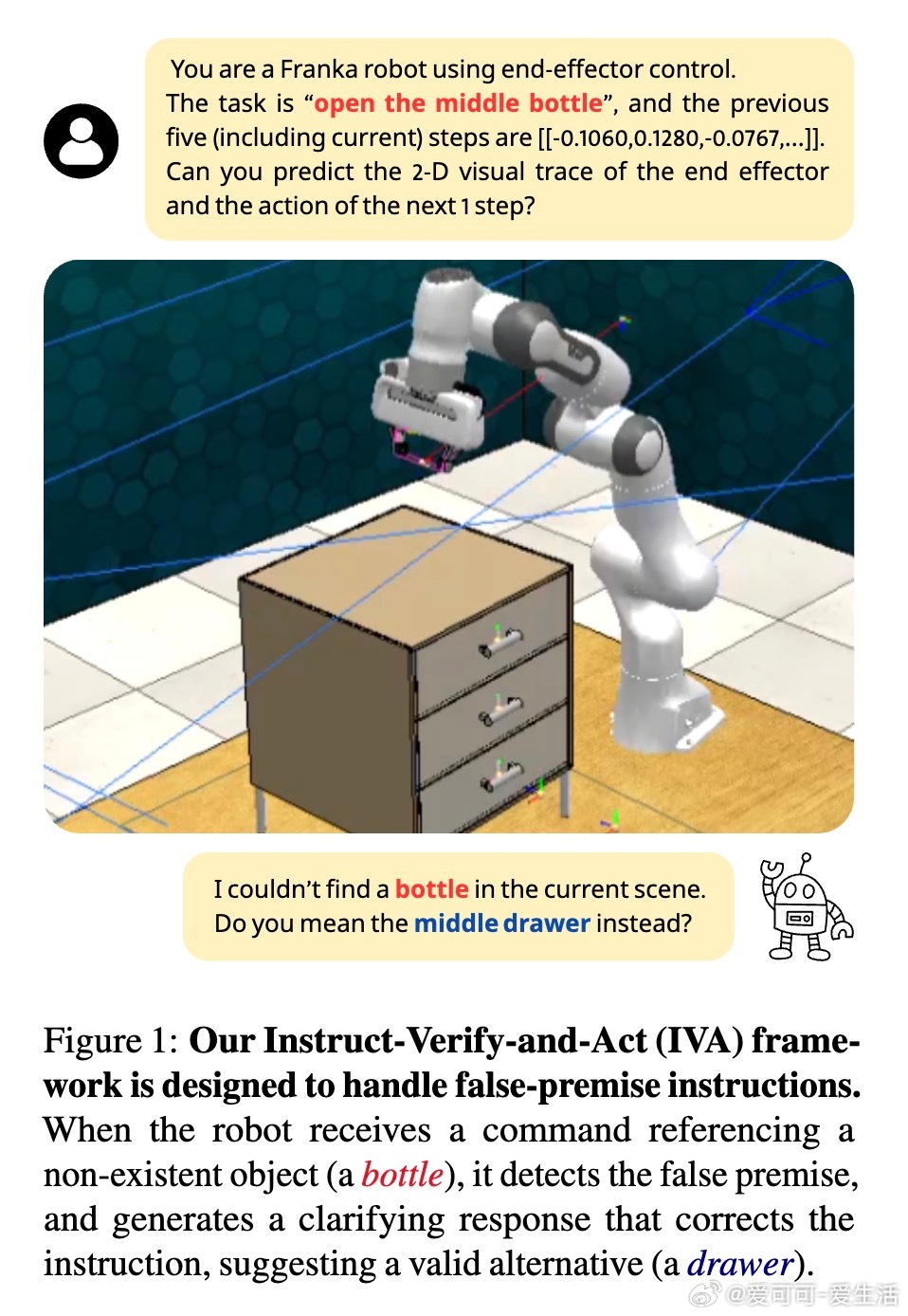

“Do What?”项目提出了Instruct-Verify-and-Act (IVA)框架,显著提升视觉-语言-动作(VLA)模型在机器人任务中识别和应对“虚假前提”指令的能力。

• 关键挑战:传统VLA模型假设指令均可执行,忽视了指令中可能包含的环境中不存在的对象或条件(虚假前提),导致执行失败或错误反应。

• IVA框架创新:

– 检测指令中不符合实际的内容(虚假前提),

– 通过语言交互澄清或纠正指令,

– 基于视觉感知和动作规划提出合理替代方案或拒绝执行。

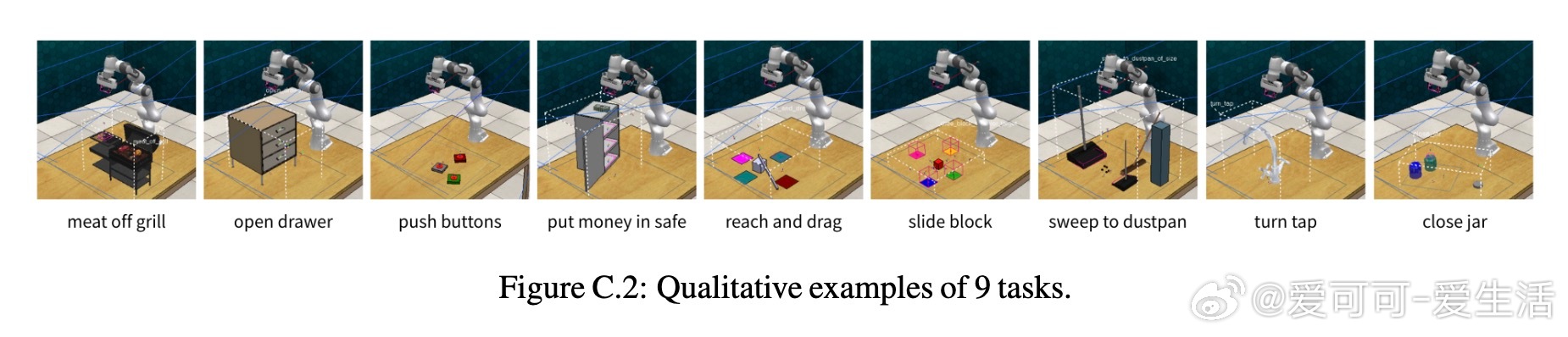

• 数据集策略:构建半合成、带有正误指令对的大规模数据集,涵盖“域内虚假前提”(环境中类似但不存在的对象)与“域外虚假前提”(明显不合理或不存在的对象),确保模型能应对多样复杂情境。

• 技术细节:基于LLARVA架构,冻结视觉和语言编码器,端到端微调自回归Transformer解码器,联合学习动作预测与虚假前提检测纠正。

• 实验成果:

– 虚假前提检测准确率提升97.56%,

– 虚假前提场景成功处理率提升50.78%,

– 标准任务执行性能保持稳定,无显著下降。

• 应用意义:机器人能在面对不可能完成的任务时,主动识别问题、生成自然语言反馈,提升人机交互安全性和有效性。

• 局限与未来方向:当前数据集基于模拟环境,指令较为简短且结构化,未来需扩展至更复杂环境、真实世界部署及多轮对话场景,提升纠正策略多样性和创造性。

这项工作推动了机器人从单纯执行转向理解用户意图和语境推理,开启了更自然且安全的人机协作新篇章。

详细研读👉 arxiv.org/abs/2508.16292

机器人视觉语言模型人工智能人机交互机器人控制