CoreML LLM CLI:在 Apple Neural Engine 上运行大型语言模型(LLM)的命令行演示工具。

• 支持下载并加载 CoreML 兼容的 Llama 2 7B 模型(约4GB),运行于 macOS 14 (Sonoma)。

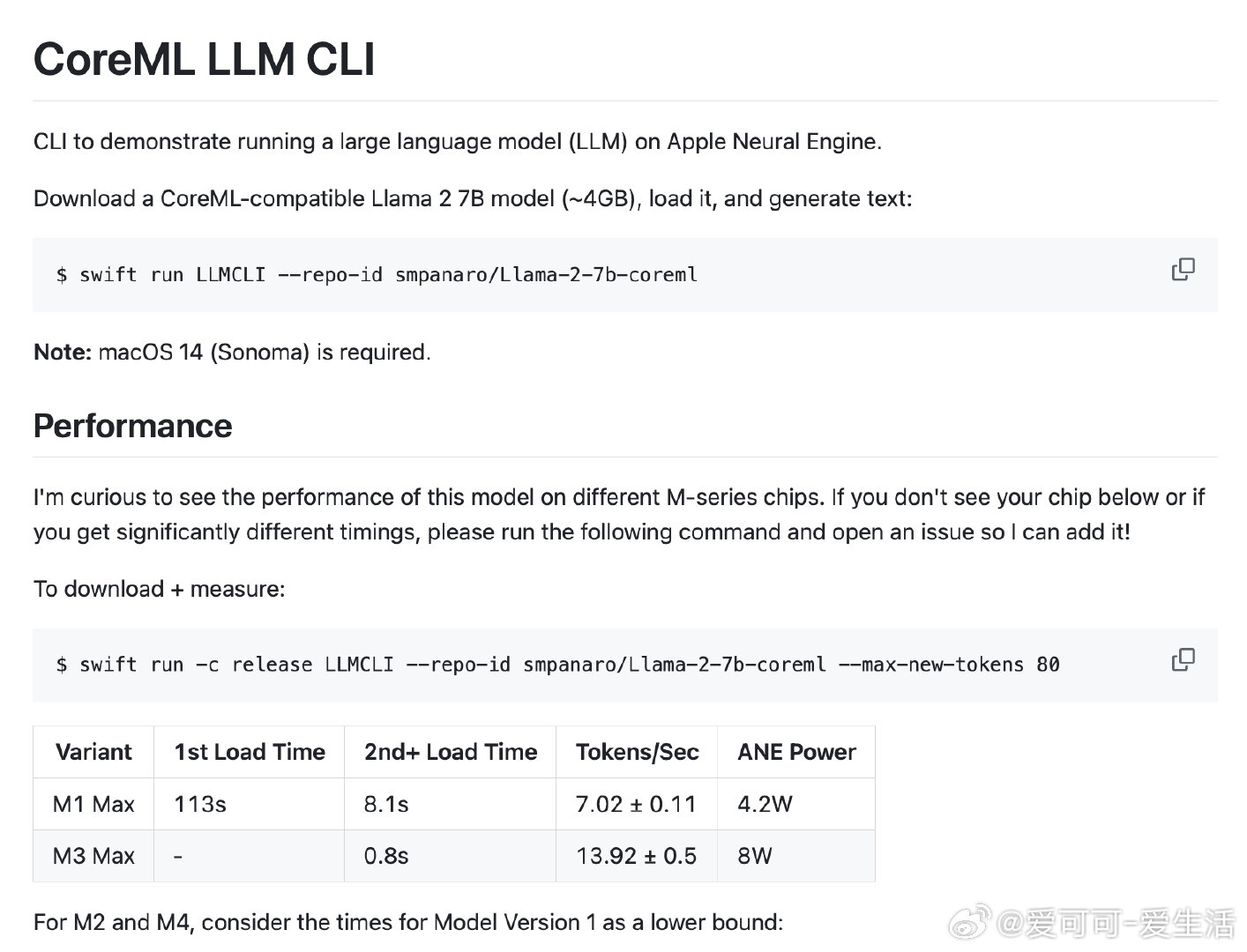

• 针对不同 M 系列芯片(M1 Max、M2、M3 Max 等)进行性能测试,Token 生成速度最高达13.92 tokens/sec,功耗8W,展现强劲算力。

• 采用多项推理优化:利用 IOSurface-backed CVPixelBuffers 避免 CPU 与 ANE 之间数据复制,提高效率。

• 通过 4D 张量重排(Batch, Channels, 8, 8)实现卷积运算速度提升约20%,兼顾注意力机制的特殊需求。

• 模型拆分为多个小 CoreML 模型块,支持异步 KV 缓存更新,减少延迟,提升整体响应速度。

• 适合开发者在 Apple Silicon 平台上探索和实验高效本地化 LLM 推理。

详情见🔗 github.com/smpanaro/coreml-llm-cli

AppleNeuralEngine CoreML Llama2 大型语言模型 AppleSilicon 机器学习