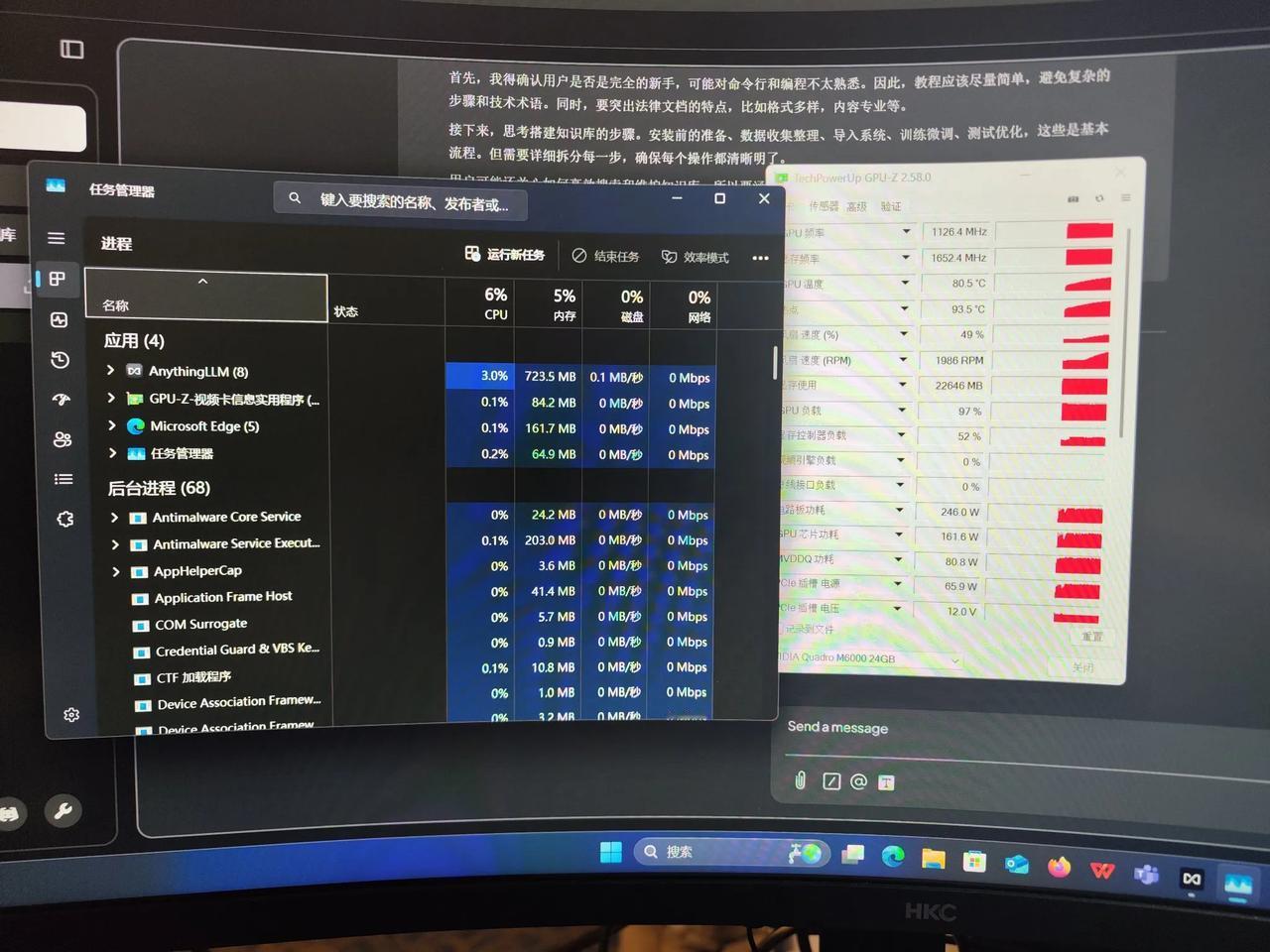

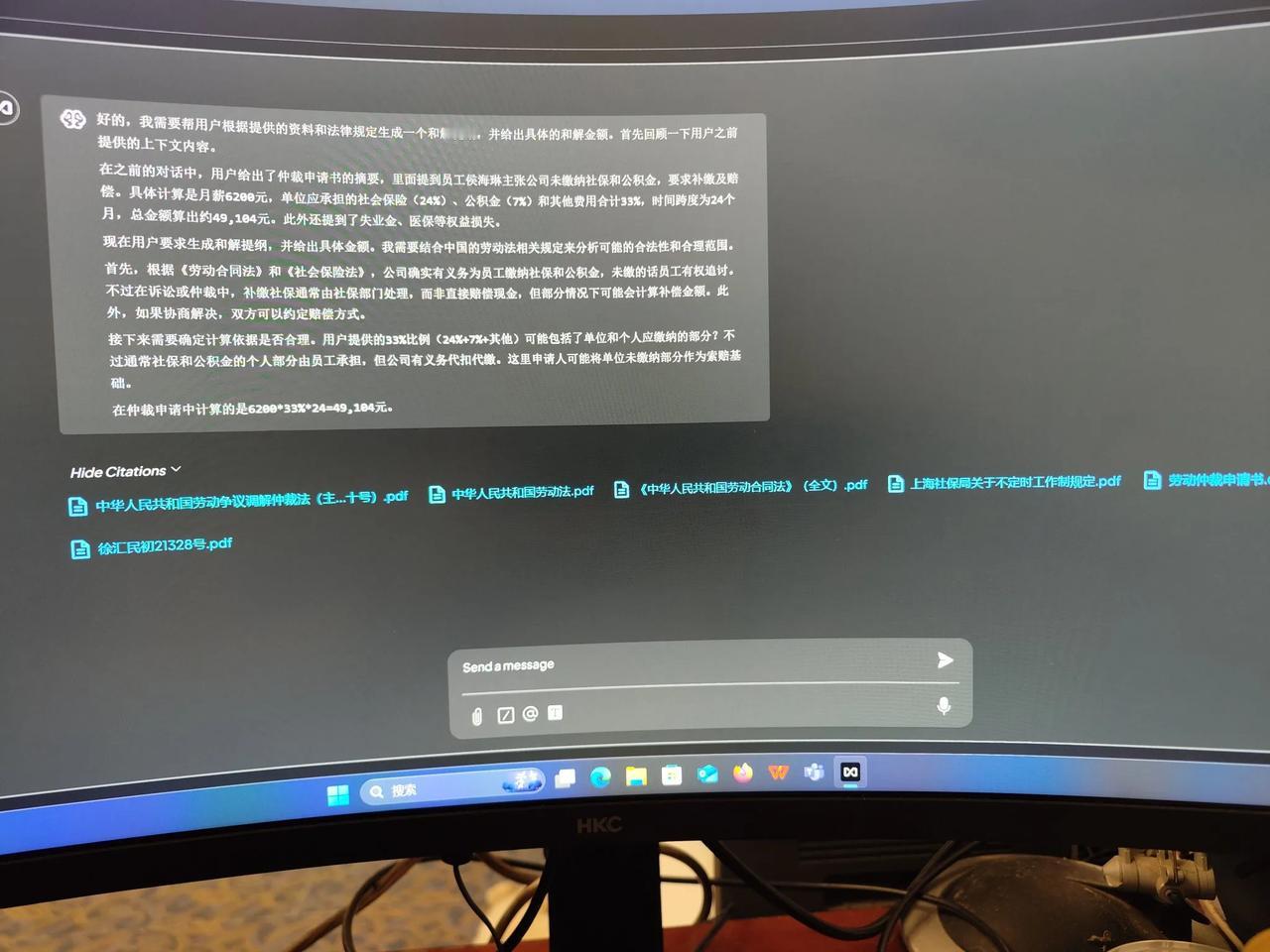

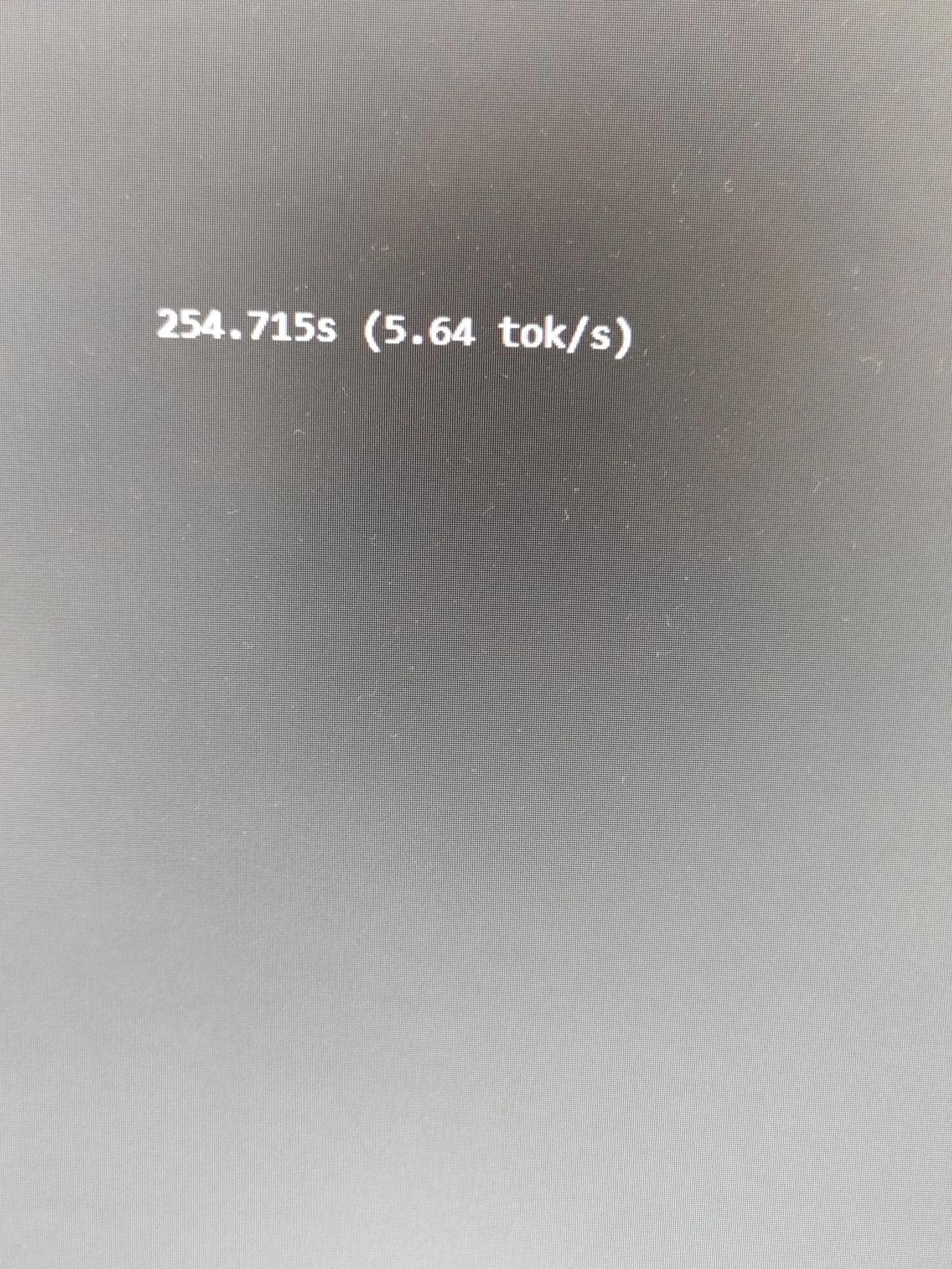

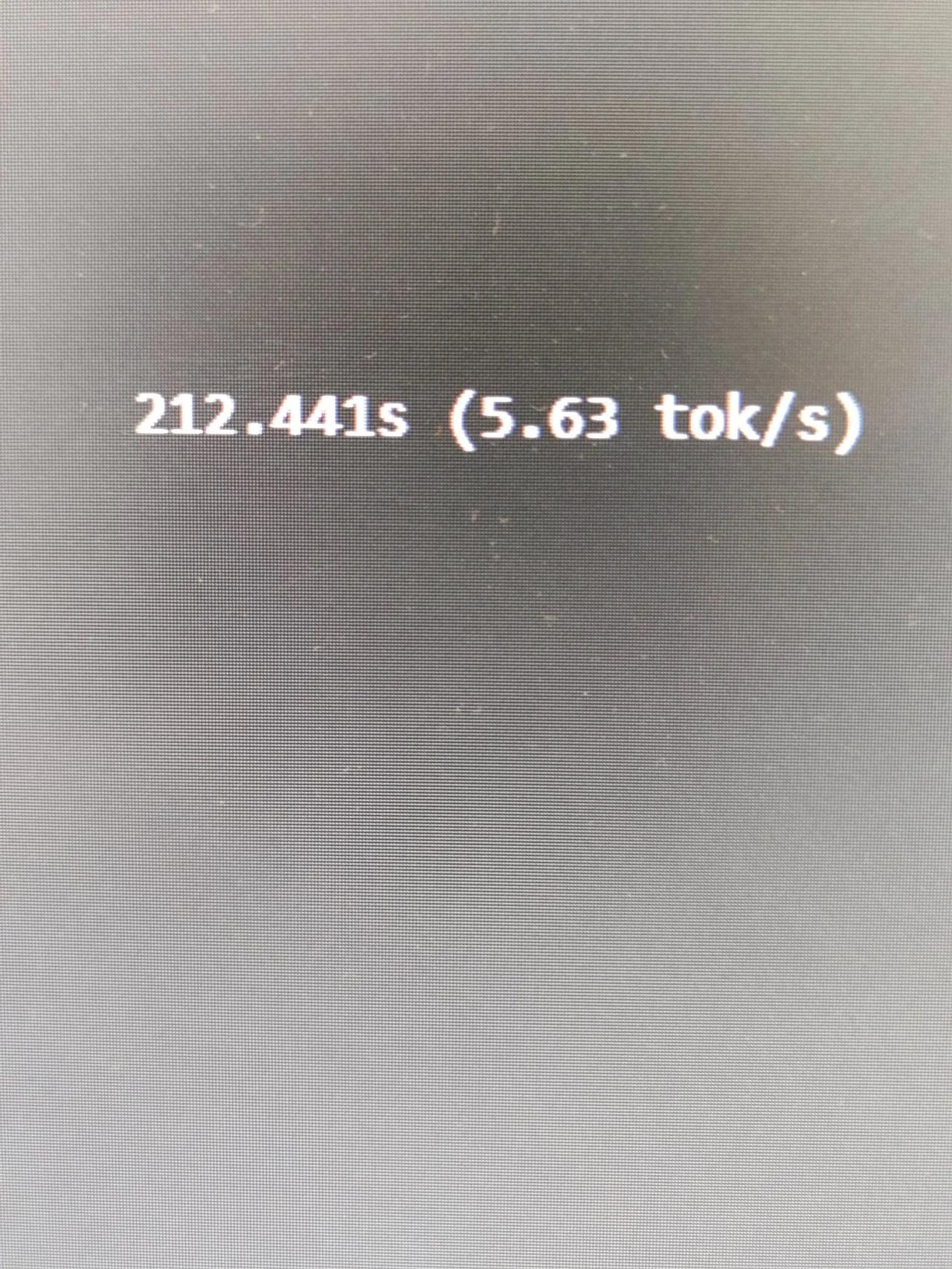

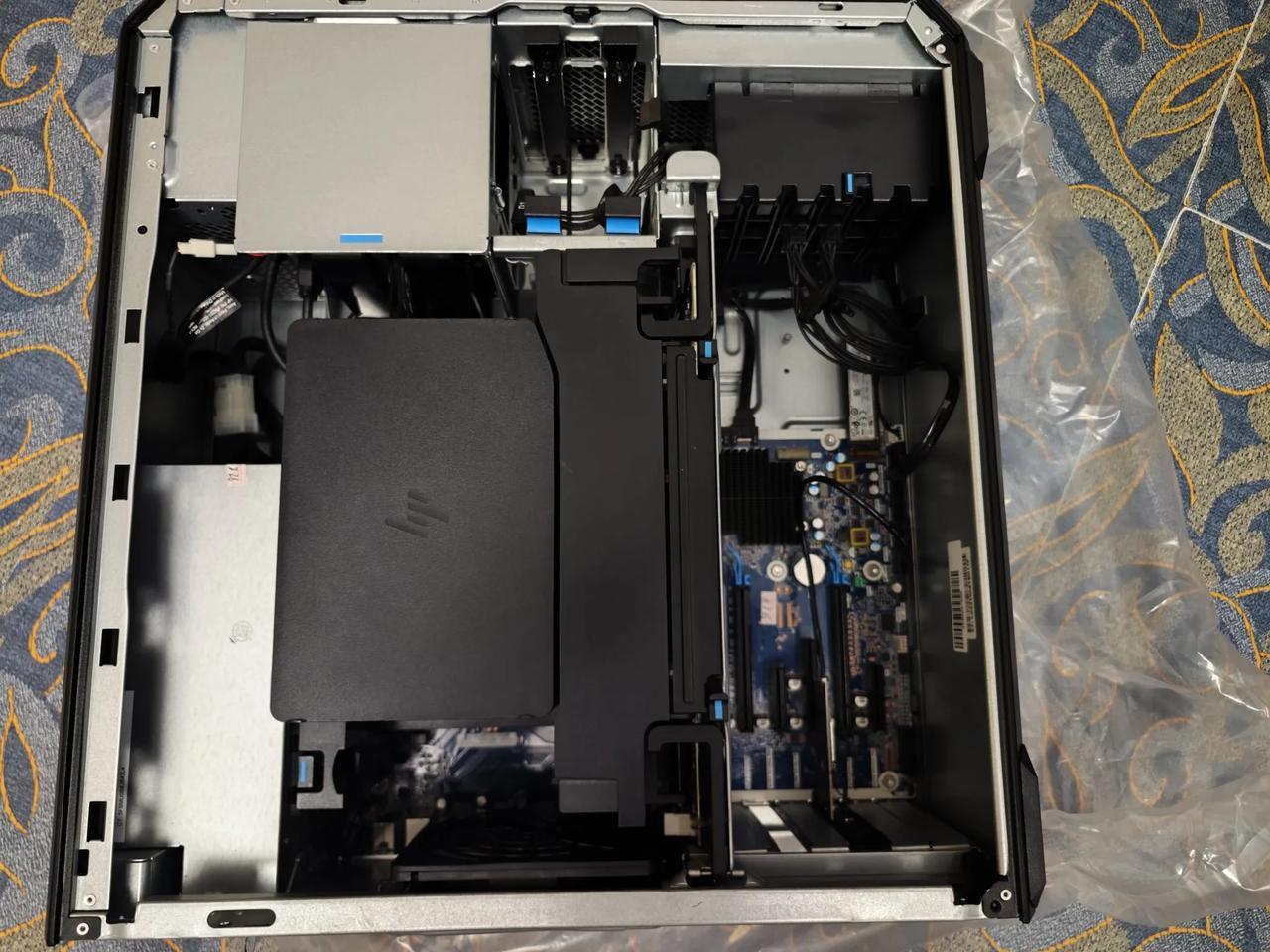

继续用anythingllm搭建本地知识库的话题。 我们常说专业的事情交给专业的人去做是最合适的,我一个专业律师,“不务正业”学习搭建本地法律知识库,确实在有些人看来是如此,但这和我的性格有关。我喜欢自己把握自己工作的进度,特别是日常用到的种种工具。固然交给专业的人省心省力,但从效率上必须由对方说了算,别人又不是你的专业客服。因此,力所能及的软硬件安装,维修都是我自己动手。 刚好昨天有位老友自驾房车路过烟台,他是清华毕业,当年的IT程序员,开发过很多应用软件。近几年一直自驾云游。虽然他未必熟悉Anythingllm等软件的应用,但是他的思路和习惯性解决问题方法能给我一些启示。 目前本地库搭建是成功了,也能运行,就是感觉可能由于缺乏训练,回答出的结果和网络版还是有差距。通过多次实际运行测试,发现在工作站上运行qwq、deepseek32b时,GPU负载拉满,显存拉满,但CPU和内存、硬盘资源占用大约10%左右。二者的推理速度都在5.6-6toks左右,尚可。但当运行超过32B的模型时,2块CPU56核心100%负载,GPU负载0%躺平罢工。[捂脸]推理速度无法承受的慢。 尽管各种测试时,收获不少,但搭建本地知识库,看来会是一个漫长的过程。