论文《大型语言模型的后训练综述》

arxiv.org/pdf/2503.06072

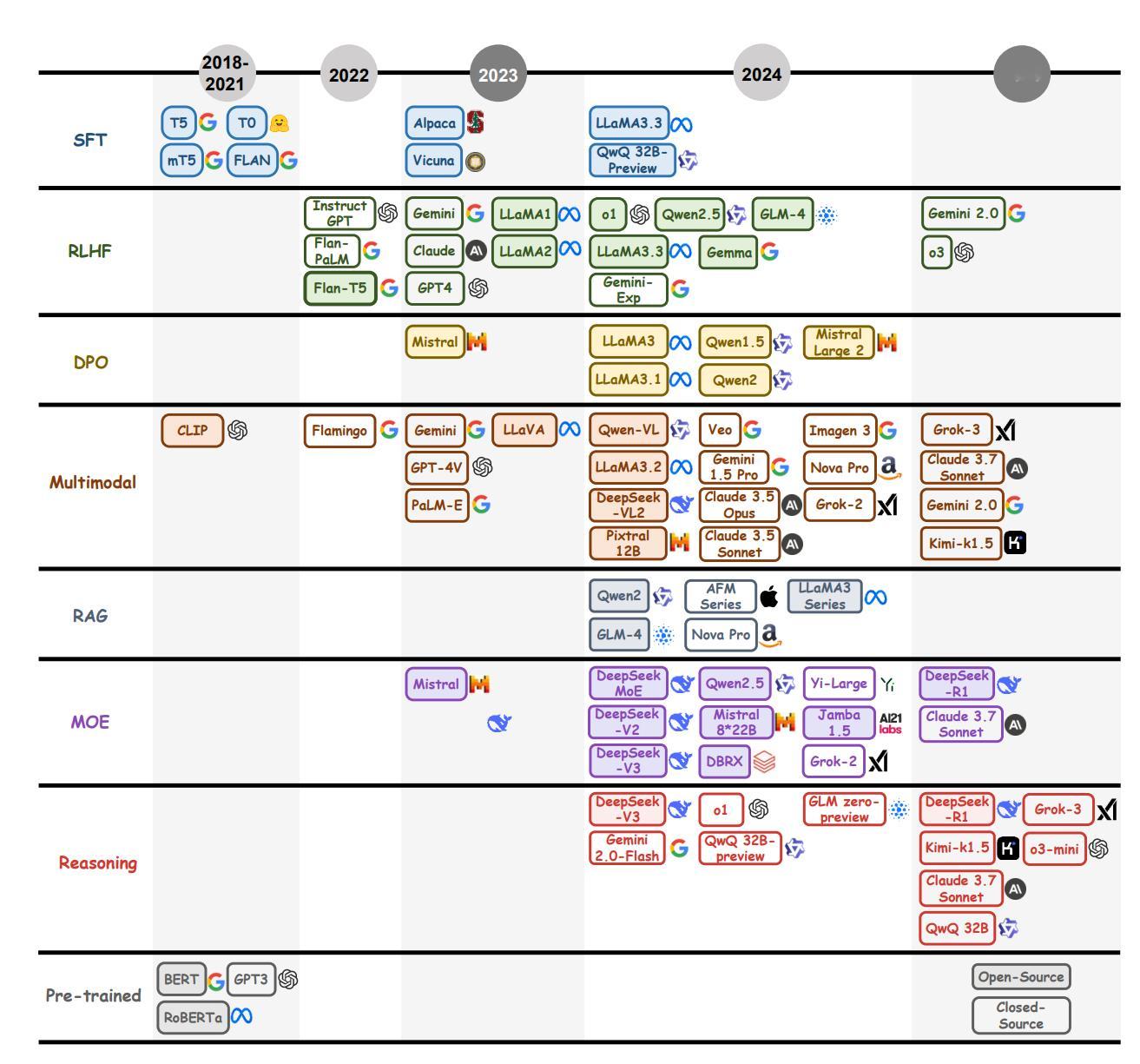

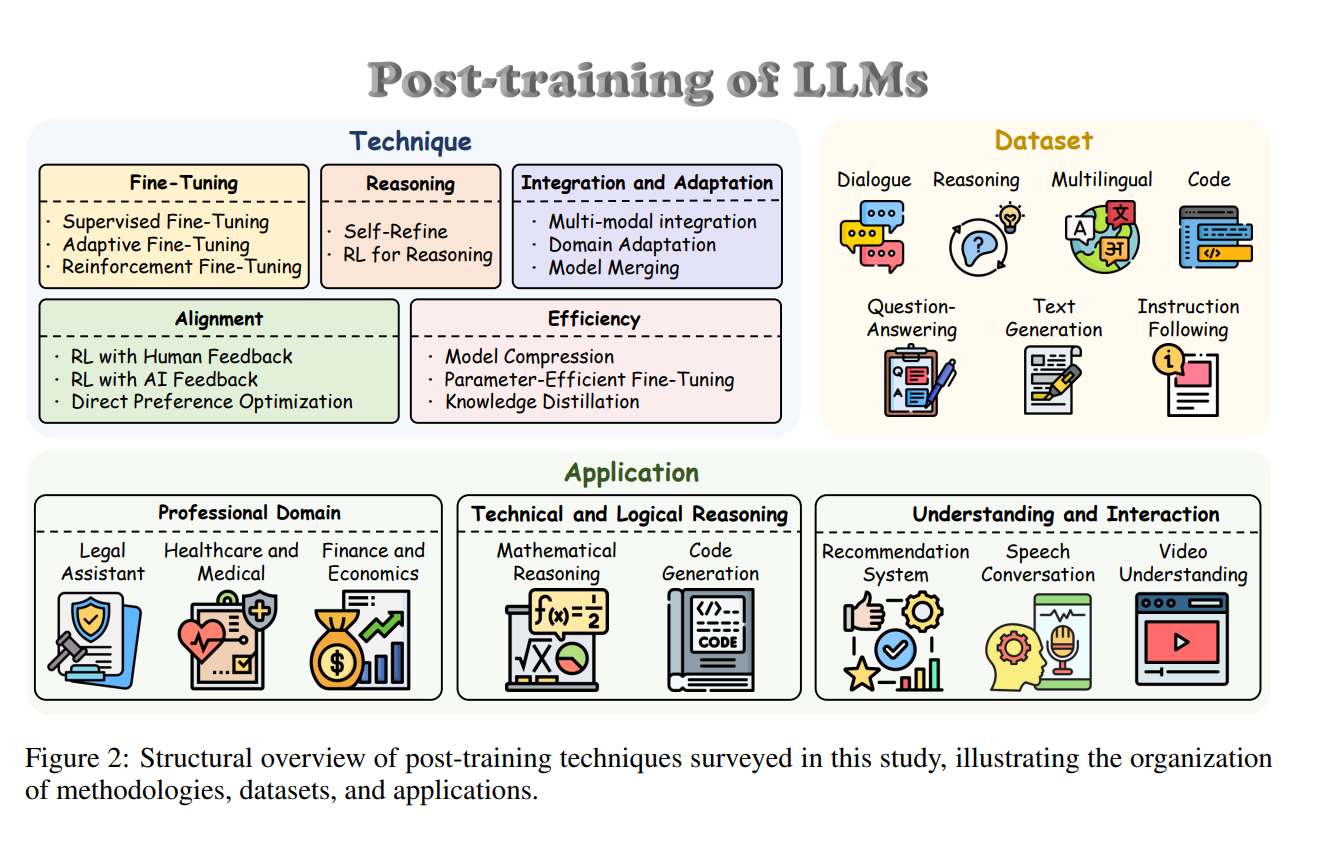

本文全面探讨了大型语言模型(LLMs)的后训练方法,系统梳理了从2018年ChatGPT的初步对齐策略到2025年DeepSeek-R1推理能力提升的演变历程。文章详细分析了后训练的五大核心范式:微调(Fine-tuning)、对齐(Alignment)、推理(Reasoning)、效率(Efficiency)和集成与适应(Integration and Adaptation),并提出了一个结构化的分类体系,涵盖技术、数据集和应用领域。通过深入研究这些方法的发展、挑战和应用,本文为未来的研究提供了方向,并强调了大型推理模型(LRMs)在提升推理能力和领域灵活性中的重要作用。作为首个全面综述后训练技术的研究,本文不仅整合了近年来的最新进展,还为未来大型语言模型的发展奠定了坚实的理论基础。

AI生活指南 AI创造营