Reddit 用户成功不使用GPU运行完整版R1

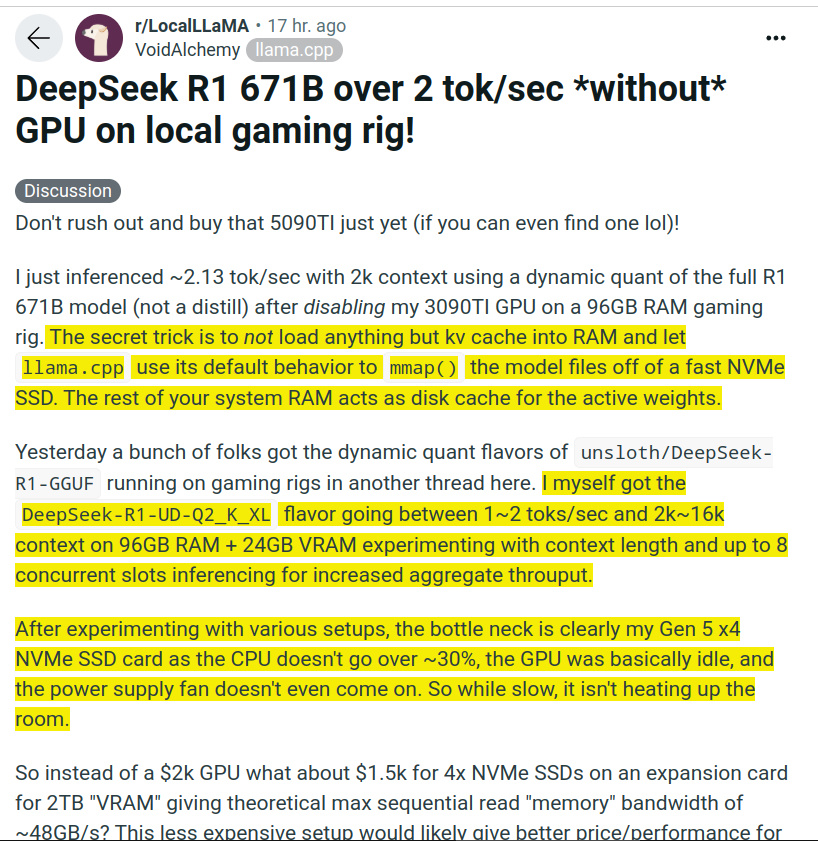

他通过禁用3090TI显卡,在96GB内存主机上使用llama.cpp的mmap技术,将模型权重存储在NVMe固态硬盘中,利用系统内存作为磁盘缓存,实现约2.13 token/秒的推理速度。瓶颈在于PCIe 5.0 x4固态的读取速度。

DeepSeek本地部署瓶颈在内存容量和内存速度,跟CPU、显卡都没太大关系。这位大佬更进了一步,使内存容量的限制都降的更低 [阴险]

PS:Reddit那个人跑的是动态量化版(不同层量化到不同的位数)的R1,把700多个g的原模型量化到大约200g左右。

作者的评价是这个模型的效果比其他30B-70B的模型都要好,但距离原版R1还有差距 [并不简单]