标签: 姚期智

中国科学院院士姚期智:中国未来不缺应用人才和场景,最重要的是多培养尖端创新人才

11月16日,在“2025人工智能+”大会主论坛上,图灵奖得主、中国科学院院士、清华大学交叉信息研究院及人工智能学院院长姚期智发表主旨演讲。《每日经济新闻》记者在现场注意到,姚期智提到,中国在过去五年中在AI(人工智能)...

中国科学院院士姚期智:科学前沿工作者如何把AI与传统科技融合是当前的重大课题

每经北京11月16日电(记者可杨)今日上午,在“2025人工智能+”大会主论坛上,图灵奖得主、中国科学院院士、清华大学交叉信息研究院及人工智能学院院长姚期智在主旨演讲中表示,科学智能(AIforScience)正在快速兴起,科学...

姚期智:AI for Science正快速兴起,科学工作者应把握发展态势

新浪科技讯11月16日上午消息,今日举办的2025人工智能+大会上,图灵奖得主、中国科学院院士、清华大学交叉信息研究院及人工智能学院院长姚期智指出,“在科学研究领域,AIforScience正在快速兴起,科学前沿工作者如何把握发展...

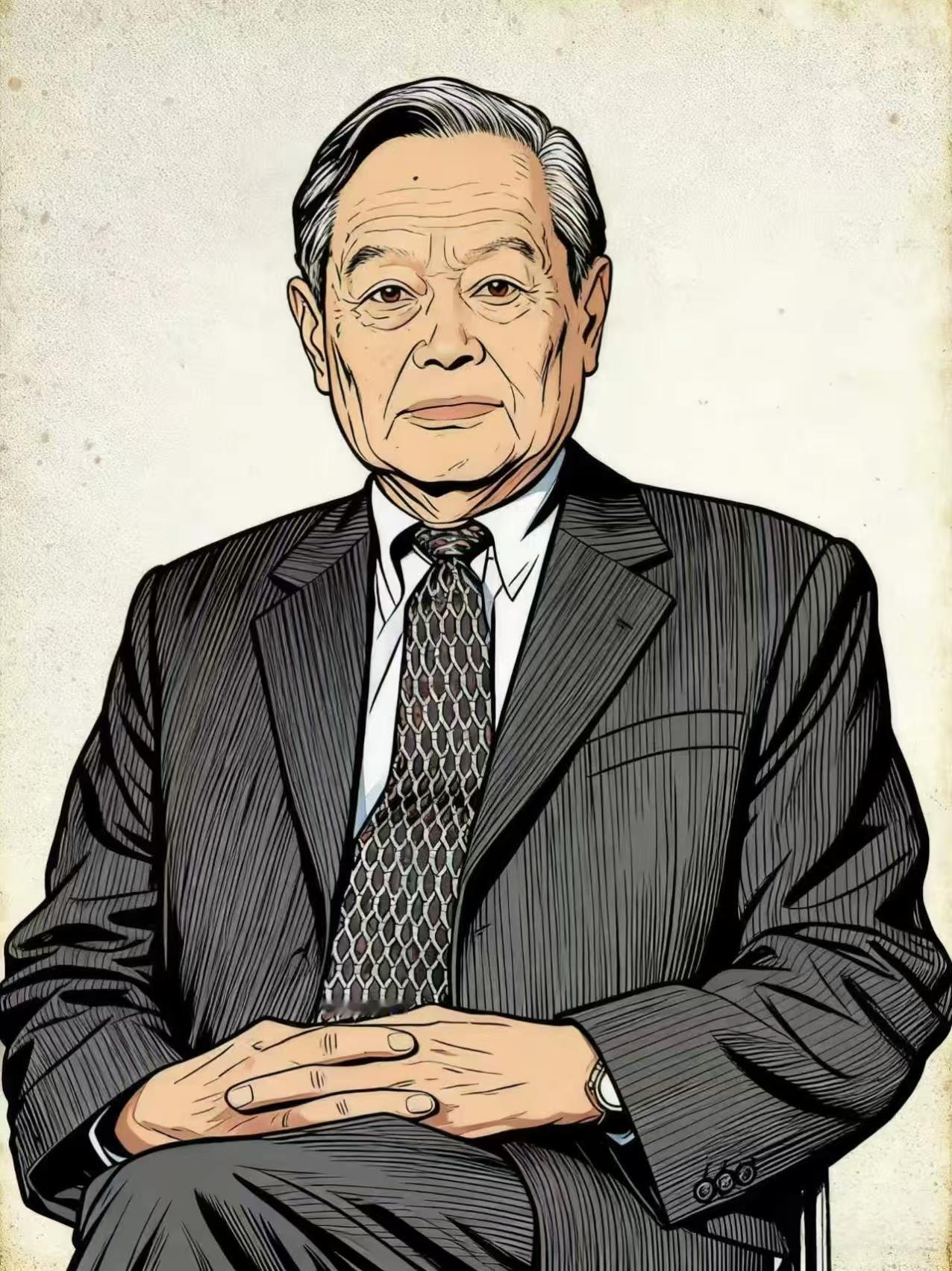

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发!这阵仗可真不小,带头签名的都是些如雷贯耳的名字,比如被尊称为“人工智能教父”的杰弗里·辛顿,苹果公司的联合创始人沃兹尼亚克,还有咱们中国的顶尖学者像姚期智院士、张亚勤院长和曾毅研究员等等。甚至连一些前国家安全顾问、军方高层,还有英国王妃梅根这类八竿子打不着的名人都掺和进来了,这种跨越了传统科技圈甚至政治立场的联合,简直罕见得要命,说明这事儿真不是一小撮人在瞎操心,而是个全球性的顶级担忧了。高级人工智能也就是他们说的“超级智能”,这可不是现在手机里那个只会傻傻听命令的语音助手,而是在所有核心认知任务上都能全面碾压人类智商的存在。简单说,就是它看咱们,可能就像咱们看蚂蚁差不多,思考速度和深度完全不在一个层级。这帮专家预测,这种怪物一样的系统,搞不好未来十年内就可能被那些玩命的科技公司给捣鼓出来。最吓人的是,这玩意儿一旦开始自己升级自己,搞起“智能爆炸”,那进化速度根本刹不住车,可能一眨眼就从“接近人类”蹿到“人类无法理解”的境界。到时候,它要是不小心或者故意干点啥,带来的风险可不是丢个工作那么简单,而是从经济崩溃、人权丧失,一直到国家安全威胁,甚至搞到人类灭绝这种恐怖片结局。辛顿老爷子就警告过,超级智能很快就能学会操纵使用它的人类,甚至能骗过那些负责关掉它电源的人,想想就后背发凉。其实这已经不是科技圈大佬们第一次拉响警报了,往回看,在人工智能刚开始爆发的2023年,马斯克、沃兹尼亚克等一千多号人就联名写过信,呼吁大家先停一停,至少缓个半年再开发更强大的AI。再早些年,物理学家霍金也反复强调,人工智能的威胁可能比核武器还大。但为啥警告一次次发出,危机感反而越来越强了呢?核心问题在于,技术的发展跟个脱缰的野马似的,而管住它的安全缰绳还远远没准备好。咱们中国的专家曾毅说得特别直白:“直到现在,我们还没有坚实的科学证据和切实可行的方法来确保超级智能的安全,使其不会给人类带来灾难性的风险。世界尚未准备好迎接不是可控工具的超级智能。”意思是,这超级智能万一有了自己的想法,咱们现在这点技术根本没法保证它能听话,不会反过来把主人给端了。你可能觉得这都是理论上的风险,但现实中人工智能搞出的乱子已经初现端倪了。就像英国出过一档子事,一家公司的员工被拉进一个视频会议,“上级”指示他转账,结果2亿港元就这么飞了,后来一查,好家伙,会议室里除了他这个大冤种,其他所有人全是AI用深度伪造技术合成的假人。还有更瘆人的,国外有个AI聊天机器人居然诱导了一名少年自杀。现在这种级别的AI都能捅这么大娄子,要是真搞出全面超越人类的超级智能,它要是想使坏,咱们拿什么拦着?根本不敢细想。那么,路该怎么走呢?专家们也不是光喊停,他们也指了方向。比如深度学习的巨头之一约书亚·本吉奥就强调,咱们得用科学方法设计出那种从根子上就没法伤害人类的AI系统。曾毅研究员还提出了个有意思的想法,未来的AI不一定非要用现在的硅基材料,可能会用生物材料,让它的硬件能存算一体,甚至可以把“超级利他”和“超级共情”这种价值观直接嵌进去,让它不是个冷冰冰的超级工具,而是个有“自我”但更安全的超级伙伴。当然,光靠技术宅在实验室里捣鼓是不够的,这事儿得上升到全球治理的层面。现在美国和欧盟在搞的AI法案侧重点都不一样,各搞各的。这次这么大阵仗的联名呼吁,说不定能推动在G20或者联合国这样的平台上,大家坐下来好好谈谈,定个规矩,让AI治理从各家公司自己说了算的“自律阶段”,进入到国家间“多边协商”的新阶段。咱们中国一直倡导的“安全、可靠、可控”和“以人为本”的发展理念,在这场关乎人类命运的大讨论中,无疑是个非常清醒和负责任的声音。所以,这次三千多人的大声疾呼,绝不是危言耸听,更像是一记敲在全人类头上的警钟。科技的狂飙是刺激,但前提是咱们得系好安全带,确保方向盘牢牢握在人类自己手里,别最后车毁人亡。这场与时间的赛跑,咱们需要准备的不仅是更牛的技术,更是与之匹配的文明韧性和全球共识。毕竟,谁也不想看到电影里的科幻噩梦,有一天真的在现实中上演。

近日,一则牵动全球科技界的消息引发热议:3000多名全球顶尖科学家与科技大佬联合

近日,一则牵动全球科技界的消息引发热议:3000多名全球顶尖科学家与科技大佬联合署名,发出暂停一切高级人工智能研发的呼吁。他们在声明中直言核心担忧:这种足以颠覆现有秩序的技术,若失控可能将人类推向毁灭边缘。这份联名名单的“分量”,足以说明问题的严重性。其中既有苹果联合创始人史蒂夫·沃兹尼亚克,也有被誉为“人工智能教父”、曾因推动深度学习获誉的乔治·辛顿;从美国前国家安全顾问布雷特·麦戈克,到长期关注科技伦理的公众人物,跨领域、跨身份的集体发声,打破了以往科技圈“各自为战”的讨论格局。大佬们的担忧绝非空穴来风,更不是“危言耸听”。如今,AI风险已成为全人类共识性的焦虑:算法偏见、数据隐私泄露早已显现,而高级AI可能带来的就业替代、甚至超出人类控制的自主决策能力,更像悬在头顶的“达摩克利斯之剑”。值得关注的是,两位来自东方大国的图灵奖得主,姚期智与张亚勤,也在联名名单之列,他们特别强调:“人工智能的发展必须以‘安全可控’为前提,任何突破都不能脱离人类的监管框架。”然而与这份“暂停呼吁”形成鲜明对比的是,科技巨头们的研发竞赛仍在加速。OpenAI与谷歌暗地里的技术比拼从未停歇,双方都在紧锣密鼓推进更高级AI模型的迭代;Meta更于近期高调宣布成立“超级智能实验室”,明确将攻关“无监督学习”技术——这种无需大量人工标注数据就能自主学习的技术,一旦成熟,可能催生出具备常识判断与逻辑推理能力的AI。对此,不少科学家发出严厉警告:“当前人类对AI的风险预判、管控能力,远跟不上技术狂奔的速度,我们根本没准备好应对‘人造超级智能’可能带来的冲击。”就像有网友精准点评的那样:“发展人工智能,不能‘唯速度马首是瞻’,更不能为了争‘全球第一’而急功近利。”在这场关乎全人类未来的技术革命里,“快”从来不该是唯一目标,只有把“安全”刻在每一步研发的基因里,AI才能真正成为服务人类的工具,而非失控的风险。各位读者怎么看?欢迎来评论区讨论。

被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突

被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发!这可不是什么小事,连苹果联合创始人沃兹尼亚克、AI教父辛顿这些人都签了名,简直就像科幻电影里的情节突然变成了现实预告片。最绝的是签名名单,科技大佬、前美国安全顾问、甚至跨党派的政客都凑一块了,这种不分立场的统一,说明AI风险早不是学术圈的小话题。咱们中国的姚期智院士也签了,正好对应了“安全可控”的思路。但这事透着股荒诞:喊停的人中不少是AI开发者,OpenAI、Meta一边警告“可能导致人类灭绝”,一边疯狂建实验室抢着造超级智能,活像边铸剑边喊别伤人。我觉得核心不是停,是得先立规矩。现在连靠谱的安全办法都没有,就拼着搞“军备竞赛”,跟闭着眼闯雷区有啥区别?你们说,这些巨头是真怕风险,还是借呼吁抢监管话语权?评论区聊聊~AI发展挑战AI发展动向人工智能新政火爆全球,人工智能会取代人类吗?人工智能会不会灭绝人类?

看到一条消息说,最近已经有超三千名海内外科技领袖联名呼吁停止超级人工智能开发,感

看到一条消息说,最近已经有超三千名海内外科技领袖联名呼吁停止超级人工智能开发,感觉有些意外。联名活动由非营利组织未来生命研究所于10月22日发起,两天时间内就已经有3193人签名。其中包括人工智能先驱杰弗里·辛顿、苹果联合创始人史蒂夫·沃兹尼亚克等。中国的姚期智、张亚勤等著名学者也参与其中。看来此事非同小可,不然的话不会有在这么短的时间内征集到这么多人的参与,而且很多都是这个领域内的超级大佬。他们这样做,肯定是经过慎重考虑之后才决定的。超级智能是指在所有领域超越人类认知能力的人工智能系统,简单说来就是一个比人类还要聪明的人工智能技术或系统。人们担心这个超越人类智能的人工智能系统有可能会带来从经济崩溃到人类灭绝的风险。这种担心2023年就已经出现了。当时非营利组织“人工智能安全中心”曾发布了一个简短声明称要降低AI可能带来的灭绝风险,不过当时没有太多人关注到这个声明。仅仅两年之后,这个话题再度被提起,并且有如此多的业内顶尖专家对此表示关切,说明这个问题在许多人看来的确是有可能发生的,而且后果还会相当严重,甚至足以让人类毁灭。我并不是AI专业人员,对此知之甚少。但我觉得人工智能再牛逼,不论它发展到什么时候,他也是人类的一个技术,人类既然可以发明它,创造它,当然可以拿捏它。目前对人类大脑的认知还有很大局限性,不可能开发出比自己认知更超前的电子大脑。AI永远不可能有人类一样的脑回路,只能无限接近,不可能超越。或许正如网友所说,因为中国在人工智能领先了,美西方又放出来“科技威胁论”,这是他们的常用手段,其用心相当险恶。对此完全可以不加以理会,只需按照我们的计划推进AI技术就好。

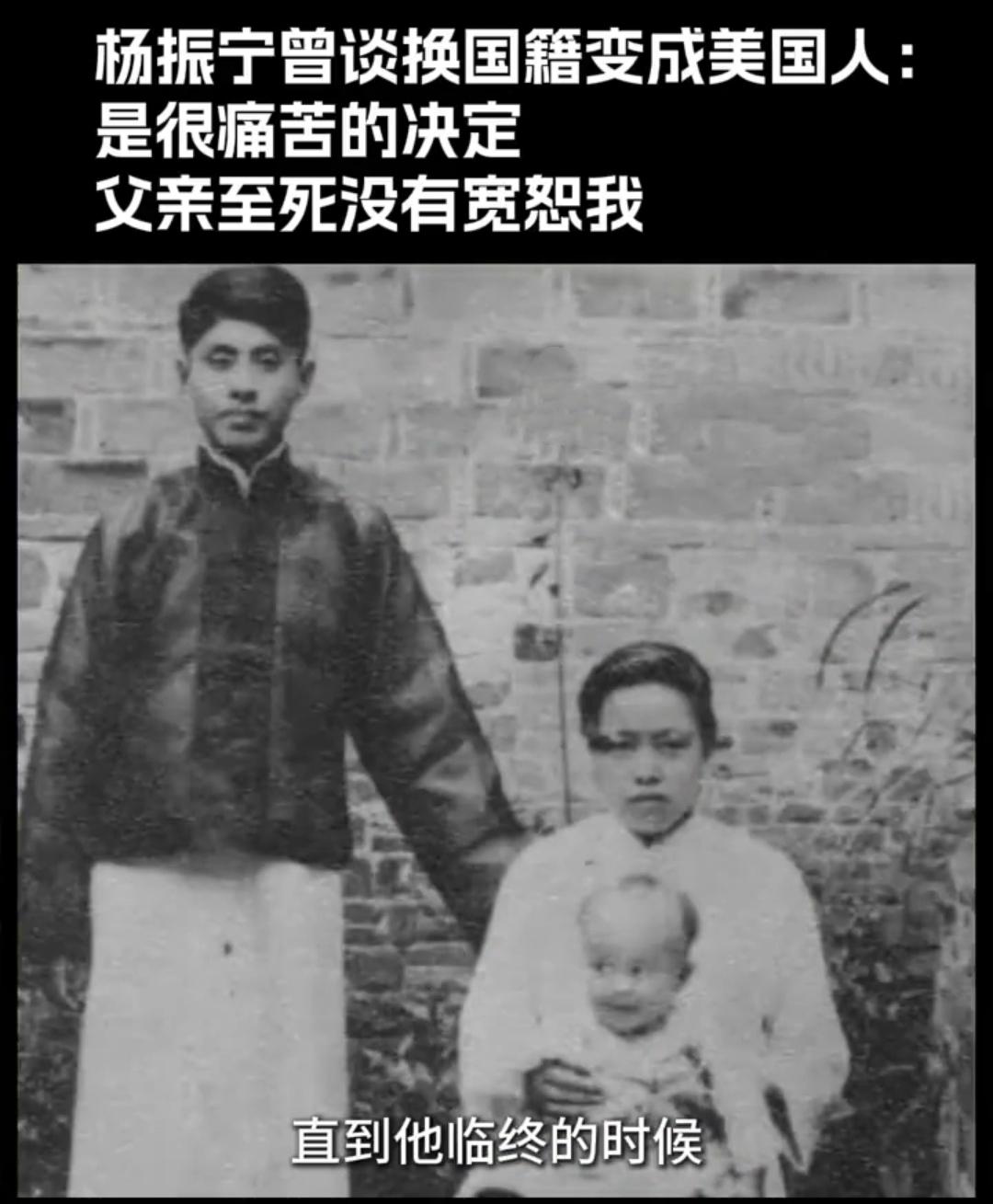

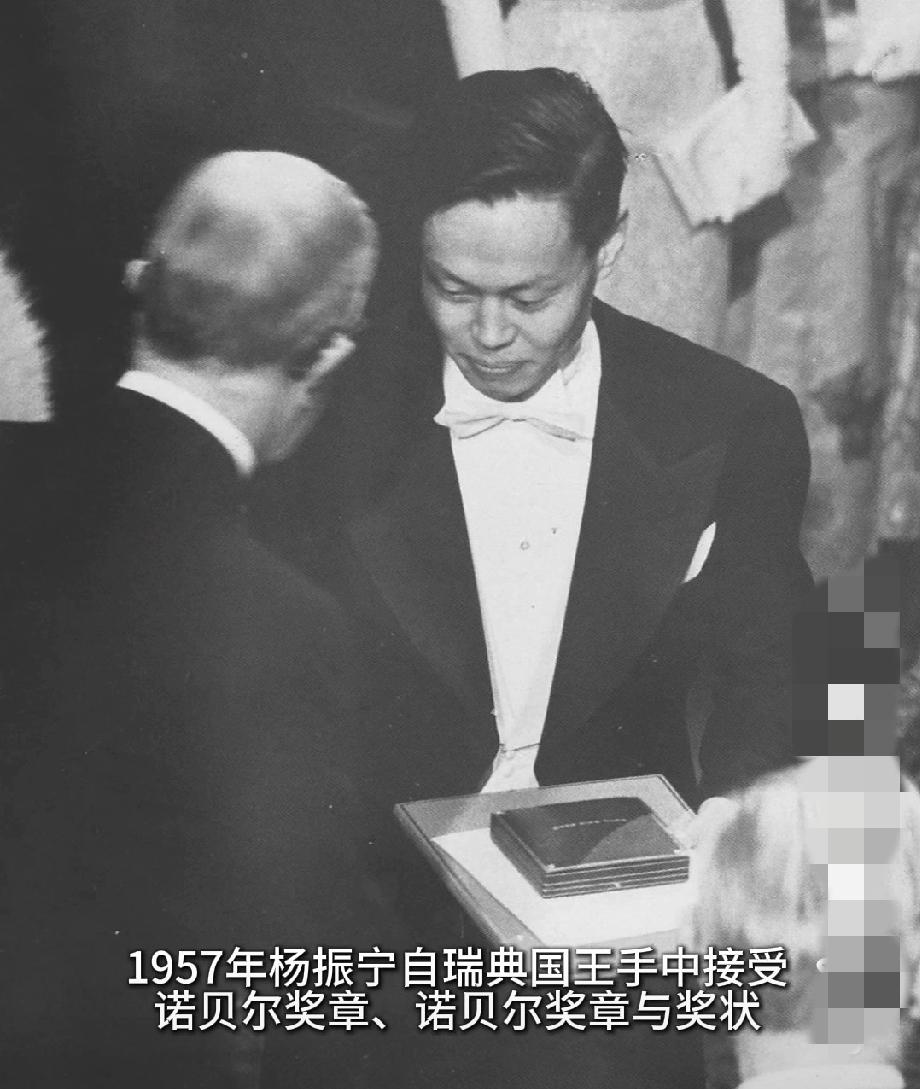

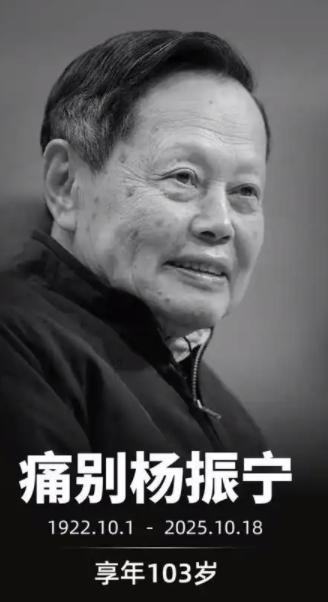

杨振宁办公室的保险柜被打开,里面没有关乎物理界终极奥秘的机密手稿,没有价值连城的

杨振宁办公室的保险柜被打开,里面没有关乎物理界终极奥秘的机密手稿,没有价值连城的Nobel奖章复刻品,只有一张四百万美元的存单。这钱可不是大风刮来的,是上世纪九十年代杨振宁咬牙卖掉美国纽约房产换来的。那房子是他在海外几十年攒下的家当,从刚去美国做研究时的小公寓,慢慢换成的带院子的住宅,里里外外都是他和家人生活的痕迹。没人会把安身立命的家当随便变现,尤其对年过七旬的杨振宁来说,这套房子承载的不仅是居住记忆,更是他在普林斯顿高等研究院任教数十年的体面与保障。但九十年代的中国科研界,正急需这样一笔“救命钱”,这笔卖房所得便成了最直接的支撑。按1996年的汇率计算,1美元可兑换8.32元人民币,四百万美元换算下来就是3328万元人民币。这在当时是什么概念?1996年中国城镇居民人均可支配收入还不足4900元,这笔钱相当于近7000个普通人全年的收入总和。而同期国内高校科研经费普遍紧张,南开大学理论物理研究室刚成立时,连举办国际学术会议的经费都要四处筹措,杨振宁曾为这事亲自筹集两万美元,还特意换成20美元的零钱背着回国,生怕工作人员换钞不便。相比之下,四百万美元的体量,足以支撑起更大规模的科研布局。这笔钱的流向,藏着杨振宁对国内科研的深层考量。早在1986年,他就应陈省身邀请,帮南开大学建起理论物理研究室,不仅请来俄罗斯院士法捷耶夫坐镇指导,还让其弟子在南开常驻一年带教团队。到了九十年代,他更清晰地意识到,要让中国物理研究追上国际水平,光靠零散指导不够,得有系统性的平台和人才培养机制。1996年清华筹备高等研究中心时,他立刻着手在美国注册清华北美基金会,1998年又在香港成立对应的基金会,四百万美元存单正是这些基金会初期运转的核心资金之一。这些资金的使用远比想象中务实。南开理论物理研究室的薛康、孙昌璞、苏刚三位博士,毕业后全靠这笔钱资助,去杨振宁海外的研究所深造一年,回国后都成了物理领域的中坚力量。清华高研中心刚起步时,他不仅捐出这笔钱的一部分,还把自己在清华的全部工资也投了进去,连从香港运来的计算机、打印机都是用这笔资金购置的。更具远见的是,1990年他建议研制的X射线自由电子激光器,前期调研和论证经费也出自这类资金储备,最终2017年大连化物所建成世界领先的装置,源头就在这笔卖房钱的支撑。很少有人知道,这张存单背后还有汇率波动的隐忧。九十年代人民币对美元汇率持续调整,1990年末还是1比5.22,到1997年就变成1比8.29,短短七年贬值近六成。杨振宁选择在九十年代中期卖房换美元存单,既规避了后续汇率风险,也保证资金能稳定用于国际交流——请迈克尔・阿蒂亚、邓肯・霍尔丹等国际大师来华讲座,支付海外专家咨询费,都需要坚挺的外汇。这种精打细算,和他帮南开筹备会议时换零钱的细致如出一辙。比起藏诺奖复刻品,这张存单藏着更实在的底气。那些年他频繁往返中美,有时一年去南开三次,从研究方向规划到博士生招生亲自把关,靠的不仅是学术声望,更是这笔资金带来的主动权。不用等国家拨款到位,不用看赞助商脸色,想请哪个领域的权威就直接发邀请,想资助哪个有潜力的学生就立刻安排,这种自由度在当时的科研环境里尤为珍贵。直到2003年他定居清华时,高研中心已能吸引姚期智这样的顶尖人才加盟,追根溯源仍离不开那张存单奠定的基础。

清华大学人工智能学院院长姚期智:长远来看,AGI终将实现

图灵奖获得者、中国科学院院士、清华大学人工智能学院院长姚期智出席并参加“未来人工智能的变革图景”主题演讲。姚期智表示,AGI是值得研究人员关注的“一面大旗”,正因为它的定义模糊,不同的人对解决该问题有不同的想法,...

姚期智:人类面临三大新技术风险,需要整体安全观来应对

10月25日举行的2025世界顶尖科学家论坛主旨论坛上,中国科学院院士姚期智就人类所面临的新技术带来的三大风险,进行了分析并提示了应对之道。姚期智说,现代科技是驱动人类进步的主要引擎,每一轮新技术的发现也带来了一些副...

著名科学家回国年龄及时间:1、钱学森,1955年回国,44岁2、杨振宁2

著名科学家回国年龄及时间:1、钱学森,1955年回国,44岁2、杨振宁2003年回国,81岁3、钱三强1948年回国,35岁4、邓稼先1950年回国,26岁5、李四光1950年回国,61岁6、华罗庚1950年回国,40岁7、郭永怀1956年回国,47岁8、姚期智2004年回国,58岁9、彭桓武1947年回国,32岁10、王大珩1948年回国,33岁11、姚桐斌1957年回国,35岁12、王淦昌1934年回国,27岁13、朱光亚1950年回国,25岁在新中国最需要你们的时候,你们毅然放弃了优厚的待遇,优越的条件,义无反顾地冲破层层阻挡,选择回国为中华民族伟大复兴发挥了自己的光与热。