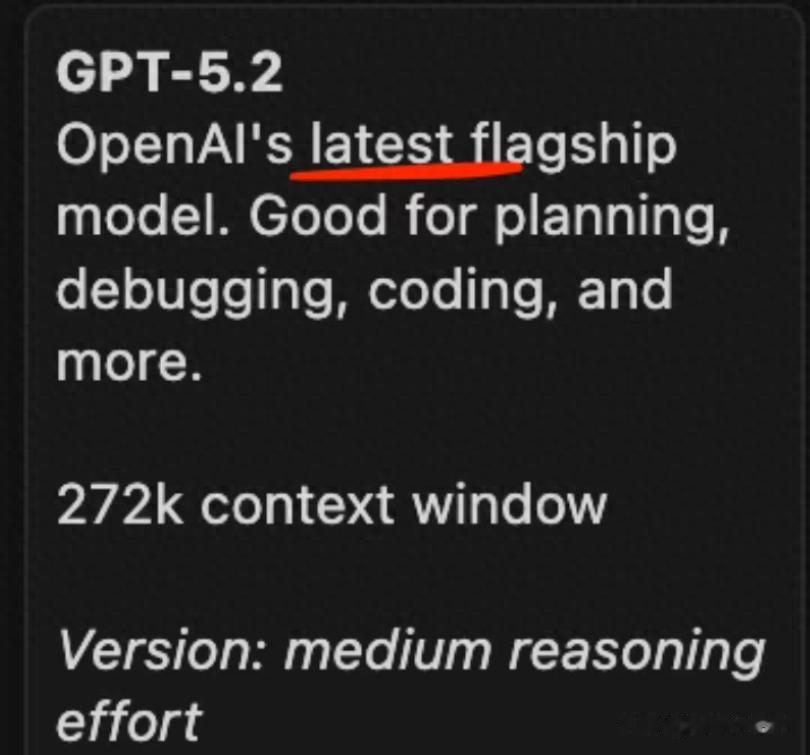

就在盘后,有一个消息引发市场关注,OpenAI预计随时上线GPT-5.2,并有海外的用户已经看到GPT-5.2的蛛丝马迹。

从这周以来,面对谷歌Gemini 3在多模态与长文本推理上的强势突破,OpenAI CEO山姆·奥特曼亲自下令暂停购物广告、资讯推送等非核心项目,将全部工程资源押注于代号“Garlic”的新模型。

结果,便是我们今天看到的GPT-5.2,可能是一个专为编程、科研与高精度逻辑任务打造的“AI”。

而这场突袭式发布,或许也可以看得出,当下大模型竞赛已从“技术演进”进入“快速迭代”阶段。

而在这个过程中,算力基础设施需求或许会被放大。

GPT-5.2可能不是“5.1+”的简单升级尽管名为“5.2”,但多方信源流出,这绝非GPT-5的小幅优化。

其三大核心突破,直指当前AI落地的痛点所在:

1、全局代码理解能力

根据公开的报道,GPT-5.2或许能解析整个代码仓库的依赖结构。

也就是当你修改一个函数,它会自动同步更新所有调用该函数的文件,这意味着,AI首次真正具备“系统级开发思维”,有望重塑IDE生态。

2、数学与学术推理引擎重构

针对科研、金融等高精度场景,新模型内置符号推理模块,支持形式化验证与定理推导。根据市场测算,其在特定基准测试下,在MATH Benchmark和ProofNet上的得分已超越Gemini 3。

3、模块化企业部署架构

支持按需加载功能模块(如审查、私有知识库),大幅降低企业定制门槛。

中小团队也或许能以合理成本部署“专属GPT-5.2”。

这些能力的背后,是训练与推理算力需求的指数级增长。

据The Verge报道,GPT-5.2的推理吞吐量比GPT-4提升3倍,但单次响应所需FLOPs却仅增加30%,这得益于其底层硬件加速架构的全面优化。

二、算力需求或许还在放大当OpenAI、谷歌、Anthropic、xAI(马斯克)纷纷加速模型发布节奏算力需求正在“结构性增长”。

训练侧,根据公开报道,GPT-5.2有望依托超万卡GPU集群,采用新型分布式训练框架(代号Shallotpeat),解决数据瓶颈。

推理侧,企业级API调用量激增,要求毫秒级响应与高并发支持。

边缘侧,手机、智能眼镜等终端开始集成轻量化推理引擎,推动端侧算力芯片需求。

三、哪些方向还可以关注?目前市场还在发酵GPT-5.2的相关技术,在这方面来看,或许有三大方向值得关注:

1、光模块

800G向1.6T升级或许已成确定趋势。

国内龙头厂商在良率与交付能力上全球领先,直接受益于英伟达GB200 NVL72等新一代AI服务器放量。

2、液冷与电力配套

万卡集群功耗可达百兆瓦级,传统风冷难以为继。

全浸没液冷、高压直流供电、智能配电系统将可能成为新建AI数据中心的标配。

3、国产算力生态

在全球持续加大推进AI大模型迭代之下,国内在这方面也不断发力,华为昇腾、寒武纪思元、百度昆仑芯等国产方案加速落地。

政策扶持+真实场景验证,或许推动国产算力进入良性循环。

写在最后,AI的未来

写在最后,AI的未来Gemini 3再到GPT-5.2,可以看出当前AI技术仍在不断迭代。

而迭代的背后,靠的不是灵光一现,而是其背后庞大的GPU集群、高速互联网络与自动化运维体系。

未来,大模型将越来越像“水电煤”,看不见,但无处不在,需求或也是持续的。

特别声明:以上内容绝不构成任何投资建议、引导或承诺,仅供学术研讨。

如果觉得资料有用,希望各位能够多多支持,您一次点赞、一次转发、随手分享,都是笔者坚持的动力~