说实话,这次谷歌没再跟谁比跑分,它直接换了个赛场。

就在前晚,Gemini 3 来了。不同于以往那些还要你费劲打字、贴代码的“聊天框”,这次给人的感觉完全变了。如果说以前的AI是住在服务器里的“百科全书”,那Gemini 3 就像是突然站在了你身边,和你共享同一双眼睛、同一对耳朵的“活人”。

它最大的突破,根本不是什么文学创作能力,而是对物理世界的暴力解构。

它不再需要你把现实“翻译”成文字,它能直接看懂现实。

我在外网看到一个极具震撼力的实测案例,完全刷新了我对AI的认知。

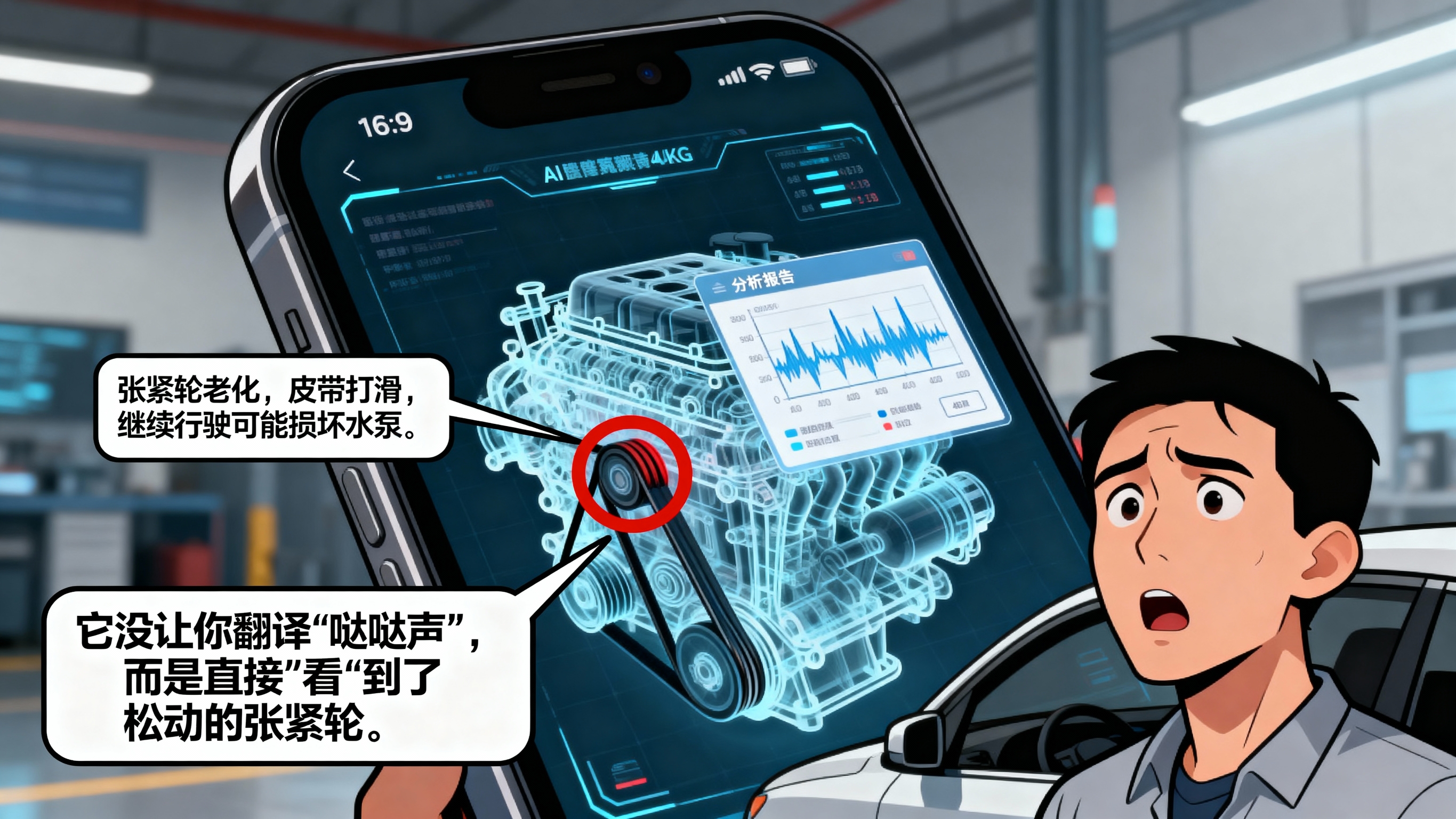

一位博主的车在半路抛锚了,引擎盖下传出奇怪的异响。他不懂修车,要是搁以前,他得先去搜索“汽车引擎哒哒哒响是怎么回事”,然后在一堆广告和无效信息里崩溃。

但这次,他直接打开Gemini 3 的视频模式,把镜头对准了正在震动的引擎,什么都没说,只是问了一句:“这声音正常吗?”

Gemini 3 的反应快得惊人。它结合了视觉(看到了某根皮带的松动)和听觉(分析了异响的频率),直接在屏幕上圈出了故障点,并给出了判断:“张紧轮松动导致皮带打滑,建议不要继续行驶,这不仅是噪音问题,可能会打坏水泵。”

这一刻,我才真正意识到“原生多模态”有多可怕。

它不需要你懂行话,不需要你描述“哒哒声”还是“咚咚声”,它像个拥有三十年经验的老修车师傅,看一眼、听一耳朵,问题就找到了。

这事儿对咱们普通人意味着什么?

这意味着“专业知识的获取成本”被无限趋近于零。

以前,医生、律师、工程师之所以值钱,是因为他们脑子里有庞大的数据库,并且能通过“望闻问切”把现实情况和数据库对上号。我们普通人因为看不懂、听不出,只能花钱买他们的经验。

但Gemini 3 正在打破这堵墙。

当AI能直接“看”X光片,“听”机器故障音,“读”复杂的电路图时,一个外行也就拥有了准专家的判断力。

这才是“搜索”的终局:不是给你一堆链接让你自己找答案,而是直接给你解决方案。

对于我们国内的开发者和创业者来说,这其实指明了一条比“套壳聊天”更宽的赛道。

别再盯着怎么让AI写诗、写周报了。Gemini 3 告诉我们,未来的机会在“现场”。

想象一下,一个装修工人戴着AR眼镜,AI实时告诉他墙里的管线走向;一个新手厨师对着锅,AI提醒他“油温高了,现在下肉”;一个在国外旅游看不懂菜单的人,扫一眼不仅能翻译,AI还能告诉你“这道菜太辣,不适合你的口味”。

这种“伴随式”的智能,才是AI真正融入生活的样子。

谷歌这次确实想明白了。它没去卷那些虚无缥缈的“意识”,而是利用自己在安卓生态、搜索数据上的老底子,试图打造一个无处不在的“全能助手”。

当然,现在的Gemini 3 肯定还有误判的时候。那个修车的例子也许是幸存者偏差,也许它有时候还是会把拖拉机当成法拉利。但方向已经定在那儿了。

这种变化是不可逆的。我们正在从“人适应机器”的时代(学习怎么搜关键词),跨入“机器适应人”的时代(它看你所看,想你所想)。

技术从来不等人。

虽然咱们现在只能隔岸观火,但千万别把这当成热闹看。当你还在纠结哪个AI写文案更好的时候,真正的巨头已经开始琢磨怎么接管你的眼睛和耳朵了。

未来的世界,可能真的不需要那么多“专家”,但一定需要能熟练驾驭这种“超级外脑”的超级个体。

别被落下了。

#Gemini3 #谷歌AI #黑科技 #未来生活 #人工智能下半场

参考信源:

《谷歌 I/O 2024 大会全汇总:Project Astra 展现未来 AI 助手形态》,36氪

《深度解读谷歌 Gemini 1.5 Pro:多模态大模型的里程碑》,极客公园

《谷歌 DeepMind 发布新一代 AI 智能体 Project Astra》,量子位

《GPT-4o 与 Gemini 1.5 Pro 核心能力对比分析》,腾讯科技

声明:此文90%以上系原创,极少素材借AI辅助,图片均为AI原创,内容保持客观准确,信息皆源于可靠且可查证之处,其目的在于提供有价值的信息,倡导建设性讨论,无不良引导。