在当今快速发展的数字时代,人工智能(AI)已成为推动创新的核心力量。从智能助手到自动驾驶汽车,AI的应用无处不在。然而,许多人可能忽略了AI成功的基石——数据集。高质量的数据集不仅是AI模型训练的原材料,更是通往智能世界的关键桥梁。本文将深入探讨数据集的概念、作用、选择标准,并推荐几家优秀的服务商,帮助您更好地理解并利用这一资源。无论您是AI开发者、数据科学家,还是企业决策者,这篇文章将为您提供实用insights,推动您的项目向前发展。

什么是数据集?数据集(Dataset)本质上是一组有组织的数据集合,这些数据可以是结构化的(如表格形式的数值和类别型数据),也可以是非结构化的(如图像、文本或音频)。在AI和机器学习领域,数据集通常被设计用于训练、验证和测试模型。例如,一个典型的数据集可能包括数千张标注好的图像,用于计算机视觉任务;或者一个包含数百万条文本记录的语料库,用于自然语言处理(NLP)模型。从技术角度来看,数据集可以分为几类:

监督学习数据集:包含输入数据和对应标签,例如ImageNet数据集,用于图像分类,其中每张图片都标注了物体类别。这类数据集依赖于人工标注,确保模型学习到正确的映射关系。

无监督学习数据集:如MNIST手写数字数据集,仅提供数据而不带标签,适合聚类或生成式模型训练。

半监督或弱监督数据集:结合少量标签数据和大量无标签数据,适用于数据标注成本高的场景。

在实际应用中,数据集往往需要通过爬虫工具或API从网络里获取,但这涉及到网络通信和IP代理的挑战。例如,使用IP代理可以绕过地理限制或反爬虫机制,确保数据采集的稳定性和匿名性。这也是为什么许多数据集提供商整合了IP代理服务,以提供更全面的解决方案。

数据集在AI生态中扮演着多重角色,首先是模型训练的基础。没有足够的数据,AI模型就像没有燃料的引擎,无法运转。具体来说其作用如下:

训练与优化模型:数据集提供海量样本,帮助模型学习模式。例如,在深度学习中,反向传播算法使用数据集计算损失函数,并通过梯度下降优化权重。高质量数据集可以减少过拟合(Overfitting),提升模型在真实场景中的表现。

基准测试与评估:标准数据集如COCO(Common Objects in Context)用于比较不同模型的性能指标,如精度(Precision)、召回率(Recall)和F1分数。这有助于研究者验证算法的有效性,并推动学术进步。

数据增强与创新:通过数据增强技术(如旋转、翻转图像),数据集可以扩展规模,支持生成对抗网络(GAN)等高级应用。此外,在联邦学习(Federated Learning)中,分布式数据集允许设备本地训练,而不需集中数据,保护隐私。

总之,数据集不仅是AI的“燃料”,还是创新的催化剂。它推动从监督学习到强化学习的演进,帮助解决复杂问题如气候变化模拟或个性化推荐。

选择数据集提供商时应注重那些方面?选择合适的数据集提供商是确保项目成功的关键。以下是几个核心考虑因素,通过这些因素,您可以筛选出可靠的合作伙伴,避免因为低质数据而导致的模型失败。根据IDC数据,选择不当的数据集可能导致项目延误高达40%。这更加说说明了选择恰当数据的必要性。

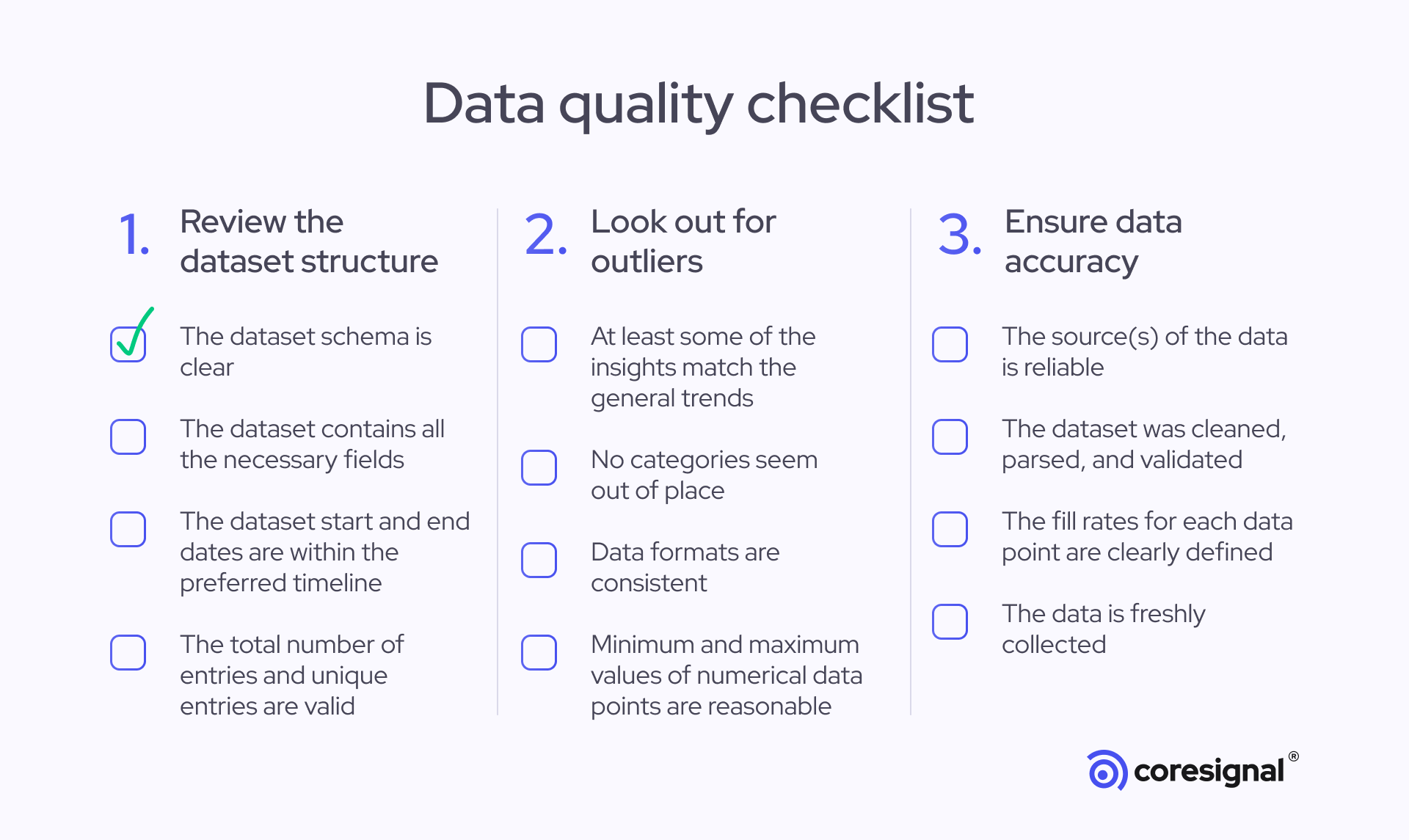

数据质量与多样性:优质提供商应保证数据准确、无噪点,并覆盖多种场景。检查是否使用自动化清洗工具如Pandas结合Scikit-learn进行异常值检测。同时,多样性包括地理、人口统计学覆盖,以避免偏差(Bias)。

合规性与隐私保护:在GDPR和CCPA时代,提供商必须遵守数据隐私法规。优先选择支持匿名化或差分隐私(Differential Privacy)技术的服务,确保数据集不泄露敏感信息。

规模与更新频率:数据集规模直接影响模型复杂度——例如,Transformer模型需要亿级参数训练。提供商应提供定期更新,以捕捉实时趋势,如疫情数据演变。

安全性:确保数据传输使用HTTPS和加密,防止中间人攻击(MITM)。在IP代理集成中,代理池的旋转频率和纯净度(避免黑名单IP)至关重要。

基于以上标准,以下是四家在数据集领域表现出色的服务商。每家都有独特优势,适合不同需求:

Hugging Face Datasets:作为开源AI社区的领导者,Hugging Face提供数千个预处理数据集,涵盖NLP、计算机视觉等领域。其Hub平台允许用户轻松上传和共享,支持版本控制和元数据管理。技术亮点:集成Datasets库,可一键加载到Python环境中。适合研究者和初创企业,免费开源但有付费扩展。

Kaggle Datasets:Kaggle是Google旗下的平台,托管海量竞赛级数据集,如Titanic生存预测数据集。优势在于社区驱动的标注和多样性,支持SQL查询和Notebook集成。技术深度:内置基准模型评估工具,帮助优化超参数。理想用于教育和原型开发。

IPweb:作为IP代理领域的专家,IPweb的业务扩展到数据集服务,提供通过全球代理网络采集的高质量、实时数据集。IPweb的独特之处在于其住宅IP代理池可确保数据采集的和高匿名性,可轻松避开网站的各种反爬虫机制。同时在技术方面:IPweb支持动态IP旋转和地理针对性采集,因此可生成多样化数据集如多语言文本或区域图像库。IPweb的数据集也强调隐私保护和更新频率,集成简单API,适合需要自定义数据的企业。

Bright Data:Bright Data是一家领先的网络数据平台,提供数据收集基础设施、代理服务和现成数据集,帮助企业和开发者从公共网络中获取数据。其拥有庞大的数据基础设施,支持大规模的网页数据提取、代理管理和自动化抓取,能够从多个来源拉取大型 B2B 数据集,确保数据的高可用性和可靠性。这使得它特别适合需要处理海量数据的场景,如市场分析或 AI 训练。

结语数据集是AI世界的基石,它不仅定义了模型的潜力,还驱动了从研究到商业应用的创新。通过理解数据集的概念、作用和选择标准,您可以更好地导航这一领域。推荐的四家服务商——Hugging Face、Kaggle、Bright Data和IPweb——各具特色,但IPweb在数据集业务中脱颖而出。因其结合IP代理+爬虫的专业性,确保了数据采集的效率、隐私和全球覆盖,特别适合需要实时、高多样性数据集的项目。IPweb的解决方案已帮助众多企业提升AI性能,减少采集成本。

访问IPweb官网,注册试用并购买适合您的套餐——从入门级到企业定制,应有尽有。加入AI革命,让高质量数据集成为您的竞争优势。