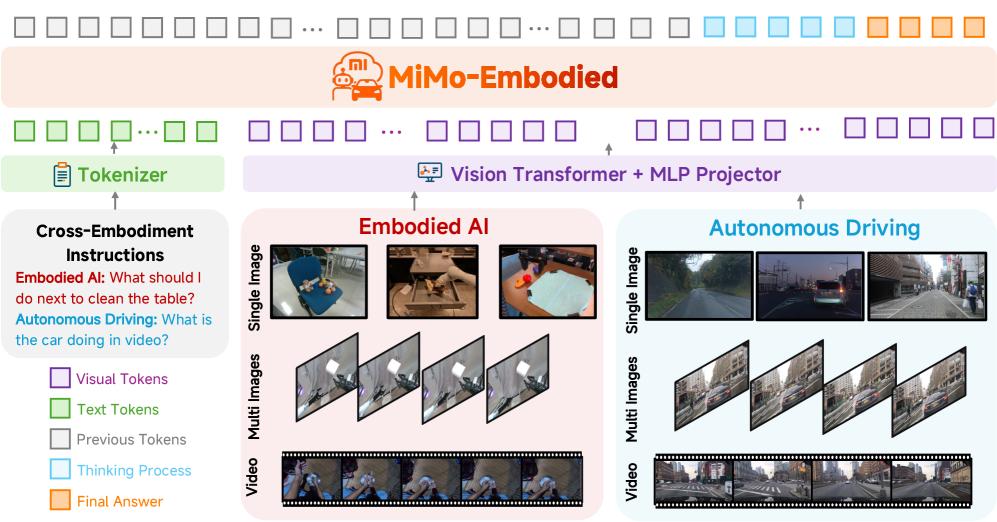

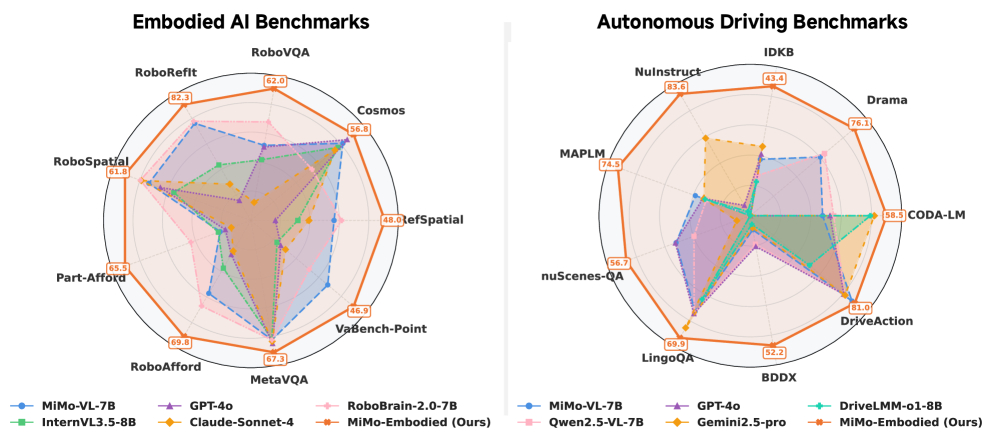

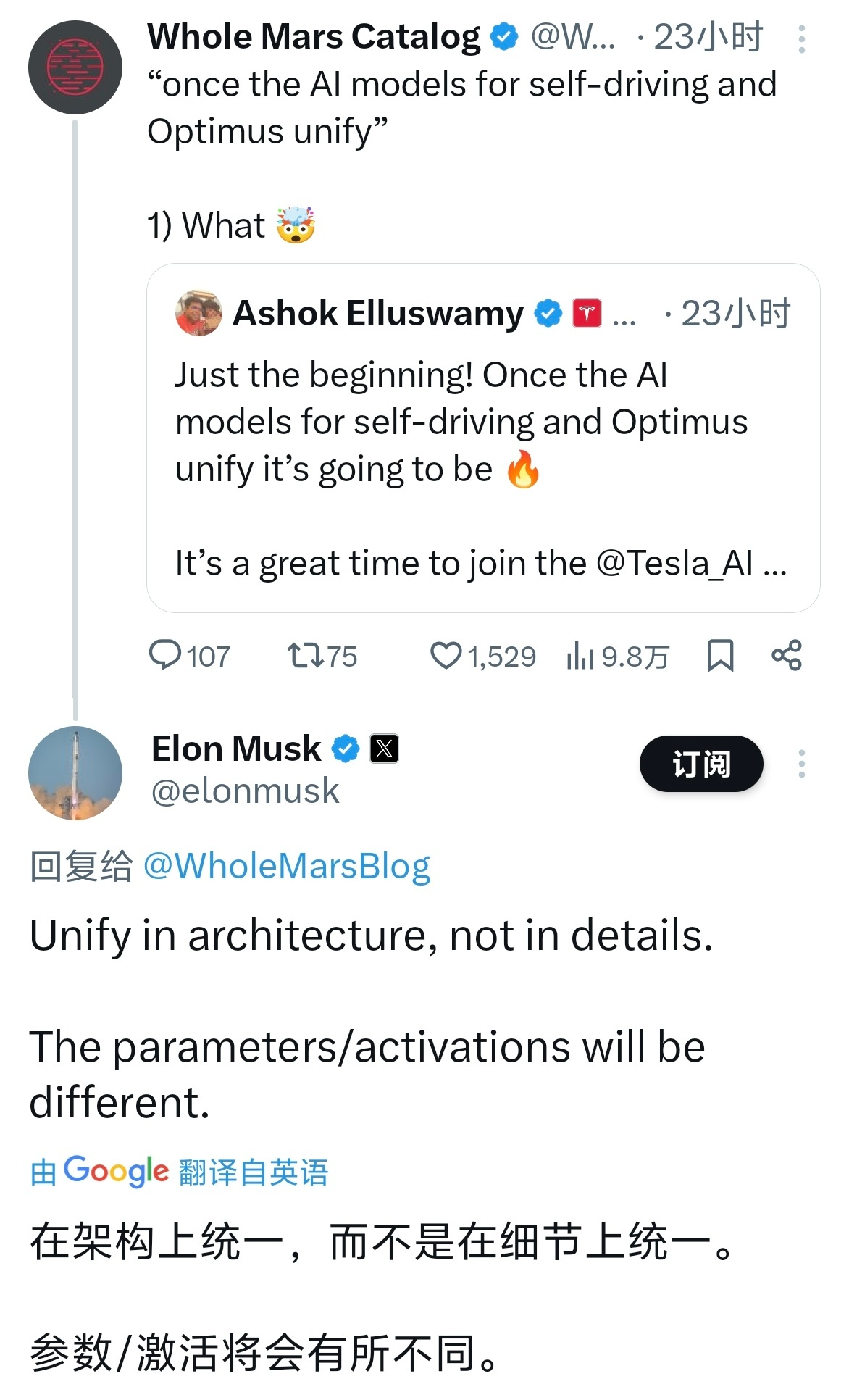

小米做了一个研究,尝试全面打通机器人和自动驾驶界限,统一训练模型应用两大场景的工作小米具身基础模型 MiMo-Embodied,牵头人是小米辅助驾驶的 VLA 负责人陈龙。这个研究验证了一个核心假设:物理世界的智能是通用的。长期以来,学术界和工业界都倾向于将「室内机器人操作」和「室外汽车自动驾驶」作为两个独立的垂直领域。机器人是室内抓取,空间感知、动作交互,比如拿起一双筷子。而汽车是户外动态环境,观察交通,预测行人轨迹,很少能有一个模型兼顾这两种差异极大的应用场景。而 MiMo-Embodied 尝试打破这种割裂,构建一个跨域的基础模型。MiMo-Embodied 的模型架构包括一个视觉 Transformer、一个 MLP 把视觉特征和大语言模型映射对齐、一个大语言模型负责推理。在数据集这块也做了很精细的策略。不是简单把机器人和自动驾驶数据集混合,而是分阶段、系统化的去调。第一阶段是机器人数据,先让模型有了机器人模型的能力第二阶段是自动驾驶数据,让模型学会开车第三阶段是 COT 思维链的数据,让模型无论在室内还是室外,遇到复杂场景可以一步一步连贯推理。第四阶段用强化学习微调之类的技术,进一步对齐模型的操作偏好和人类的驾驶习惯,属于最后的优化了。训练的结果是,MiMo-Embodied 在机器人和自动驾驶两大领域的多个评估中拿下了最优表现。这验证了MiMo-Embodied 的模型能力是完全通用的,跨域训练没有出现性能摇摆的问题,物理 AI 的能力是泛化的。如果按照这个研究结果来一个 Ilya 式的延伸,那么逻辑上 AI 眼镜、无人机、扫地机器人、人形机器人、自动驾驶汽车,背后可能可以是同一个机器人模型,当然这是很远期的畅想。从业界看,今年 6 月特斯拉 Optimus 机器人 AI 负责人 Milan kovac 离职后,FSD 负责人 Ashok 就在尝试以统一的架构来管理机器人模型和世界模型,Elon Musk 后来的评论也证实了这一点。当然了,小米这个 MiMo-Embodied 只是一个研究,要量产落地还需要大规模的工程工作,这也是为什么小米直接开源了代码、模型和数据集,如果是服务于量产的有商业价值的,小米肯定没法这么慷慨了。