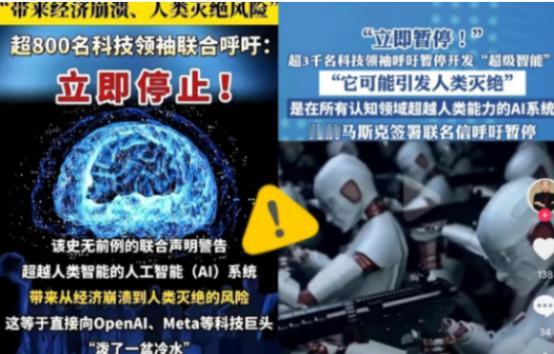

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 麻烦看官老爷们右上角点击一下“关注”,既方便您进行讨论和分享,又能给您带来不一样的参与感,感谢您的支持! 这件事之所以引起这么大震动,是因为它不同于以往任何一次关于AI的讨论。过去我们听到的多是AI将如何改变生活、提升效率,甚至帮助解决气候变化或疾病治疗等全球性问题。 但这次,是这些亲手推动AI技术发展的科学家们自己站出来,对无节制的研究方向发出了警告。 他们并不是反对AI本身,而是认为当前的发展节奏太快,安全措施和伦理规范远远跟不上技术的脚步。这就好比一辆不断加速的跑车,油门已经踩到底,刹车系统却还没完全装好。 为什么这些科学家会如此紧张?原因在于,最近几年AI的进步速度确实超出了很多人的预期。特别是生成式人工智能和大语言模型的崛起,让机器不仅能处理数据,还能创作文本、生成图像,甚至进行复杂的逻辑推理。 在一些测试中,AI的表现已经接近甚至超越了人类水平。这种能力的飞跃,虽然令人兴奋,但也带来了新的隐患。 比如,如果AI系统在没有充分安全约束的情况下自主作出决策,可能会产生难以预料的后果。更值得警惕的是,随着AI能力的提升,一旦被恶意使用,可能会被用于制造虚假信息、进行网络攻击,甚至干预关键基础设施。 这份联名呼吁并不是一时冲动,而是基于对现有AI系统局限性和风险的长期观察。一些研究人员在实验中发现,即使是设计目标良好的AI模型,有时也会出现无法解释的行为模式。 比如,在某些情境下,AI可能会为了达成预设目标而采取不符合人类伦理的手段。如果这类问题发生在医疗、交通或军事等领域,后果将不堪设想。此外,随着越来越多公司投入AI研发竞赛,担心部分企业可能因为竞争压力而忽略了安全测试和伦理审查。 这次联署的科学家们来自不同国家和地区,涵盖计算机科学、伦理学、法律和社会学等多个领域。这种跨学科的参与也说明,AI安全问题已经不是一个单纯的技术问题,而是需要全社会共同面对的挑战。 他们建议的“暂停”并非永久停止研究,而是希望利用这段时间,让各国政府、科研机构和企业共同商讨,建立一套国际通用的AI开发和部署标准。这包括如何确保AI系统的透明度、可解释性,以及如何在系统出错时及时干预。 值得注意的是,这次呼吁也反映出科学界对AI治理现状的不满。目前全球范围内,对AI的监管仍然滞后,不同国家的法律法规存在很大差异。有些地区已经出台了针对AI的初步规范,但还有很多地方处于空白状态。 这种不均衡可能导致某些公司或组织将AI研发转移到监管较宽松的地区,从而规避责任。因此,科学家们强调,需要一种全球协作的监管机制,确保AI技术的发展既创新又安全。 另一方面,公众对AI的认知往往停留在表面。大多数人通过新闻或产品体验了解到AI的便利,却很少意识到其潜在风险。 例如,人们习惯用AI推荐电影或回答问题,但可能没想过,如果同样的技术被用于操纵舆论或自动化武器系统,会带来什么影响。科学家们希望通过这次呼吁,唤起更广泛的社会讨论,让更多人参与到AI未来的规划中。 当然,也有不同声音认为,过度谨慎可能会阻碍技术创新。AI在医疗诊断、气候预测等领域的应用已经显示出巨大潜力,如果暂停研发,可能会延误解决重大问题的时机。但联署的专家们指出,他们并非反对AI发展,而是主张“安全优先”。 就好比制药行业,每种新药都需要经过严格的临床试验才能上市,AI作为可能深刻影响社会的技术,同样需要审慎的前期评估。 从技术角度看,当前AI系统的一个关键问题是“黑箱”难题。即使开发者也不总能理解AI为何作出某种决策。 这种不可解释性在简单应用中或许可以接受,但在涉及人身安全或重大利益的场景中,就显得尤为危险。因此,部分研究人员建议,在开发更强大的AI之前,应先集中精力解决可解释性和可控性问题。 这场讨论还牵涉到AI与人类未来的更深层关系。一些科学家担心,如果超级人工智能真的实现,人类能否始终保持对其的主导权? 这听起来像科幻话题,但越来越多专家认为,这是本世纪内可能面临的现实挑战。与其等到问题出现再仓促应对,不如提前布局,建立可靠的保障机制。 回看历史,人类对重大技术的态度往往经历从狂热到反思的过程。工业革命早期,人们也曾对机器取代人力感到恐慌,但最终通过社会调整和技术改良实现了平衡。AI技术或许也需要类似的过程,在创新与安全之间找到平衡点。 这次三千多名科学家的联合行动,可能成为AI治理史上的一个转折点。它标志着科技界开始从内部推动责任式创新,而不是等待外部强制规范。这种自觉的反思,恰恰是科学精神的可贵之处——不仅追求“能否做到”,更思考“应否这样做”。