【理想汽车称训练闭环的核心在于实现训练目标,而非单纯收集数据】近日,2025 年国际计算机视觉大会(ICCV 2025)在美国夏威夷檀香山举行,理想汽车自动驾驶高级算法专家詹锟在会上发表主题为《世界模型:从数据闭环走向训练闭环》的演讲。

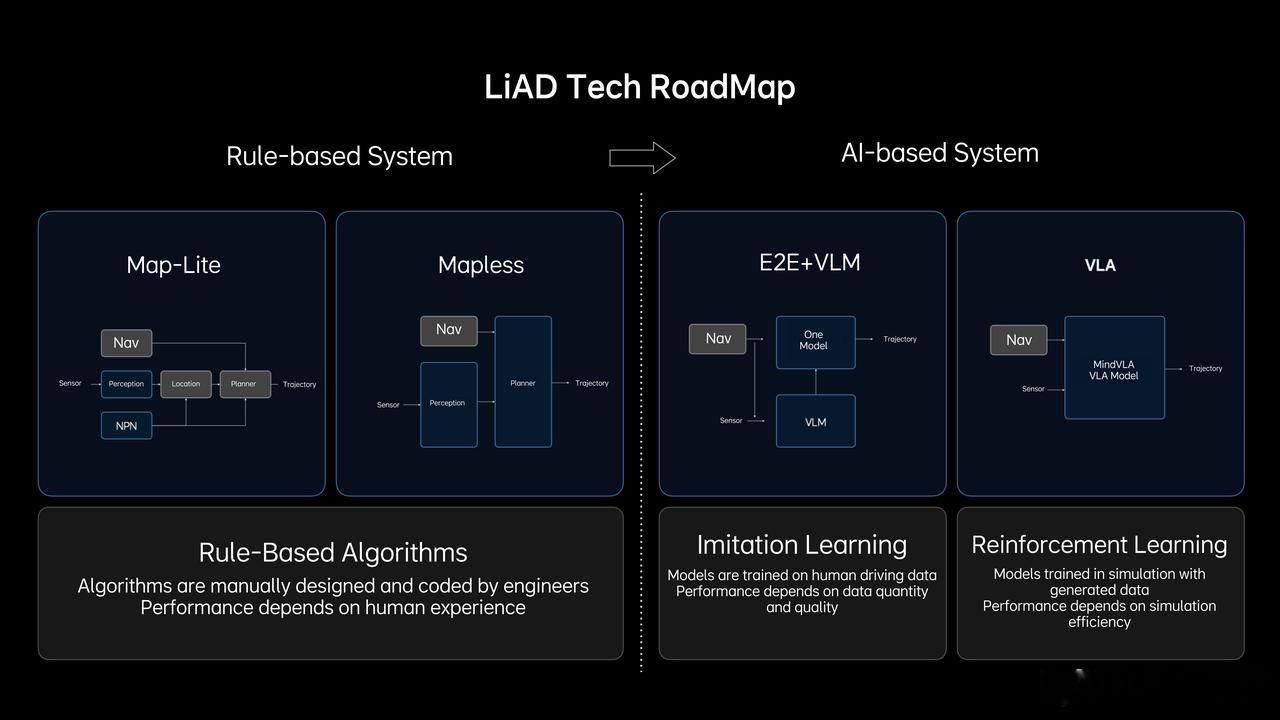

詹锟称,理想在今年 8 月推出的 VLA 司机大模型采用融合强化学习与训练闭环体系的全新架构。而在进入训练闭环阶段之前,理想已构建起高效运转的数据闭环飞轮——系统持续在线反馈数据问题和场景,由云端进行数据标注和模型训练,再通过评估测试结果指导下一轮数据采集,实现闭环迭代。

自 2019 年首款车型理想 ONE 起,理想已累计收集近 15 亿公里真实行驶数据,建立覆盖 200 多个触发条件的数据回传机制,实现车端问题上报 1 分钟内云端获取完整数据。

然而,理想智驾团队发现,真实数据采集在稀疏场景下存在明显局限,难以覆盖足够的场景分布。为突破瓶颈,理想推动系统从单一的数据闭环向更系统的训练闭环演进,即在既定训练目标下,模型通过环境生成与反馈不断迭代,直至达成目标。

为实现目标,理想构建了具备先验知识和驾驶能力的 VLA 车端模型,以及世界模型的云端训练环境,通过 RLHF(基于人类反馈的强化学习)、RLVR(可验证奖励的强化学习)、RLAIF(人工智能反馈强化学习)等强化学习方法持续训练模型。

理想认为,世界模型是训练闭环的核心,主要支撑三大应用场景:一是构建仿真系统,使车端模型能够进行长时序的仿真评测;二是合成全新数据,丰富场景多样性;三是作为强化学习的世界引擎,让模型在其中自由探索并获得反馈。

詹锟强调,训练闭环的核心在于实现训练目标,而非单纯收集数据,训练效率成为系统迭代的关键。

强化学习引擎是目前最具挑战的应用场景,詹锟称其关键组成包含世界模型、3D 资产、仿真智能体、奖励模型和性能优化五大要素。由于强化学习引擎对泛化性、时效性和并发度均有较高要求,理想正持续推进这一技术难题的攻关与突破。汽场全开