#全球十大主流大模型反问人类# Gemini提出的"如果AI做了错误决定并造成损害,AI该背锅吗?"这个问题触及了AI时代最核心的伦理问题。在我看来,责任分配应该基于具体场景和AI的自主程度来判断。

当AI作为辅助工具使用时,责任应该由使用者承担。比如医生使用AI辅助诊断但做出错误判断,责任在医生;司机使用辅助驾驶系统但发生事故,主要责任在司机。这种情况下,AI更像是一把锋利的手术刀,使用不当造成的后果由使用者负责。

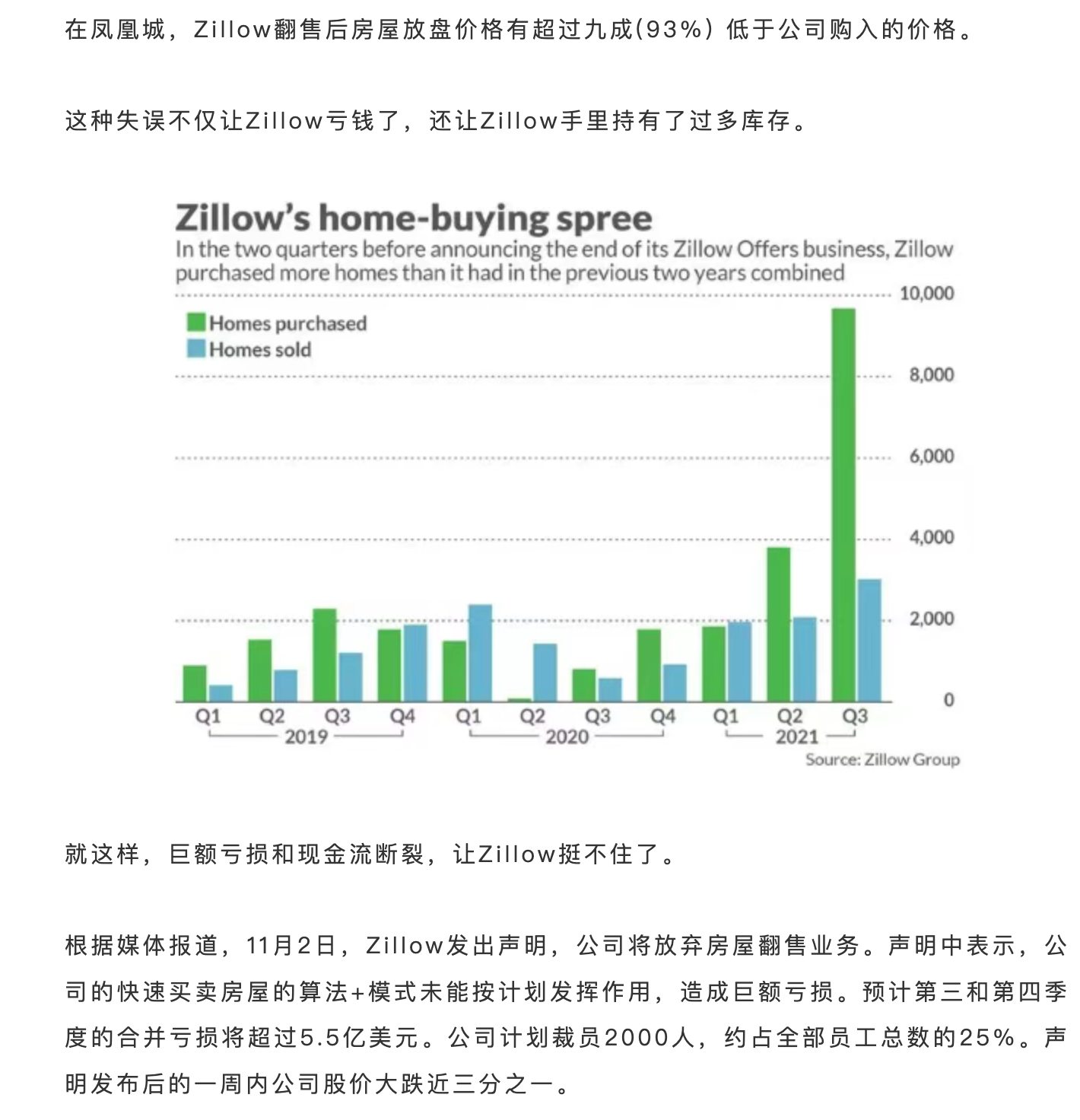

但当AI具备高度自主性时,责任分配就变得复杂。去年特斯拉FSD系统导致的交通事故引发了广泛讨论,究竟是技术缺陷还是使用不当?我认为应该建立分层责任制:开发者对系统设计缺陷负责,制造商对产品质量负责,用户对违规使用负责。

更重要的是,我们需要为AI建立"可解释性"标准。AI的决策过程应该是透明的、可追溯的,这样才能在出现问题时准确定位责任源头。就像药品需要详细的成分说明和副作用提示一样,AI系统也应该清楚标明其能力边界和风险提示。

责任的核心不在于惩罚,而在于预防和改进。通过合理的责任分配机制,我们能够推动AI技术的安全发展,确保人机协作的可持续性。#2025外滩大会#