华为别不服,特斯拉FSD智能辅助驾驶仍然是断层式领先

都说新能源的下半场卷的是智驾、智能化,但殊不知特斯拉FSD 仍然在全球范围内都是断层式的领先。

这并不是危言耸听和泼冷水,而是实实在在存在的现实。

从智能驾驶 本身的技术路线来看,特斯拉就已经赢了。

以前我们了解的智能驾驶,要分为感知、预测、规划、控制四个模块部分,然后再进一步再分为是代码指令判断还是AI大模型判断,而现如今的特斯拉采用的则是“一段式智驾”。

简单来说就是,感知元件所采集到的信息,全部都流向神经网络,直接处理最原始的传感器数据,输出控制指令,这听起来似乎仍然是接收、判断和下达指令的三段式,但实际的大模型却能做到“看到”就已经“行动”了。

Transformer架构带来的核心优势就在于,以往的每个模块之间有自己独立的算法和模型,模块之间通过接口来传递信息,这种方式会存在明显的信息缺失和误差积累。

我们举一个简单的例子。在食堂打饭,你要在这个窗口说你吃什么,然后A大妈给B大妈说你点了什么,B大妈盛饭再给C大妈,C大妈再大喊谁点的尖椒茄子盖饭,这是众多车企采用的架构。

而真实情况却是,只有一个A大妈,你说了啥,她就给你啥,这就是特斯拉的辅助驾驶。所有的决策都由一个架构完成,这样不仅省了成本(人工成本+电量消耗),大妈也不会给错饭和给错人。

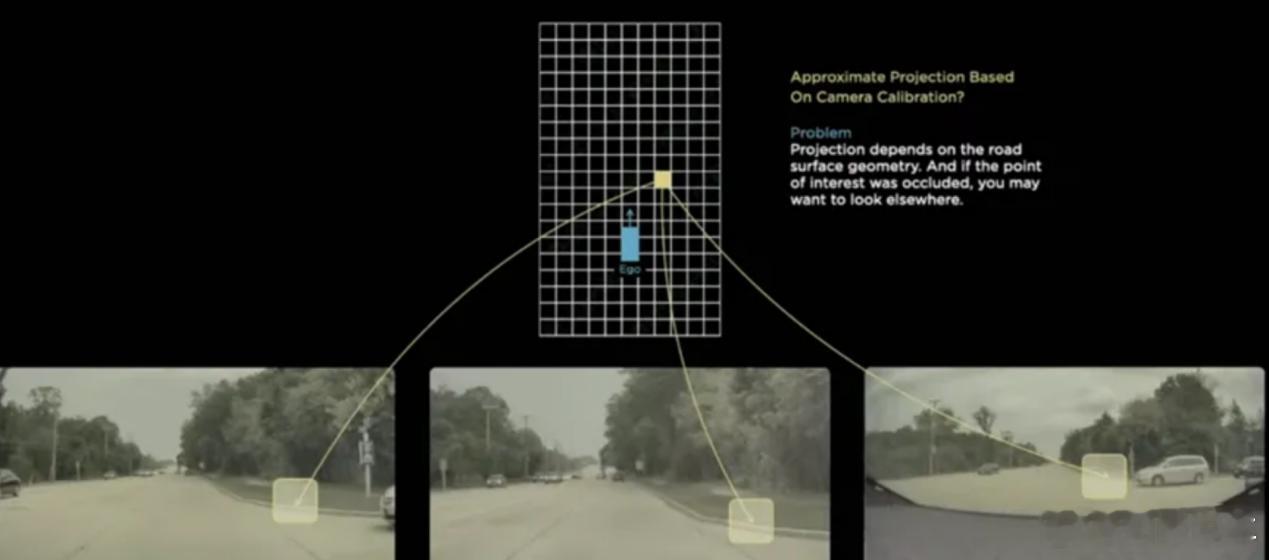

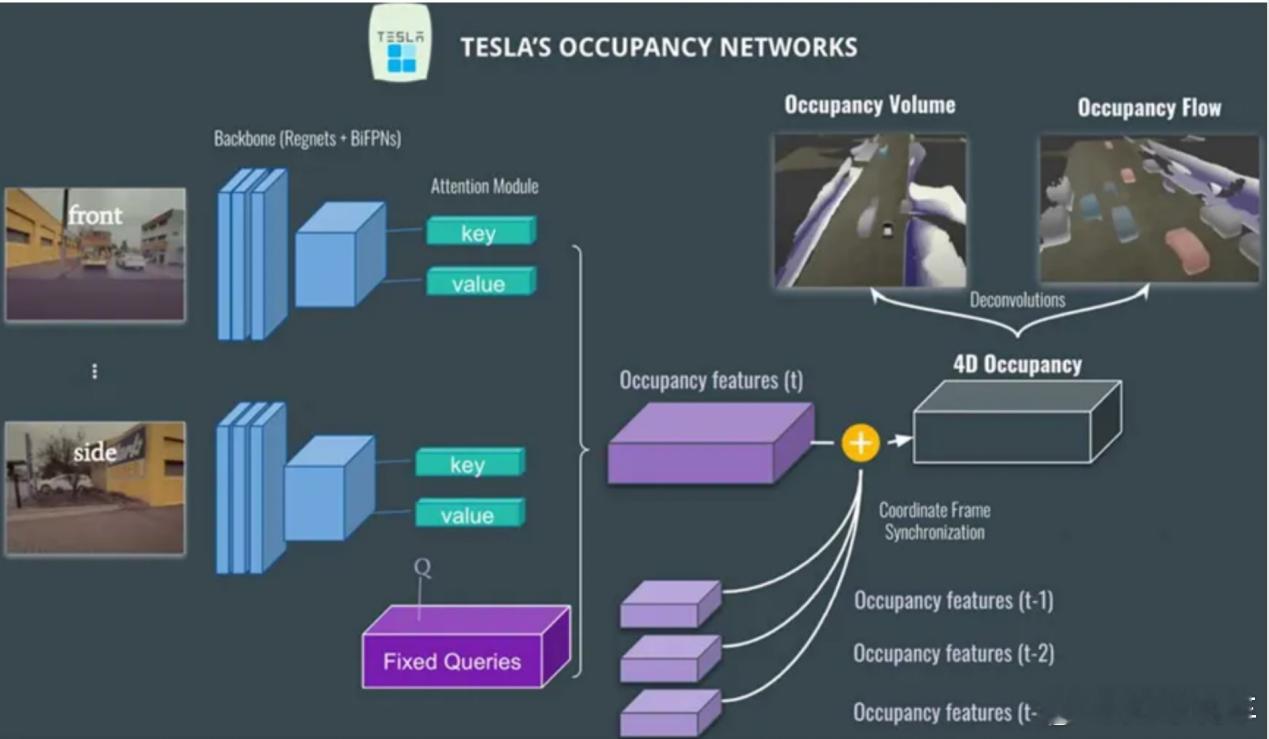

而除了Transformer架构之外,特斯拉的感知层面敢只用摄像头做纯视觉,则更是技术自信的表现。

不依赖高精地图、不依赖激光雷达,只靠视觉摄像头,其背后要实现的技术难点则更多。这必须要求智驾模型非常强大,才能从一个2D的图像中,精准构建理解3D环境。Occupancy Network的模型虽然是端到端的,但其内部会不断学习,并利用类似一种“占用网络”的表示来理解3D空间的构造和动态物体。

这也就是很多中国车企,即便也用了端到端模型,但仍然始终需要激光雷达的原因,其难点就在于,自己的端到端模型还是要依赖3D采集,而不能从2D通过理解变为3D。

我们不说具体的使用感受差距,毕竟特斯拉FSD采集的很多都是北美驾驶数据,进入中国肯定要水土不服一段时间。

但特斯拉 带给用户最大的智驾感受,其实会在很多潜移默化的方面。

首先是更拟真的智能驾驶感受。超车变道、刹车减速等等方面都会更像一个真正的人类驾驶行为。在北美的V12实际反馈中,当系统在处理复杂的城市道路、无保护左转、环岛、施工区、应对行人和非机动车等场景时,特斯拉的实际表现有更高的流畅性以及更接近人类驾驶员的决策逻辑和处理能力。

这一点很多中国车企的智能驾驶方案也都在增强,但在能耗的管理方面,特斯拉仍然首屈一指。

前面我们已经提到了Transformer架构对于电耗的减少有着至关重要的作用,而且特斯拉还不用激光雷达,这相比于中国车企的一堆感知元件,也会带来在电耗上的优势。

去年冬天我们拿到一组来自北欧的续航数据,在特斯拉与一众国产新能源的比拼中,虽然大家最后做到的续航里程相差不大,但特斯拉的电池却在其中是最小的。

三电系统的水平确实有很大差异,但对于一台智能电车来说,特斯拉在智驾上节省的电量,就似乎已经超过了绞尽脑汁降低的那一点点风阻系数带来的差异了。

而最致命的则是,整个关于智能驾驶战争,似乎在特斯拉推出Robotaxi的那一刻就已经结束了。中国新能源的端到端近两年才逐渐落地,但特斯拉的完全体Robotaxi却已经开始量产。

这场仗越到后来越没法打,因为端到端 和AI最后比的,并不会再是谁的芯片用的有多好、谁的摄像头雷达更清晰,而是数亿的驾驶数据。

众多友商所追赶的,不过是特斯拉早在三年前亮起的尾灯罢了。

评论列表