虽然xai 没有公布Grok-3 训练的全部细节。

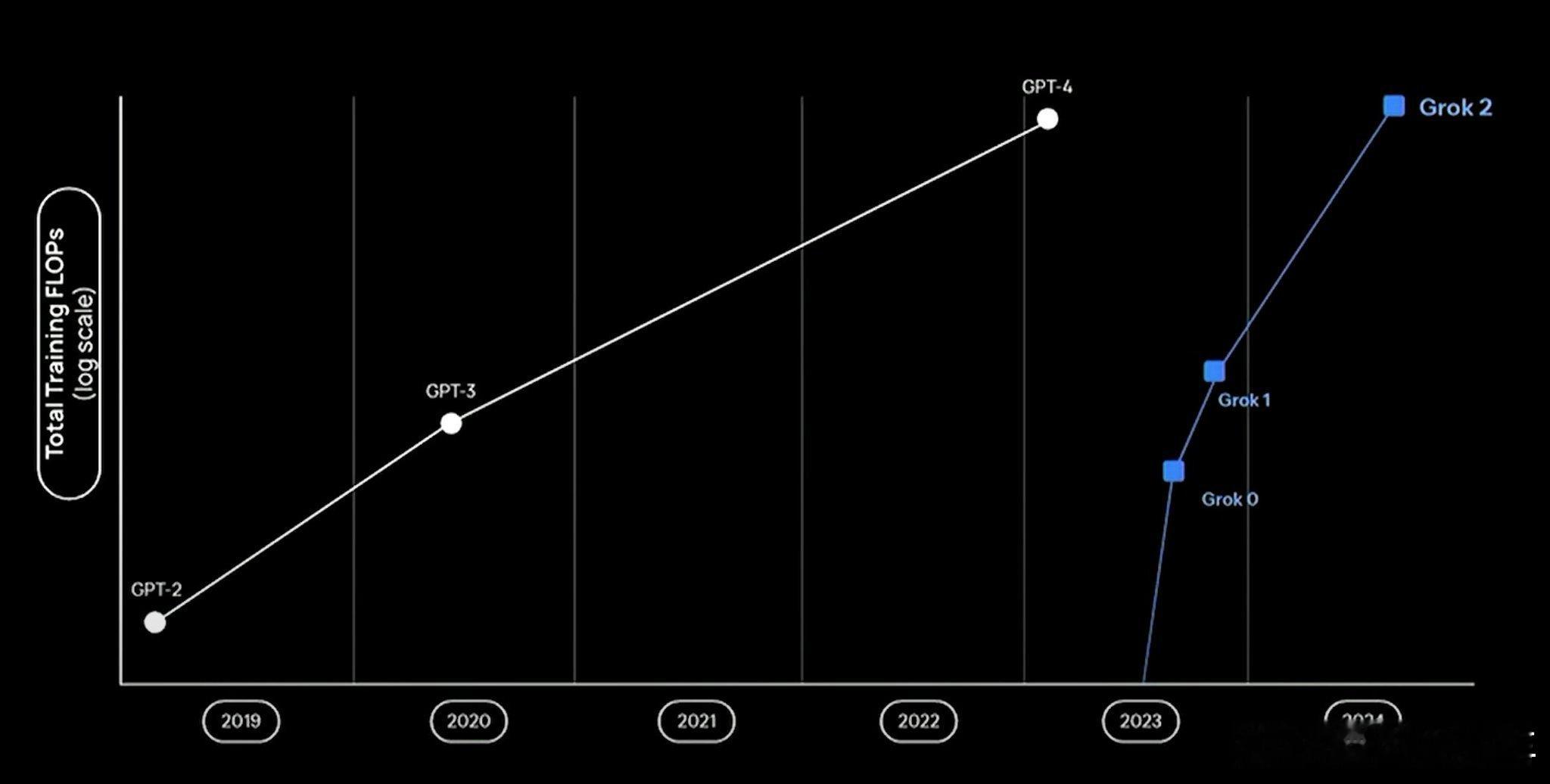

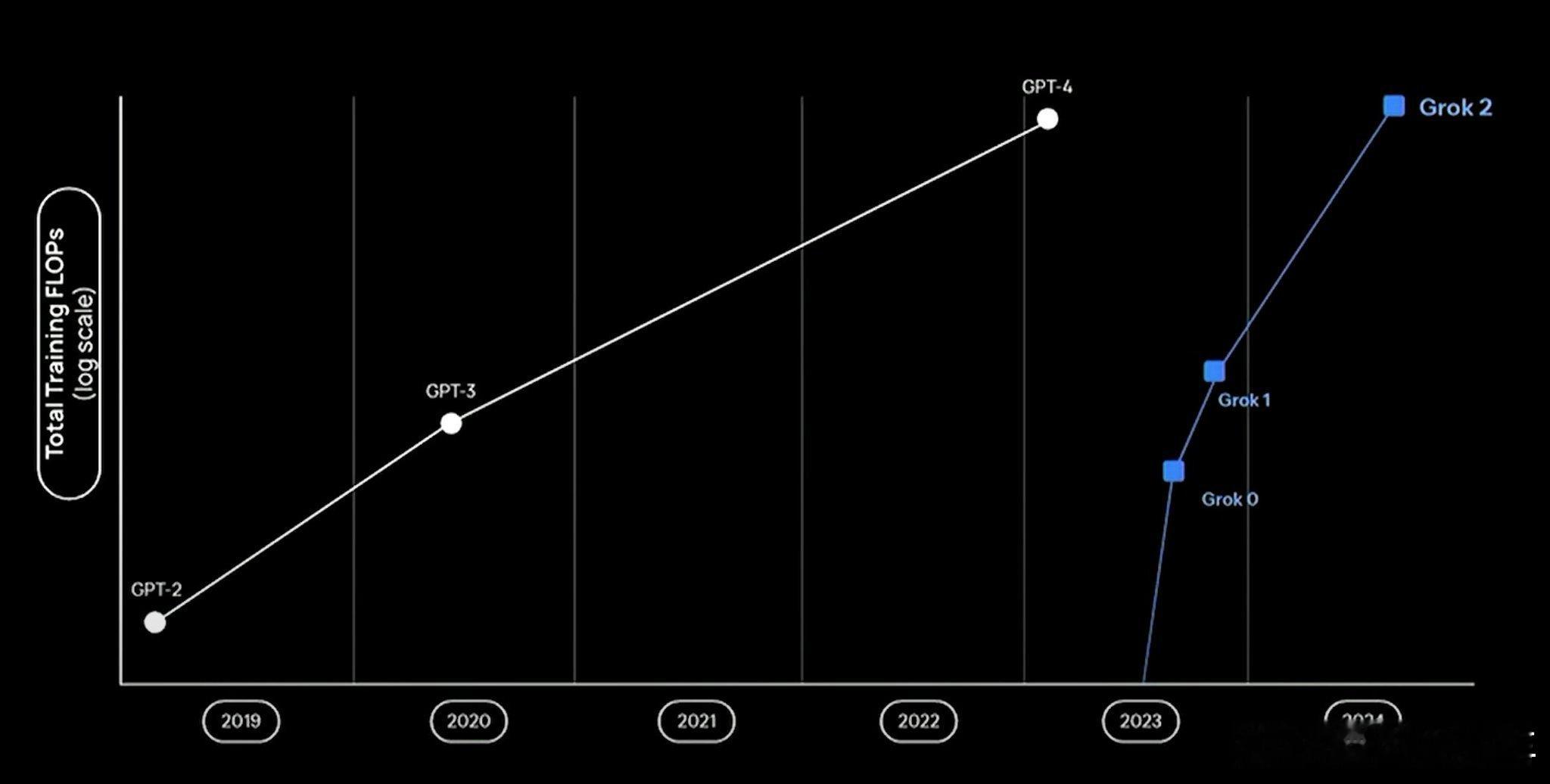

但是,已知的集群大小(100k-200k GPU)、大致的训练持续时间以及 xAI 对 Grok-3 与 Grok-2 和 GPT-4 的计算使用情况的比较都表明总计算规模约为 4e26 到 5e26 FLOP。

Grok-3 的训练耗时约为 3-4 个月。

xAI 的数据中心最初有 10 万台 H100,在 90 天内扩展到 20 万台 GPU。

这张图的曲线很能说明一切,开始时间个最后结果,真大力飞砖。

虽然xai 没有公布Grok-3 训练的全部细节。

但是,已知的集群大小(100k-200k GPU)、大致的训练持续时间以及 xAI 对 Grok-3 与 Grok-2 和 GPT-4 的计算使用情况的比较都表明总计算规模约为 4e26 到 5e26 FLOP。

Grok-3 的训练耗时约为 3-4 个月。

xAI 的数据中心最初有 10 万台 H100,在 90 天内扩展到 20 万台 GPU。

这张图的曲线很能说明一切,开始时间个最后结果,真大力飞砖。

作者最新文章

热门分类

汽车TOP

汽车最新文章