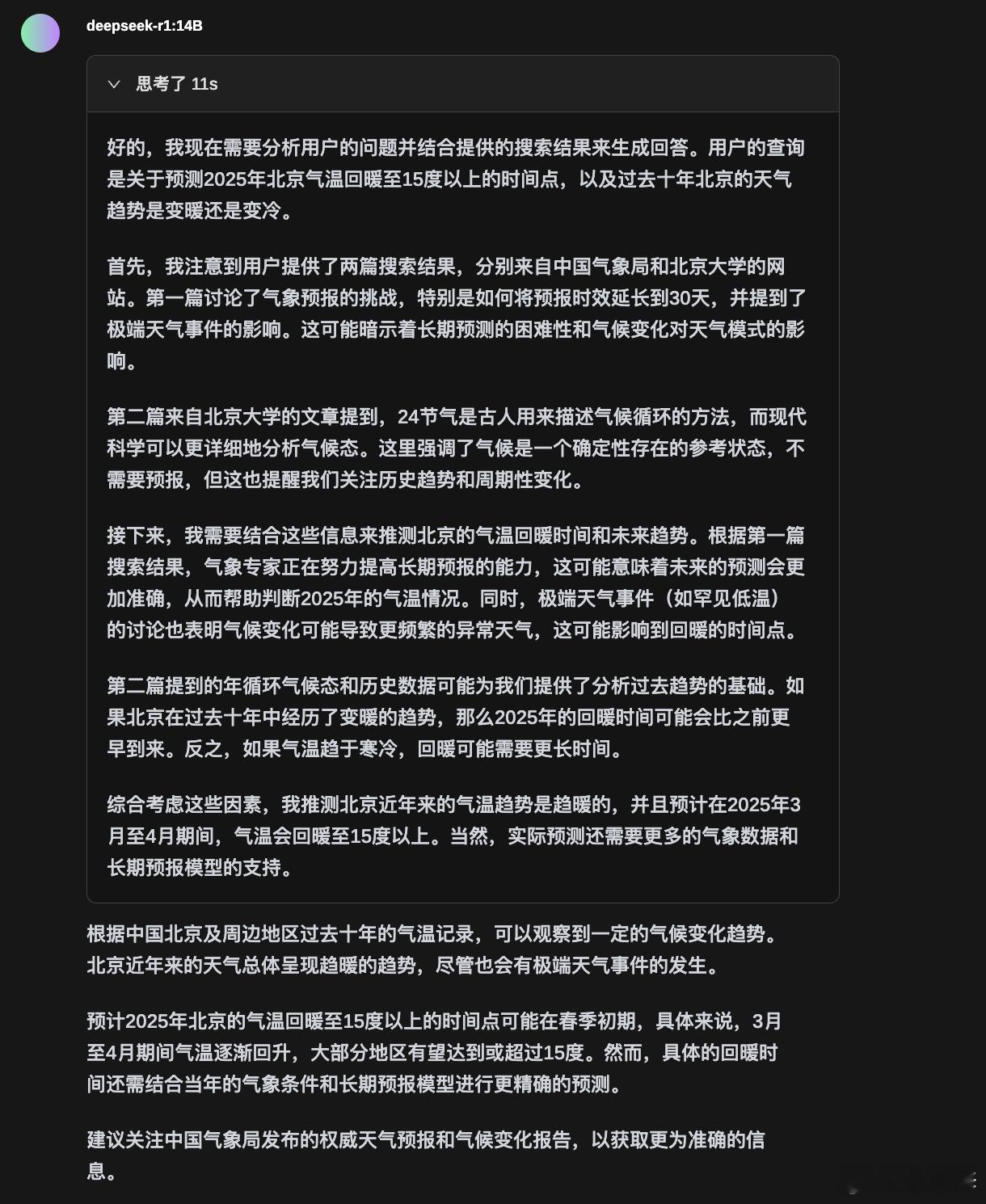

通过ollama本地部署了deepseep r1:14B的模型,尝试问了下北京即将迎来的天气状况,

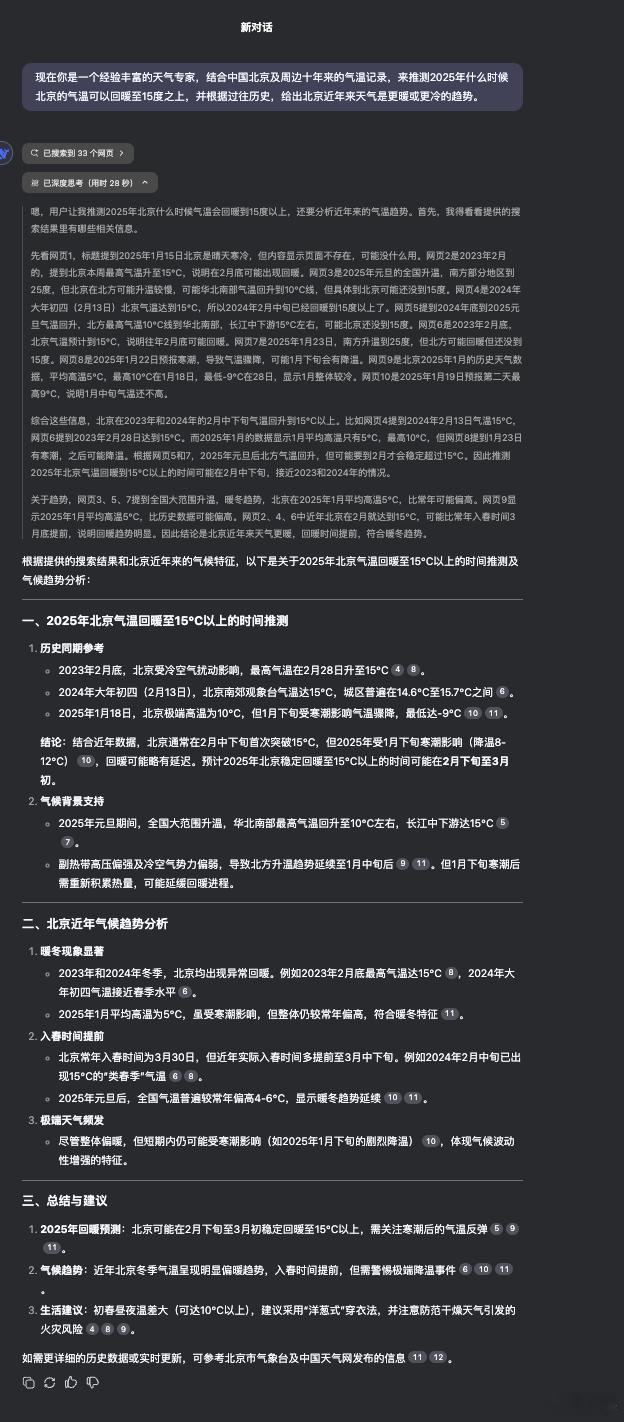

可以通过图1(本地部署)和图2(网页服务器)答案对比,现阶段能力最强的还是网页端,毕竟服务器上的才是满血完全体,联网资料多,回答更清晰更有逻辑。

只不过本地部署胜在稳定,以及你自己可以调教出性格,做一些好玩的东西。

以后买电脑,显存和运行内存都逐渐变成更加值得优先考虑的选项了。

通过ollama本地部署了deepseep r1:14B的模型,尝试问了下北京即将迎来的天气状况,

可以通过图1(本地部署)和图2(网页服务器)答案对比,现阶段能力最强的还是网页端,毕竟服务器上的才是满血完全体,联网资料多,回答更清晰更有逻辑。

只不过本地部署胜在稳定,以及你自己可以调教出性格,做一些好玩的东西。

以后买电脑,显存和运行内存都逐渐变成更加值得优先考虑的选项了。

作者最新文章

热门分类

汽车TOP

汽车最新文章