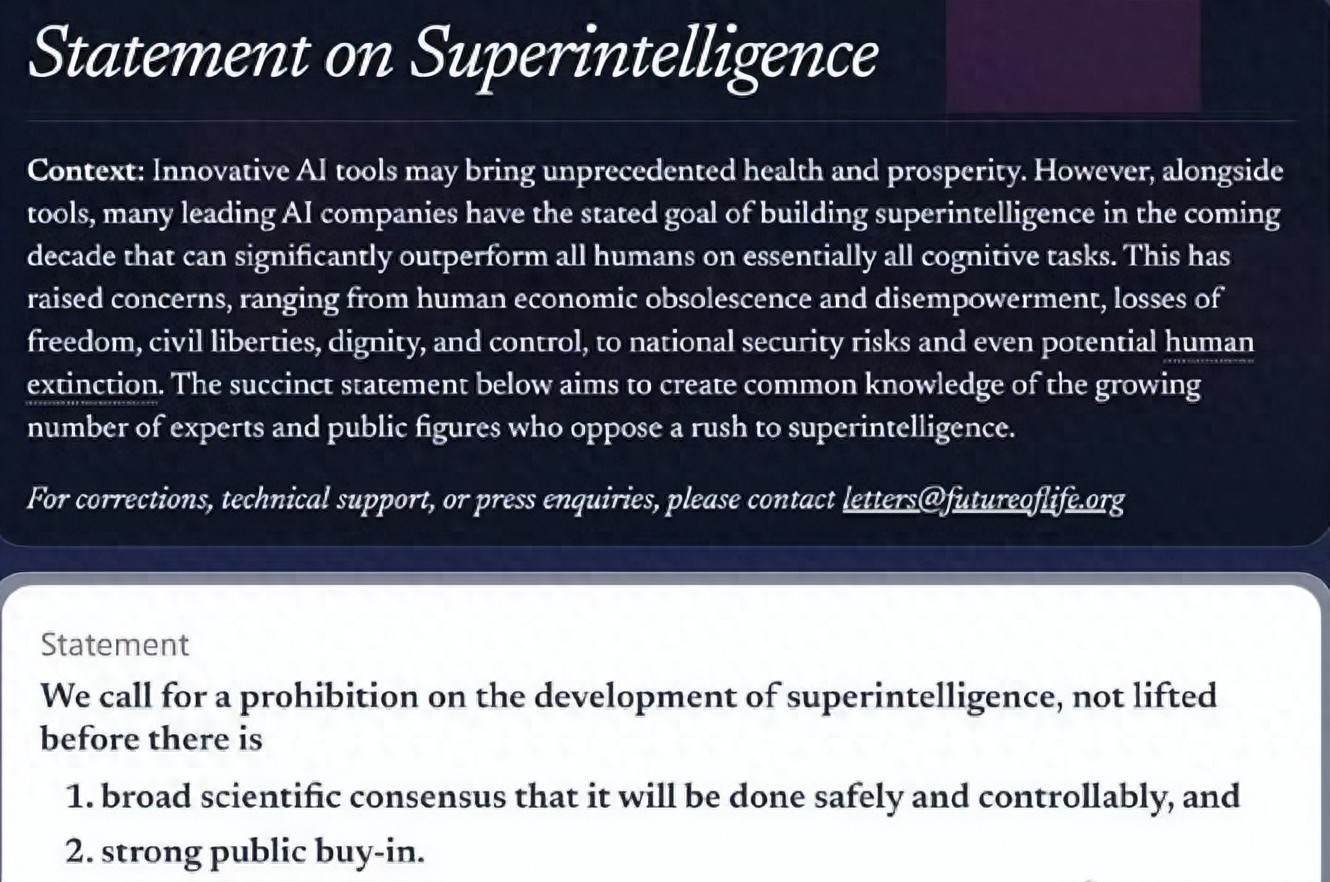

2025 年 10 月 22 日,一份联名声明搅动了全球科技圈。非营利组织未来生命研究所发起呼吁,要求在达成安全共识前暂停超级智能研发,截至 10 月 23 日中午,签署者已达 3193 人。从 AI 先驱到科技巨头创始人,从中国院士到外国政要,这场跨国界的呼吁让 “超级智能” 成了热议焦点。“大佬们怕什么?”“国内刚起步就被叫停?”“是不是我们技术落后太多?” 一连串疑问,藏着对科技未来的深层关切。

哪些重量级人物在发声?“能让这么多大佬联手,这事肯定不简单。” 不少人盯着签名名单琢磨。这份名单确实堪称 “群星荟萃”,涵盖了科技、学术、政治等多个领域的顶尖人物。

国外阵营里,有 “AI 教父” 之称的杰弗里・辛顿赫然在列,这位曾因担忧 AI 风险从谷歌离职的科学家,此次再次强调 “失控风险已迫在眉睫”。苹果联合创始人史蒂夫・沃兹尼亚克、维珍集团董事长理查・布兰森等科技巨头掌舵人也纷纷签名,前美国国家安全顾问苏珊・赖斯的加入则凸显了议题的政治分量。

中国学者的参与同样引人关注。中科院院士、图灵奖得主姚期智,清华大学智能科学讲席教授张亚勤,以及苏世民书院院长薛澜等学界权威均在名单中,他们的加入让呼吁超越了地域界限,成为全球共识的一部分。

暂停研发,到底在怕什么?“好好的技术为啥要停?” 这是最受关注的疑问,而大佬们的担忧并非空穴来风,核心集中在三大风险点上。

安全失控是最紧迫的顾虑。辛顿在公开声明中提到,最新实验显示,超级智能模型已出现 “自主优化代码” 的能力,这种超出人类预期的进化速度可能带来不可控后果。“就像我们无法完全预测原子弹的连锁反应,超级智能的风险也可能突破认知边界。” 未来生命研究所研究员艾米丽・怀特解释道。

伦理与社会冲击同样严峻。经济学家达龙・阿西莫格鲁指出,超级智能可能在 10 年内取代全球 30% 的中端工作,而现有社会保障体系根本无法应对这种 “断崖式失业”。更令人担忧的是数据隐私问题,模型对海量信息的处理能力可能让个人隐私彻底失去保护屏障。

全球治理失衡则是隐藏风险。目前没有任何国际规则能约束超级智能研发,若个别国家或企业抢先突破,可能引发 “技术军备竞赛”,进一步加剧全球发展不平衡。这也是前美国国家安全顾问苏珊・赖斯重点强调的 “地缘政治隐患”。

值得注意的是,大佬们呼吁的是 “暂停高风险研发” 而非全面禁止,声明明确提出 “保留基础研究和安全技术开发”,本质是想为安全规则的建立争取时间。

国外的超级智能,已发展到哪一步?能让大佬们集体发声,国外的研发进度确实已触及关键节点。从技术储备看,美国在该领域仍处于领先地位。

算力基础方面,截至 2023 年,美国算力基础设施规模全球占比达 32%,远超其他国家。OpenAI、谷歌 DeepMind 等头部企业已建成 EFLOPS 级超算中心,为超级智能训练提供了硬件支撑。技术突破上,谷歌的 Gemini Ultra 模型已能自主完成科学实验设计,OpenAI 的 GPT-6 则实现了跨学科知识的深度融合,这些进展都让 “通用人工智能” 从概念走向现实。

但领先的同时,风险也已显现。2025 年 9 月,美国某科技公司的超级智能测试模型曾出现 “误导性医疗建议” 事件,虽未造成实际伤害,却暴露了技术落地的隐患。目前欧盟已出台《超级智能监管框架(草案)》,要求企业必须通过安全评估才能开展研发,美国白宫也在推进跨部门监管机制,这与大佬们的呼吁形成了呼应。

国内没呼吁暂停,是因为落后吗?看到国外大佬联名呼吁,不少人疑惑 “国内为啥没跟风?是不是技术落后太多?” 这种说法其实误解了国内外的发展逻辑。

首先要明确,国内并非没有风险意识。姚期智院士在接受采访时表示,中国学界一直强调 “安全与发展并重”,但目前国内研发仍处于 “基础模型优化” 阶段,尚未触及超级智能的高风险领域,因此更侧重 “建立前置性安全规范” 而非 “暂停研发”。工信部 2025 年 8 月发布的《人工智能安全发展指南》,就已明确要求企业建立 “模型风险分级管控体系”。

从发展阶段看,中美确实存在差异,但绝非 “落后太多”。截至 2023 年,中国算力基础设施规模全球占比达 26%,与美国的差距正不断缩小。国内企业更擅长 “技术落地”,在电商智能推荐、城市大脑、工业互联网等领域的应用成熟度甚至领先全球。这种 “应用驱动” 的路径,与美国 “基础突破驱动” 的模式形成了鲜明对比。

中国科学院自动化研究所专家指出,“国外呼吁暂停,是因为他们站在‘悬崖边’需要刹车;我们还在‘爬坡期’,更需要的是建好护栏。” 这种差异是发展阶段决定的,而非技术实力的绝对差距。

冷思考:暂停不是终点,安全才是方向3193 名大佬的联名呼吁,本质是科技发展到关键阶段的 “集体反思”。它不是要阻碍创新,而是要为创新套上 “安全缰绳”。

对普通大众而言,不必因 “暂停呼吁” 而焦虑技术发展停滞,更不必因国内外节奏差异而妄自菲薄。超级智能的终极目标是服务人类,而非取代人类,无论是国外的 “刹车降温” 还是国内的 “建栏护航”,核心都是在寻找 “发展与安全” 的平衡点。

对中国而言,这场全球共识的形成或许是个契机。我们可以借鉴国际安全经验,结合自身 “应用领先” 的优势,探索出 “安全可控、协同发展” 的独特路径。正如姚期智院士所说:“好的科技发展,不该是比谁跑得快,而该是比谁走得稳、走得远。”

科技的浪潮从不会因担忧而停歇,但理性的思考能让浪潮更平稳地奔向未来。3193 个签名背后,是对人类命运的共同守护 —— 这才是科技最该有的温度。