近年来,以AI生成内容(AIGC)为代表的技术浪潮以前所未有的速度席卷全球,极大地丰富了信息传播和内容创作的生态。

然而,技术如双刃剑,在带来效率和创新的同时,其被滥用的风险也日益凸显。

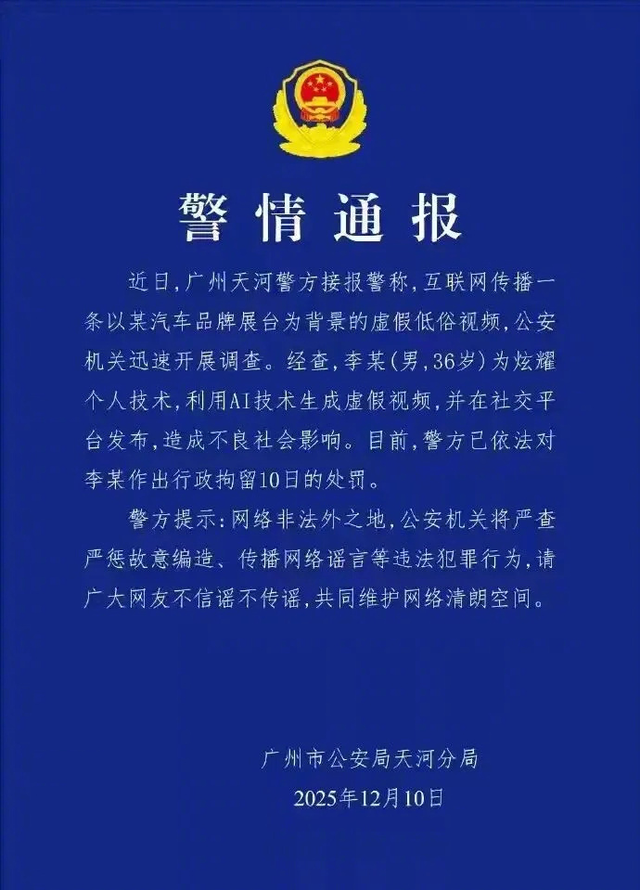

“小鹏汽车展台”事件就是一个鲜明的例证:通过AI“无中生有”地制造虚假、低俗的视频,不仅损害了企业的品牌声誉,更暴露了在深度伪造(Deepfake)技术日益成熟的今天,虚假信息传播所带来的社会信任危机和法律伦理挑战。

面对AIGC技术越来越先进的趋势,我们必须正视核心问题——如何防止AI生成图片和视频技术被滥用,以及谁应该承担主体责任?

资深互联网专家张栋伟表示,解决这一难题,需要从技术、法律、平台和用户等多个维度构建多层次、全链条的防御与责任体系。

一、技术:对抗虚假的“数字盾牌”防止AIGC滥用的第一道防线,永远是技术对抗。道高一尺,魔高一丈,我们需要开发出能够识别和溯源AI生成内容的“数字盾牌”。

1. 强制性标识和数字水印国际共识正在形成,即对AI生成内容实施强制性标识(Mandatory Labeling)。

正如中国《生成式人工智能服务管理暂行办法》和欧盟《人工智能法案》所强调的透明度义务,所有向公众提供的生成式AI服务都应在生成内容上进行清晰、易识别的标记,告知用户该内容为AI生成或深度伪造。

我国已率先建立起AIGC专项治理框架,《人工智能生成合成内容标识办法》及配套强制性国家标准《网络安全技术 人工智能生成合成内容标识方法》的发布,进一步明确要求服务提供者在生成内容中添加不影响使用的隐式标识,在易混淆场景添加显式标识,传播平台需主动核验标识信息。

更进一步,应推广数字水印(Digital Watermarking)和加密溯源技术。

数字水印可嵌入到AI生成内容的底层数据中,不可见但难以篡改。它能记录内容的生成时间、所使用的模型、甚至是最初的生成者信息。一旦内容被用于不法目的,监管者和受害者可以通过这些水印进行准确溯源,为法律追责提供关键证据。

例如,美国加州2024年通过的《人工智能透明度法案》,明确要求提供者配备检测工具与显隐式标识功能,形成技术治理的合力。

2. “反深度伪造”检测技术需要持续投入研发“反深度伪造”(Anti-Deepfake)技术。

这类技术旨在通过检测图像或视频中细微的、非人类模式的数字伪影、帧与帧之间的不一致性、或AI模型特有的指纹,来自动判断内容的真实性。当前AIGC技术迭代速度极快,平均两个月就会出现新的里程碑模型,这使得检测技术与生成技术始终处于动态博弈状态。

对此,政府和科研机构必须加大对这一领域的支持力度,构建“以大模型对抗大模型”的基座化鉴伪底座,确保检测能力不落后于生成能力。

一方面,要通过“生成-标识-检测”的数据生态闭环积累训练样本,提升鉴伪模型的泛化能力,应对各类新型伪造方法;另一方面,需针对性研发对抗技术,防范造假者通过内容压缩、隐蔽投毒等方式规避检测的行为。

同时,应推动鉴伪工具全民化普及,开发易用的手机端APP、网页插件等,让普通用户能便捷辨别AI生成内容,筑牢全民监督的技术基础。

这一点,中国的网络安全领导企业“国投智能”(美亚柏科)走在了世界前列,已经推出了“美亚鉴真平台”小程序,虽然还在初期阶段,但已经是在引领时代。

感兴趣的同学,可以打开微信小程序试试。

二、法律与监管:构建“技术向善”的边界技术对抗是基础,但要从根本上遏制滥用,必须依靠法律法规的约束与指引,为AIGC划定清晰的“技术向善”边界。

1. 明确的负面清单与内容审核义务各国监管应设立明确的AIGC负面清单,禁止生成和传播危害国家安全、宣扬恐怖主义、煽动歧视、以及包括色情、低俗在内的不良信息。

更重要的是,应对生成式AI服务提供者施加前置的内容审核和过滤义务。

在模型的预训练、优化训练阶段,必须采取有效措施,筛除含有歧视性、违法或不良信息的语料;在用户端,模型应内置针对敏感内容的“安全过滤器”,对可能生成违法信息的提示词(Prompt)进行拦截或拒绝。

2. 知识产权与肖像权保护AIGC滥用往往伴随着对个人肖像权、名誉权和知识产权的侵害。法律必须清晰界定:未经授权利用他人肖像或作品生成的内容,即使是AI创作,其法律责任依然由实际使用者和可能的技术提供者承担。

我国《民法典》虽已明确网络侵权责任,但在AI场景下,需要进一步细化,尤其是在侵权举证困难的情况下,探索由平台披露相关证据的机制。在“深度伪造”侵权案件中,应引入更严厉的惩罚机制,以震慑不法行为。

三、主体责任:多方共治,层层递进在AIGC滥用事件中,主体责任的划分是复杂且关键的问题。

鉴于AIGC的链条性特点,责任不应只由单一主体承担,而应是“多方共治,层层递进”的体系,涵盖服务提供者、传播平台、内容生成者三个核心环节。

1. 服务提供者(模型开发者)的主体责任AIGC服务提供者(如大模型公司)是技术的“源头活水”,其应承担信息内容管理的主体责任,这是第一层、也是最关键的责任。

其一,开发者在设计和训练模型时,必须将合规和伦理要求嵌入其中,遵守训练数据合法来源、不侵犯知识产权等规定。

其二,开发者有义务建立健全风险评估、安全技术措施和应急处置制度,包括对模型进行“红队测试”,主动发现和修复可能被用于生成违法内容的漏洞;提供便捷的投诉举报入口;对生成内容进行必要的监测和过滤。

其三,当监管部门介入调查时,提供者应依法配合,对训练数据来源、算法机制等进行说明,提供技术和数据支持。

内容传播平台(如社交媒体、视频网站)是虚假信息扩散的“放大器”,其应承担“通知-删除”义务和平台管理责任,这是第二层责任。

尽管事前审核难度极大,但对于明确存在高风险的AIGC内容,平台应具备一定的事前识别能力。

依据《民法典》及相关法规,当权利人通知平台存在侵权内容时,平台必须及时采取删除、屏蔽、断开链接等必要措施。如果平台“明知或应知”侵权而未采取措施,则应承担连带责任。

同时,平台应建立健全网络信息内容生态治理机制,尤其是针对网络谣言、低俗信息等,进行实时巡查和高效处置。

当前部分平台虽已探索AI内容检测技术,但仍存在检测不精准、响应不及时等问题,未来需加大技术投入,建立“早发现、早拦截、早处置”的快速响应机制。

例如“美亚鉴真平台”只能支持抖音、快手、小红书的视频鉴真,说明还有更广大的视频平台没有与类似美亚柏科的网络安全平台合作,存在较大的安全隐患。

3. 内容生成者(用户)的直接责任内容生成者(即实际利用AIGC工具制造虚假内容的用户)是侵权行为的直接实施者,必须承担最主要的直接法律责任,这是第三层责任。

无论是侵害他人的名誉权、肖像权还是知识产权,用户都应根据《民法典》承担停止侵害、消除影响、赔礼道歉、赔偿损失等民事责任。

重庆网民何某利用AI合成灾情视频博取关注被行政处罚、山西网民编造悬空寺坍塌虚假视频遭追责等案例,均彰显了法律对AI造谣行为的零容忍。若AIGC内容构成散布谣言、扰乱公共秩序,甚至是以营利为目的的传播淫秽物品,则可能触犯《治安管理处罚法》甚至《刑法》。

值得注意的是,用户若故意规避平台规则,使用非法技术绕过内容过滤,还可能面临惩罚性赔偿,这一规定将有效遏制恶意滥用行为。

四、全球协作:应对跨国界的数字挑战AIGC技术和虚假信息传播不分国界,任何单一国家或地区都无法独立解决这一问题。国际社会应推动在AIGC治理领域的国际交流与合作,在数字水印、内容溯源、安全标准、伦理准则等方面达成国际互操作性的共识。

联合国、NIST(美国国家标准与技术研究院)等国际组织和机构正在推动内容认证和来源识别机制的建立,我国发布的《标识办法》和《标识标准》也为国际标准编制提供了重要借鉴,展现了AIGC安全治理的“中国范式”。

通过制定一套全球通用的“数字内容认证标准”,才能在信息跨境流动时,依然能够对虚假内容进行有效识别和追溯,形成全球协同治理合力。

结语:在创新与安全之间寻求平衡AI生成视频、图片所带来的“无中生有”的风险,是对社会信任、企业声誉乃至个人权利的严峻挑战。

我们必须认识到,这不是要“阻止”技术创新,而是在“促进发展”与“规范治理”之间寻求一个动态平衡。

防治AIGC滥用是一项系统工程,其核心在于:技术上,利用数字水印和反深度伪造技术,筑牢数字防御的基石;法律上,构建清晰的负面清单和侵权追责机制,划定行为的红线;责任上,确立“提供者—平台—用户”三位一体的责任体系,让每一个环节都承担起相应的合规和法律义务。

只有构建“技术可防、法律可依、责任可溯”的综合治理框架,我们才能最大程度地发挥AIGC的积极价值,将“数字迷雾”中的虚假之影驱散,确保技术真正服务于人类福祉。

作者:张栋伟(资深互联网专家、市场营销专家、大学生就业创业导师)