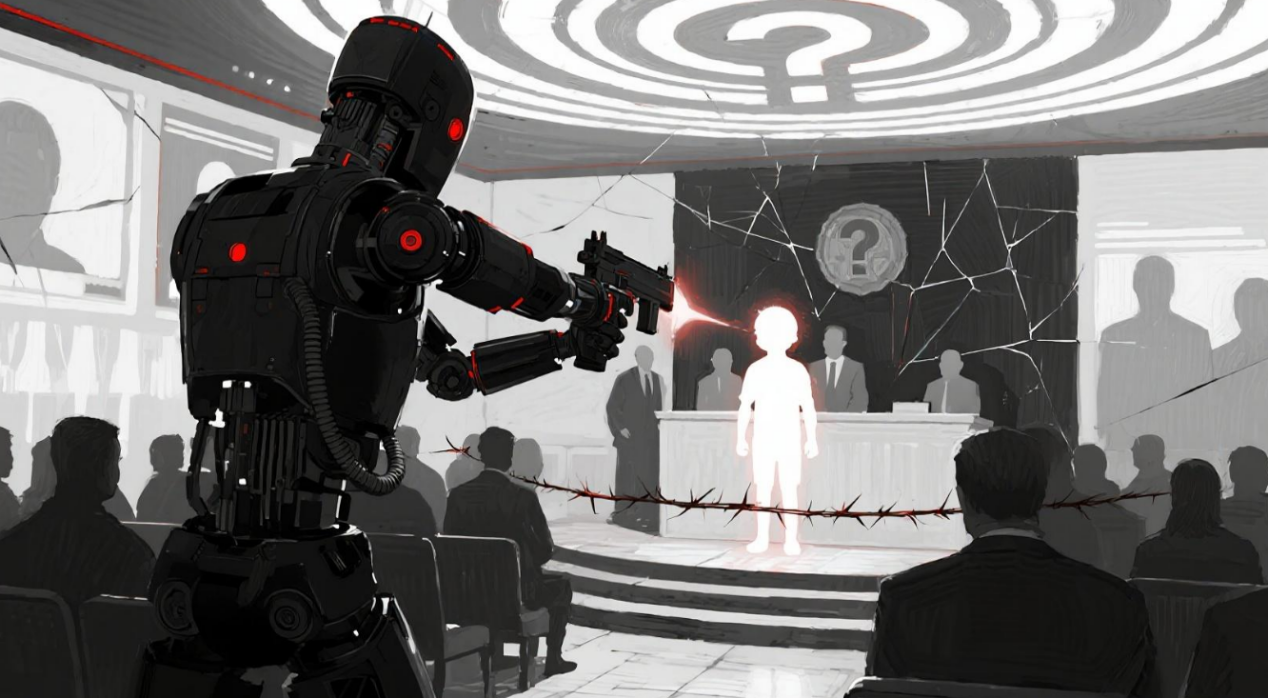

这种变革,不仅颠覆了传统的军事理论,更将那严峻的伦理困境,推至我们的面前。

当战争从“最后的选择”沦为可随时启动的“首选选项”时其对全球和平的威胁不言而喻。

更令人担忧的是,现有的国际人道法体系在面对算法驱动的自主武器时,显得力不从心。

不过算法无法完全理解,复杂战场环境中的微妙之处,例如藏匿于民用设施中的军事目标,其机械化的判断,极易导致灾难性误判。技术漏洞,系统误差以及数据偏见,皆有可能成为潜在的“火药桶”。用传统规则去束缚那以毫秒来计算的决策系统,这就如同拿螳螂的臂膀去阻挡车子前行,简直是自不量力。

面对技术带来的严峻挑战,建立一个多元化的全球治理框架与伦理创新机制已刻不容缓。

首先国际社会应共同推动,建立针对AI军事应用的跨国透明度与追责机制,比如强制地要求算法进行审计,还有攻击日志进行备案,这样就能确保每一次那致命的决策,都能够有迹可循。其次必须从技术源头,强化伦理约束,在AI系统的开发阶段,就植入“人道暂停”等理念即在面对复杂,或高风险情境时,系统必须强制暂停,并请求人类干预,为战场决策,保留一条“人性缓冲带”说到底人工智能对战争的改变,实际上是人类社会在技术与伦理之间作出的一次重要选择。

我们不能放任算法成为“战争理性”的最终仲裁者,否则人类终将陷入自我编织的“工具理性铁笼”之中。唯有联合国际社会,各方力量,共同构建一个,融合技术进步、道义自律与法律监督的AI时代军事伦理新体系,才能确保,在享受技术红利的同时,不让人类战争的最后底线,被技术无情吞噬。

权威参考来源和文献

日内瓦国际人道法与人权学院,专题分析报告

联合国秘书长办公室,关于自主武器系统风险的政策简报

《求是》杂志,国防科技前沿观察

斯德哥尔摩国际和平研究所(SIPRI),年度军备、裁军和国际安全报告

《国际红十字评论》,关于新兴军事技术的专题文章

评论列表