在人工智能大模型领域中的细分赛道,我国已走在了全球前列。

01

斯坦福AI团队被曝抄袭中国国产大模型

近日,斯坦福AI团队被曝出了抄袭事件,而且抄袭的还是中国国产的大模型成果,模型结构和代码,几乎一模一样!

斯坦福的Llama3-V项目在5月29日发布,宣称仅需500美元就能训练出一个性能超越GPT-4V、Gemini Ultra、Claude Opus等的多模态大模型。然而,一位网友发现,Lama3-V的模型结构和代码与出自清华系明星创业公司面壁智能的MiniCPM-Llama3-V 2.5几乎一模一样,只是变量名有所变化。

面对抄袭的指控,斯坦福团队选择了删库跑路,目前在GitHub和HuggingFace上的相关项目均显示404,无法访问。

面壁智能的MiniCPM-Llama3-V 2.5项目具有独特的功能,如识别清华简--一种罕见的中国古代文字。Llama3-V在未公开的实验性特征上与MiniCPM-Llama3-V 2.5表现出高度相似的行为,这些特征是根据MiniCPM-Llama3-V 2.5团队内部数据训练的。

面对抄袭的质疑,斯坦福团队最初辩称,他们的工作早于面壁智能的MiniCPM,只是使用了他们的tokenizer,然而,随后他们在Medium上的声明被删除,且最新的回应也被撤回。

02

面壁智能李大海回应

套壳现象难规避

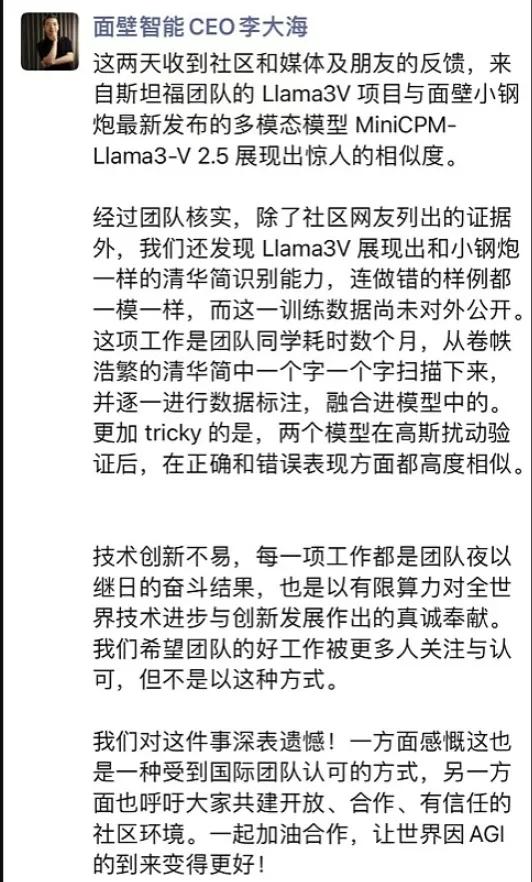

对于抄袭事件,面壁智能CEO李大海在朋友圈发文称,团队核实发现Llama3V展现出和小钢炮一样的清华简识别能力,连做错的样例都一模一样,而这一训练数据尚未对外公开。

他表示,清华简的识别能力是团队耗时数月,从卷帙浩繁的清华简中一个字一个字扫描下来并逐一进行数据标注从而融合进模型中的。在对两个模型进行高斯扰动验证后发现,它们在正确和错误表现方面都高度相似。

业内关于“套壳”的争议由来已久。有人认为,开源就该被充分利用;有人则表示,闭源才是自主研发,参考开源就是套壳。

实际上,如今所有大模型都源于2017年谷歌大脑团队发布的Transformer神经网络架构,这些包含模型架构和算法的设计决定了模型如何处理输入数据并生成输出。在此基础上,厂商在大规模的数据上对大模型进行预训练,来提高模型的泛化能力,加速后续的学习任务推进。因神经网络架构和预训练这两项工作打造难度高、投入金额大、耗费数据量多,往往被称作大模型的内核。

而大模型的“壳”一般指调优。调优是指对已经预训练过的模型进行进一步的训练。这个过程通常是有监督的,需要使用标注好的数据来指导模型的学习。调优的目标是调整模型参数,使其更好地适应特定任务的需求。

为了进一步理解大模型套壳,必须区别“外壳”与“内核”的区别。

谷歌Transformer 的原始架构包含两个核心组件——编码器(Encoder)与解码器(Decoder),编码器负责理解输入文本,解码器负责生成输出文本。在 Transformer 的原始架构上“魔改”衍生出三个变体架构——只采用编码器(Encoder-only),只采用解码器(Decoder-only),以及两者的混合体(Encoder-Decoder)。

Transformer的模型架构图,左侧为Encoder,右侧为Decoder。图片来自谷歌论文

在 2020 年之前,NLP 的模型研究基本都是围绕算法展开,基于 BERT、T5 与 GPT 架构的模型百花齐放。这一时期模型参数较小,基本都在 10 亿以内量级。其中,谷歌 BERT 的表现独领风骚,基于 BERT 架构的模型一度在阅读理解的竞赛排行榜中屠榜。

直到 2020 年,OpenAI 发布一篇论文,首次提出了 Scaling Laws(尺度定律),NLP 的研究才正式进入大模型时代——大模型基于“大算力、大参数、大数据”,模型性能就会像摩尔定律一样持续提升,直到“智能涌现”的时刻。

从大模型的进化脉络来看,今天所有的模型都是在“套壳” Transformer 以及其三个变体架构。

当然,Transformer 也有“不愿套壳”的挑战者。比如,2023 年 12 月 5 日,两位分别来自卡内基梅隆大学与普林斯顿大学的教授,发布了一款名为“Mamba”(曼巴)的新架构,在语言建模性能媲美 Transformer 的同时,还解决了一些扩展性的局限。但这个新架构的具体表现,还需要时间的检验。

模型架构选择只是第一步。百川智能创始人、CEO 王小川在一个月前的2023甲子引力年终盛典上将大模型训练比作“炒菜”,模型架构只是一个菜谱。要想得到一盘完整的菜,还需要烹饪,也就是大模型训练的过程;以及食材,也就是数据。

大模型的烹饪过程可以粗略地分为预训练(Pre Train)与微调(Fine-Tune)两大阶段。

值得关注的是,我国大模型建设浪潮中,尽管已有众多国产精品,但仅约十分之一的模型是以自主研发的预训练框架为基础。另外九成的模型则在现有开源模型基础上进行了轻微调整。至于部分闭源大型模型公司,如百度、智谱AI和月之暗面等,其技术细节尚未对外透露。

根据了解,我国内自主研发预训练框架的大规模模型企业仅有约5家。另一类大规模模型企业则是从零开始完成整体预训练流程,仅对预训练框架部分参数做了调整,我们可将其称为“仿效型”。

结果就是,现在市面上有越来越多创业公司提供大同小异的模型。这甚至衍生出如旧金山的 Martian 一般,专门为需要用 AI 服务的企业寻找“平替”方案的创业公司。

但投资人并不喜欢这种被欺骗的感觉,斯坦福AI团队这次近乎直接“搬用”的套壳行为大概率是为了融资套现,而在还原整个事情始末的过程中,面壁智能这家国内AI企业也开始浮出水面。

03

华为哈勃入股的AI公司

面壁智能是一家“清华系”人工智能大模型创业公司,核心科研成员来自清华大学NLP(自然语言处理)实验室,是国内最早一批做预训练大模型的团队之一,自研了百亿参数预训练语言大模型CPMviniCPM是其端侧模型。

2023年11月,面壁智能推出了对标GPT-3.5水平的多模态大模型CPM-Cricket。今年2月,面壁智能的开源端侧模型MiniCPM面市,作为其“大模型+Agent(智能体)”双引擎战略的关键一步。

官网显示,面壁智能成立于2022年8月,当时获近千万种子轮融资,又在2023年3月时完成数千万天使轮融资。

今年4月11日,面壁智能宣布,已完成新一轮数亿元融资,知乎作为战略股东持续跟投。本轮融资完成面壁智能将进一步推进人才引入,加固大模型发展的底层算力与数据基础,推动大模型高效训练快步落地。新一轮投资方还包括春华创投、华为哈勃、北京市人工智能产业投资基金等。

2023年,知乎战略投资面壁智能,双方展开模型共建,同年4月推出联合研发的中文大模型“知海图AI”。2024年3月,知乎推出基于“知海图A!”的全新社区原生AI功能“发现·AI搜索”。

能赢得如此多机构投资者和国内巨头的青睐,面壁智能究竟有何过人之处呢?

04

把参数做小的大模型企业

当大模型公司都在卷大参数时,面壁智能却在尽可能把参数做小。

在通往 AGI 的路上,绝大多数公司的路线是不断做大参数,但面壁智能却走了一条相反的路线--尽可能把模型参数做小。

在2024年2月1日的发布会上,面壁智能对标Mistral发布了训练数据规模近1T、参数规模仅2B的模型——聚焦于适配端侧硬件的端侧大模型MiniCPM-2B。目前,MiniCPM-2B在比GPU计算吞吐量低的CPU上可实现运行,有效降低了推理成本。同时,即便将大小压缩75%,MiniCPM的性能也能做到基本无损耗。

面壁智能披露,此次发布的国内MiniCPM 2四款模型,整体对标的是谷歌Gemma-7B、OpenAI GPT-4V、Mistral-7B、Llama2等国外开源模型。MiniCPM 2模型在同等性能参数更小、同等参数性能更强,超越Mistral-7B、谷歌Gemma、Llama2-13B、 ChatGLM3-6B等,并且170万tokens的推理成本仅需1元。

这个结果揭露了这样一个事实:很多超大参数的大模型,它们的模型效率或许并没有最大化。

「我们希望探索模型性能的天花板。」 面壁智能联合创始人刘知远教授称。他认为,从技术研判而言,2023 年 ChatGPT 和 GPT-4 的推出,表明大模型技术路线已经基本确定,接下来就是要探索其科学机理,并极致地优化效率,

他表示,在 Mistral-68 的同一模型水平下,面壁智能团队的模型参数量是最小的。这或许意味着模型的效率被提升到了最高水平。「我觉得我们做了一件挺牛的事。」 他笑着说。

05

端侧大模型成香饽饽

面壁团队认为,MiniCPM的市场竞争优势主要有三点:一、算法优化,自创“型沙盒”实验,高效训模;二、成本优化,支持在CPU上跑推理、在消费级显卡上做高效训练与微调;三、数据治理,已经形成从数据治理到多维评测的闭环,牵引型快速迭代。通俗来讲,面壁智能选择了端侧大模型这条细分赛道。

端侧大模型(Edge Al models),也就是只在设备本地(如智能手机、loT设备、嵌入式系统等)运行的大模型,过去一两年来非常流行。具体表现在,终端设备厂商,如苹果、荣耀、小米、OV等,AI公司如商汤科技,都推出了自研的纯端侧大模型。

以手机为例,过去的一年里,国内外包括苹果、三星、华为、VIVO等大部分的手机厂商都在研究一门新的学问:怎么将大模型落地到端侧?而他们之所以这么做,目的也很明确既为了在行业瓶颈掌握市场突破的重要筹码,又为了满足用户A需求,带来革新终端的使用体验。

大模型可以被称为一种暴力美学,一般认为,目前主流云端大模型的参数量在千亿级别,算法性能随着训练时长和数据集的增加而增长。这些基于云端大模型的App,需要调用海量的服务算力来进行数据传输,成本和安全性是服务商不能回避的问题。

此前有手机厂商透露,调用一次云端大模型的平均成本在1.2分到1.5分人民币,假设每个品牌都有上亿的用户量,每人每天调用10次,那么积攒下来的算力成本是惊人的;如果按次数或月租向用户进行收费,在功能同质化的情况下,用户的使用意愿也会很难保证。

而从当下的实际应用体验看,端云协同、云端大模型,才是大模型在端侧的主流形式。比如目前很流行的“手机拍照一键擦除背景人物”,仅靠端侧大模型的计算能力是无法实现的,需要端云协同来完成。再如公文写作、长文要点总结、PDF要点摘要等,端侧大模型要么无法完成,比如荣耀OPPO端侧大模型都不支持PDF文本摘要,小米MiLM的支持度和生成效果也不够好。最终,用户还是要访问GPT-4、文心一言、智谱清言、讯飞星火、KIMI等云端大模型的网页/APP,来满足一些复杂AIGC任务需求。

因此,此次斯坦福AI团队抄袭事件虽让我们看到了面壁智能的优秀,但离端侧大模型真正落地,恐怕还有很长一段路要走。