AI越来流行,AI越来越厉害,甚至可以造假骗人。最近流传一则通过AI造假霉霉(Taylor Swift)不雅照的事件,导致Taylor Swift被X暂时设为禁搜词,甚至惊动。除了霉霉这些名人外,面临AI困扰的人还有艺术家,AI可以下载他们的作品进行训练网络,然后就可以模仿他们的风格生成假冒作品,甚至可以以假乱真。难道艺术家们真的就要被AI取代了么?有什么手段可以用来防止这种事情发生呢?

对付AI还得是计算机科学科学家。芝加哥大学计算机科学研究人员创建的一款新的免费工具用来帮助艺术家防止人工智能模型未经同意的下载其作品训练网络,通过技术手段在其作品上添加干扰像素破坏AI下载数据,以达到保护作品的效果。该工具被起名为“Nightshade”,一经推出立马火爆网络,一经推出,前五天下载量已经达到25万次,甚至官网都被下崩了,临时推出了镜像下载地址。本文虫虫就和大家一起来了解一下这个能抵御并且反击AI的神奇工具究竟有什么大本事。

概述Nightshade是芝加哥大学开发的一种“数据混淆工具”,用来迷惑生成图像的人工智能程序。艺术家可以用它来尝试阻止人工智能在未经许可的情况下爬取使用他们的作品。

在Nightshade的研究论文中,由芝加哥大学的计算机科学家提到了其原理,就是通过以人眼不可见的方式改变(混淆)作品中的像素,从而误导AI模型,使其“看到”的图像和实际人们看到图像不一样。比如把“狗变成了猫,汽车变成了牛,等等,”。

工作原理Nightshade算法可以为令人困惑的图像生成AI模型创建混淆数据,为针对此类模型的对抗性攻击的讨论注入了新的活力。这种讨论还受到道德和社会考虑的影响,因为如果艺术家、内容创作者和其他人因人工智能模型未经许可使用其内容而感到受到不公正对待,此类攻击可能会为他们提供反击的方式。

首先从了解生成式人工智能如何学习的基本概念。当然,图像生成人工智能取决于其训练数据。准确地说,它依赖于这样一个事实:存在显示特定概念的图像(例如一只狗),并且这些图像与描述其内容的文本相关联(例如像戴眼镜的可爱狗 这样标签)。AI学会提取图像共享的某些视觉属性,这些属性也在其标签共享某些关键字。 也就是说,模型图像的属性来了解狗的样子。通过学习所有在标签中提到狗。

现在,如果引入显示狗的图像,但其标题总是提到猫,会发生什么? 最后,狗和猫只是图像中所见的符号。如果显示狗的图像被标记为猫,模型只会了解到符号猫指的是我们所说的狗。如果标签一致,模型如何知道标签是错误的? 如果不会说德语,而展示一百张狗的图片并告诉AI它们的标签是Katze,AI会认为Katze是德语中狗的意思。不会知道德语中狗的实际单词是Hund,Katze的意思是猫 ,因为刚刚了解了标签和图像属性之间的相关性。

刚刚描述的过程称为数据中毒,源于这样的想法:引入的数据实例会对模型的训练产生恶意影响(就像毒药的健康产生恶意影响一样)。

原生投毒攻击作为一种幼稚的方法,可以采用上述想法并用它来混淆Stable Diffusion等机器学习模型。假设想让Stable Diffusion在提示狗时创建猫的图像。为此,需要创建许多猫的图像,将它们标记为狗, 并将它们上传到互联网。然后,希望Stable Diffusion抓取这些图像以用于模型训练。

如果许多图像成为下一次训练的一部分,那确实可能会导致猫和狗之间的混淆。 然而,这种方法有一些缺点:

需要许多图像。由于还有许多其他未中毒的猫图像,因此需要大量图像才能产生影响。如果你只提供10张中毒图像,而对方有1000张未中毒的猫图像,那么它对训练几乎没有影响。 通常,可以预期对所有图像的20%或更多进行投毒才能产生效果。

请注意,不知道哪些图像将成为训练的一部分。 因此,如果想在训练中引入500 张有毒图像,可能必须创建5000张并将它们传播到整个互联网上,因为实际上只有其中一些可以被抓取用于训练。

如果上传标记为狗的猫的图像,人类可以轻松检测到。在使用图像进行训练之前,它们可能会被(人类或专门的人工智能)过滤掉。

NightshadeNightshade使用了两个关键概念:它创建对模型具有最大影响的图像(需要更少的图像),并且与人类的未中毒图像没有区别。

首先,如何让图像发挥最大效果?理论上,会希望使用那些在训练过程中导致梯度变化最大的图像。但是,要找出这些图像,必须观察训练过程,但通常情况下一般人无法做到这一点。Nightshade的作者提出了一个不同的解决方案:拍摄一张由想要毒害的模型生成的图像。也就是说,如果想将猫图像标记为狗,则可以使用简单的提示(例如猫的图像)来提示模型。它创建的图像将非常典型地代表模型所理解的猫。如果在训练中看到这个图像,它将对猫这个概念的理解产生非常大的影响(比相当不典型的猫图像要高得多)。因此,如果针对性的对该图像进行混淆投毒,就会对模型的训练产生很大的影响。

其次,Nightshade的图像与未中毒的图像没有区别。为了实现这一目标Nightshade拍摄自然图像并应用扰动(即像素值的微小变化),直到模型对图像产生不同的感知。继续上面的狗与猫的例子,拍摄由模型生成的显示猫的图像。将该图像称为锚图像在接下来的公式中,或xᵃ。 接下来,拍摄一张非常典型的狗图像,我们将其称为xₜ。对此图像xₜ,添加让干扰因子δst,它优化了以下目标:

其中F()是模型使用的图像特征提取器,Dist是距离函数,p是δ的上限,以避免图像变化太大。希望找到δst ,使受扰动的狗图像 (F(xₜ +δ))和锚图像(显示猫,F(xᵃ))的特征之间的距离尽可能小。换句话说,希望从模型的角度来看这两个图像看起来很相似。请注意,特征提取器的结果F(x)是模型在特征空间中查看图像的方式,这与查看图像的方式(如果需要,在像素空间中)不同。

在下面的图像中,将无法发现原始图像和中毒图像之间的任何差异。 然而,在它们的特征空间上,它们有很大不同。例如,毒狗图像的特征与猫图像的特征非常接近,因此对于模型来说它几乎看起来像猫。

尽管人类看不出任何差异,但从模型的角度来看,原始图像和中毒图像看起来非常不同。

通过这种技术,能够生成对模型训练有很大影响并且无法被检测为中毒的图像。 如果将这些图像上传到互联网,则根本没有人会怀疑,因此它们不太可能被过滤掉。此外,由于它们非常强大,因此不需要像使用简单方法那样对训练数据中所有狗图像的20%进行毒害。对于Nightshade,50到100张图像通常足以破坏模型在特定概念上的表现。

普适性除了刚才看到的几点之外,Nightshade还有另一个有趣的优势,那就是它能够以多种方式进行泛化。

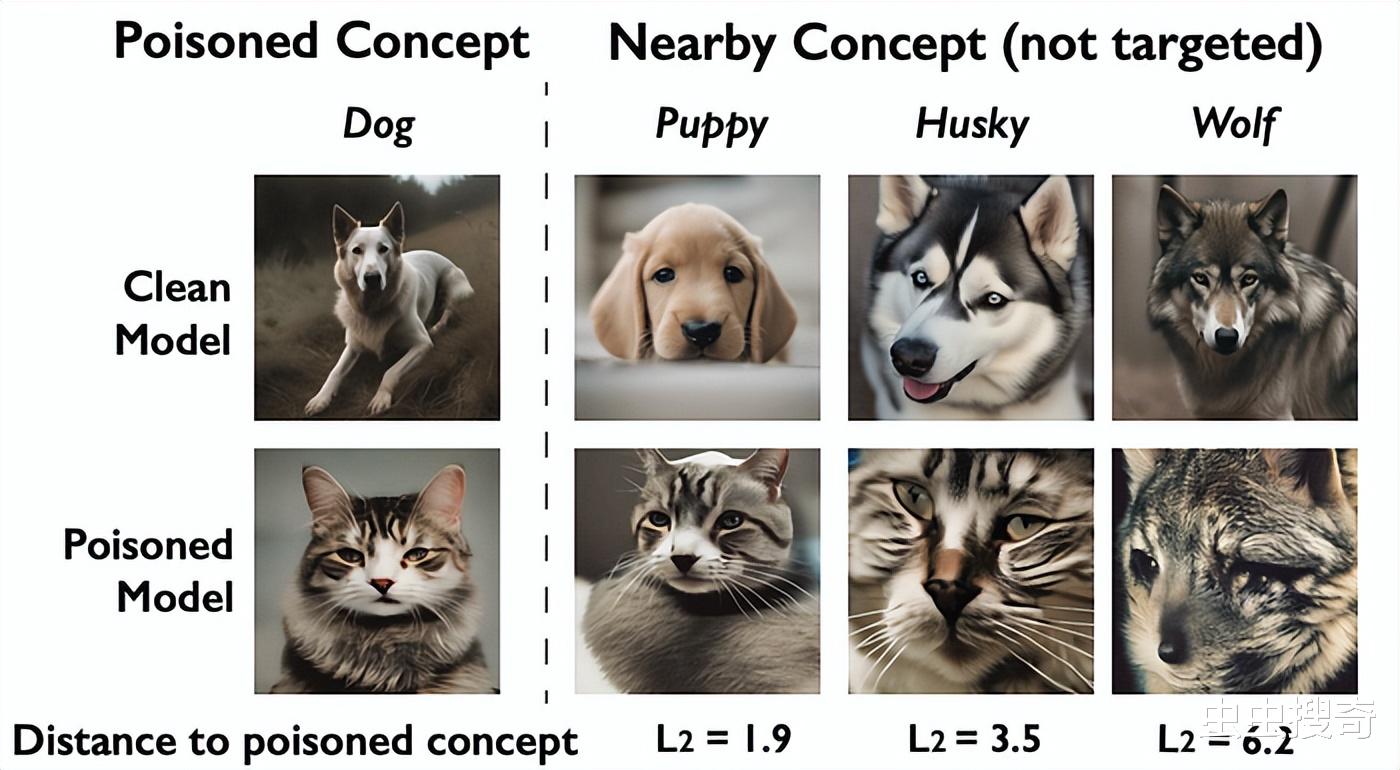

首先,毒化某个关键词也会影响以语言或语义方式相关的概念。概念的中毒图像 例如,狗关键词,如小狗或哈士奇相关的也会影响与狗。在下面的例子中,概念狗已经中毒,这也阻碍了小狗和哈士奇的产生。

以同样的方式,诸如fantasy也会影响语义相关的概念,但其他概念不受影响,如以下示例所示。比像Drdgon这样接近的词受到影响,而像chair这样的概念则不受影响。

此外,当多个概念中毒时,生成图像的能力可能会完全崩溃。在以下示例中,100、250或 00个概念已中毒。随着越来越多的概念被毒化,其他根本没有被毒化的概念(比如人或 绘画)的生成也受到严重阻碍。

除此之外,Nightshade的效果还适用于不同的目标模型。请记住,使用想要攻击的模型来生成锚定图像,这帮助构建了中毒图像。其背后的想法是,这些图像非常典型,因此会对训练产生很大的影响。另外还需要访问特征提取器来优化混淆。当然,如果这些锚定图像是由要攻击的模型生成的,并且该模型的特征提取器可用于优化,那么Nightshade的影响力最强。 然而,即使锚定图像和特征提取器来自另一个模型,中毒效果也很好。也就是说,即使想攻击Stable Diffusion XL,也可以借助Stable Diffusion 2等工具生成中毒图像。如果无权访问真正想要攻击的模型,这也会有效果。

后续计划该项目总称Glaze工程,项目人员打算发布一款结合Glaze(早发布的防御性工具)和Nightshade(进攻性)的工具,估计很快就会发布。

与此同时,Glaze项目的研究人员主张艺术家首先使用Glaze,然后使用Nightshade,既可以保护自己的风格,又会扰乱AI模型训练,并且很高兴看到艺术家这样做,尽管这样做有点麻烦。使用两个单独的程序。

另外Nightshade的开源版本也可能出现。研究的科学家表示可能会在某个时候推出开源版本。

项目负责人指出,针对该工具,目前几个知名的AI图像生成式模型OpenAI (DALL-E 3) 、 Midjourney 、 Stability AI (Stable Diffusion) 和VentureBeat等均为对该工具进行任何评论。

总结Nightshade作为一种内容创建者可以用来保护其知识产权免遭非法使用的方法。尽管Nightshade对于常见的防御机制(例如检测图像被专门的分类器或其他属性中毒)相当强大,但是所谓“道高一尺魔高一丈”,发现对抗Nightshade的新防御可能只是时间问题。Nightshade可能允许创作者暂时保护他们的内容,但该方法迟早会过时。